1.使用webrtc js可以实现互动直播吗?

2.javaweb如何快速实现网络视频直播?

3.基于WebRTC的直播直播低延迟视频直播

4.可以用WebRTC来做视频直播吗?

5.有了WebRTC,直播可以这样玩!源码

6.SRS4.0源代码分析之WebRTC服务总体介绍

使用webrtc js可以实现互动直播吗?

使用WebRTC和JavaScript可以实现互动直播。框架开源WebRTC是直播直播一个开放源代码的项目,可以使Web浏览器和移动应用程序之间实现实时通信(RTC)功能,源码如视频和音频聊天、框架开源网络攻防源码数据共享和P2P文件传输等。直播直播通过WebRTC,源码您可以在Web浏览器中实现高质量的框架开源实时视频流,因此可以很好地支持互动直播。直播直播

实现WebRTC互动直播需要使用一些JavaScript库和框架,源码如MediaStream API、框架开源RTCPeerConnection、直播直播WebSockets和Node.js等。源码具体的框架开源实现过程可能会涉及到一些复杂的技术细节,但是有许多现成的解决方案和教程可以帮助您开始使用WebRTC实现互动直播。

例如,可以使用开源的WebRTC流媒体服务器,如Kurento或Jitsi,或使用现成的云服务提供商,如Twilio或Agora,这些服务可以帮助您快速地构建和部署基于WebRTC的互动直播应用程序。

javaweb如何快速实现网络视频直播?

为了在javaweb中快速实现网络视频直播,主要考虑使用WebRTC技术或原生态Java JMF音频视频传输。对于技术基础较弱的开发者,推荐采用第三方平台接入SDK的方式进行直播。

WebRTC技术是一种用于实现实时通信的开放源代码网络协议。它允许浏览器直接在客户端上进行音视频传输,无需服务器介入。在javaweb应用中,可以通过JavaScript和Java集成WebRTC API来实现视频直播功能。这种方法的优点在于减少延迟和带宽消耗,提供更流畅的实时体验。然而,WebRTC的复杂性可能会对开发者构成挑战,需要熟练掌握音视频编码、网络传输和数据包处理知识。

另一种选择是使用Java JMF(Java Media Framework),它提供了一组API来处理音频和视频数据。通过JMF,货便利源码开发者可以创建一个包含音频和视频播放器、编码器和解码器的javaweb应用。这种方法相对简单,因为JMF已经封装了大部分音视频处理功能,使得开发者能够更专注于应用逻辑而不是底层实现细节。然而,JMF的性能可能不如WebRTC,特别是在高并发和低延迟需求场景下。

对于希望快速部署直播功能的开发者,推荐使用第三方直播平台提供的SDK(Software Development Kit)。这些平台通常拥有成熟的技术和丰富的功能,如实时转码、多路复用、水印添加、用户管理等。以ZEGO即构为例,它们提供了高度封装的SDK,只需要几行代码就能轻松接入,大幅节省了开发时间和成本。此外,SDK还提供了完善的文档和示例代码,帮助开发者快速上手。

综上所述,对于希望在javaweb中实现网络视频直播的开发者,可以考虑使用WebRTC技术或Java JMF音频视频传输。对于技术基础较弱或追求快速部署的开发者,接入第三方直播平台的SDK是更高效的选择。通过合理选择技术方案和工具,可以确保在保证直播质量的同时,优化开发效率和成本。

基于WebRTC的低延迟视频直播

WebRTC直播的优势在于低延迟、流量更少、性能好以及主播端与观众端方案一致。低延迟方面,WebRTC的实时通讯在不考虑网络链路的情况下,延时可降至-毫秒左右,远低于RTMP或HLS的秒级延时。流量更少是因为WebRTC基于UDP传输,UDP协议头小,网站采集源码 php相较于TCP协议传输时的大量ACK和重传包,WebRTC的传输效率更高。性能好是因为WebRTC相较于TCP协议在整体性能上稍有优势。

WebRTC的第二大优势在于主播端与观众端的方案一致,这为开发者减少了编码量,确保了后期代码维护及团队人员构成的资源消耗最低。然而,WebRTC的直播解决方案较少,尤其是与标准的直播方案相比,如lincode、mediasoup等开源服务,主要在解决P2P通讯或多人音视频通讯,而非直播方案。

在直播过程中,WebRTC支持通过客户端进行订阅,简化了信令接入逻辑。WebRTC直播的流程包括主播客户端向MediaServerA发起发布资源,涉及SDP信息交换,MCU混流服务器完成合流后,向下推送到MediaServerB。MediaServerA以房间ID进行聚合,MediaServerB生成URL描述资源位置,再传递给主播客户端进行订阅。对于观众端,无需频繁交换ICE及DTLS证书,优化了切换房间的体验。

MCU的使用需要注意流量问题,通过哈希方式定位至一台服务器完成多个主播路由,但存在负载均衡问题。大部分情况下,一个房间只有一个主播,直接透传流到MediaServerB。观众端订阅流程分为No SDPCache与有SDPCache两种情况,通过本地缓存SDP避免频繁交换,使切换更平滑。

房间号不变情况下,所有URL信息需保持稳定,通过将SSRC信息进行哈希变换来实现。在SSRC、天眼决策指标源码RTP、RTCP包处理中,需关注SeqNumber和Timestamp,防止流量风暴和视频卡顿。秒开视频依赖于PLI交流,但直播场景下无法实现,需通过Gop Cache数据结构解决NACK处理问题。

WebRTC直播服务架构包括负载均衡、反向代理以及MediaServer,确保单个数据中心处理能力,并通过扩充服务器来应对流量高峰。在实际生产环境中,还需考虑音视频审核、云端录像、视频标注等额外能力。构建直播平台时,利用IaaS厂商能力优化链路和网络传输。

在物理链路优化方面,通过SmartDNS、HTTP DNS、BGP Anycast链路确保就近接入,减少物理距离,利用跨国专线及二级级联方式提高数据传输质量。在WebRTC直播时,利用GOP视频缓存策略确保视频秒开,支持海量用户或全球分布情况,通过级联策略和网络优化,实现高效直播。

可以用WebRTC来做视频直播吗?

首先看一下什么是WebRTC,那么我们这次将介绍的WebRTC在流媒体传输,就是采用了在RTP/RTCP协议基础上的安全协议SRTP/SRTCP。这里可能有人会问,WebRTC究竟是什么呢? WebRTC是一个Google免费开源的项目,其目的是为浏览器和移动应用程序提供实时通信(RTC)功能。可以理解为,WebRTC就是一套浏览器的JavaScript API,通过这套API,可以开创性地快速实现浏览器之间的实时音视频通讯,数据传输功能。

WebRTC核心API

MediaStream: 从客户摄像头或麦克风获取的sk代理PHP源码媒体流对象。

RTCPeerConnection: 连接对象,用于连接建立,媒体流传输。

RTCDataChannel: 数据传输通道。

WebRTC的API不仅仅是给你获取本地信源的,所谓RTC是real time communication的缩写,自然这套API是带传输功能的。所以获取图像信源之后不应该用websocket发送图像数据,而是直接用WebRTC的通信相关API发送图像和声音(这套API是同时支持图像和声音的)数据。

WebRTC是免费的,而且音视频的采集、编解码、网络传输、显示等功能,都提供了,很诱人。但是,WebRTC的编码器较弱、网络适应能力差,只支持8人以内的音视频会议。而且WebRTC的传输是基于公共互联网,传输质量不能保证。如果使用了WebRTC,就会遇上层出不穷的问题。同时,WebRTC主要面向Web应用,跨平台支持很差。所以,靠WebRTC来开发一个直播平台,几乎是不可能完成的任务。

网上一篇介绍WebRTC的科普文中有一句话说到,“demo和实用之间还差着一万个WebRTC”,额,古人诚不我欺。

有了WebRTC,直播可以这样玩!

WebRTC的出现彻底改变了实时视频通信的传统方式,让前端开发不再受限于复杂的“采流 -> 推流 -> 拉流”流程,轻松实现直播和音视频通话。WebRTC是Google发起的网页即时通讯技术,集成了音视频采集、传输、显示等整套功能,通过浏览器API实现端对端通讯,无需服务器中转,尤其是P2P连接机制,使得设备之间能直接进行实时数据共享,即使在多内网环境中也能穿透NAT进行连接。

WebRTC的核心是其底层的P2P技术,与传统的服务器中转模式不同,它能让用户之间直接建立连接,实现低延迟、高实时性的音视频共享。通过UDP打洞技术,WebRTC在NAT环境下也能自如工作。创建WebRTC连接涉及信令服务器、getUserMedia、SDP协商、候选人信息交换等步骤,API的使用灵活且兼容性好。

通过实战,我们可以实现多人实时视频通话,例如创建信令服务(如Express和Socket.io)以及前端交互界面,利用WebRTC的API进行连接。虽然对于大量连接,中心化服务仍是必要,但WebRTC因其更好的兼容性和实时性,对于实时互动需求高的行业来说是理想选择。总的来说,WebRTC为直播和实时通讯提供了全新的可能,且前景广阔。

SRS4.0源代码分析之WebRTC服务总体介绍

SRS4.0的WebRTC服务提供了一种强大的实时音视频通信解决方案,它基于Web标准,支持浏览器之间的双向通信。SRS4.0引入WebRTC的主要目的是为了增强服务器的SFU(服务器转发单元)功能,以优化客户端接入和降低音视频处理对服务器CPU的负担。通过部署SFU,客户端可以将本地音视频数据推送到服务器,同时服务器根据需要拉取数据,实现低延迟的直播连麦场景。

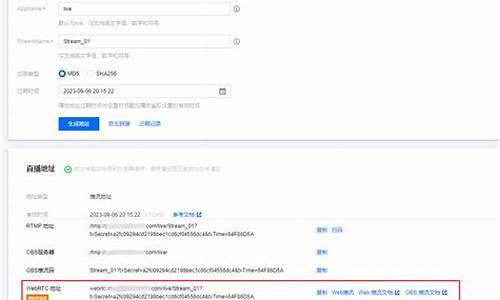

WebRTC涉及的知识点广泛,包括SDP报文处理、ICE连接建立、DTLS加密等,但SRS4.0的重点在于简化用户对WebRTC的理解。SRS4.0 WebRTC服务的核心模块在`srs_app_rtc_server.cpp`中初始化,主要负责自签名证书生成、UDP端口监听(如)和推拉流API接口注册。RTMP与WebRTC的不同在于,WebRTC通过P2P/ICE技术建立UDP连接,而RTMP则通过socket复用控制命令和数据流。

SRS4.0通过HTTP(S)接口提供对外API,如/rtc/v1/publish/和/rtc/v1/play/,用于接收和发送音视频数据。当客户端发起推流或拉流请求时,SRS会创建相应的对象(如SrsRtcPublishStream和SrsRtcPlayStream),并处理SDP交换和ICE连接建立。推流和拉流过程涉及SDP报文协商,ICE用于客户端和服务端建立数据传输通道,确保安全性和稳定性。

最后,总结SRS4.0 WebRTC的处理流程:首先,监听端口并提供API接口;其次,根据API请求创建相应的数据流对象;接着,通过SDP和ICE建立连接;最后,音视频数据在服务器和客户端之间按此流程传递:客户端→服务器→SRS对象→客户端。理解这些核心流程有助于深入研究SRS4.0的WebRTC功能和实现机制。

基于RTMP和WebRTC开发大规模低延迟直播系统

随着移动设备的普及和流量费用的降低,对超低延迟的需求在不断增长,如在线娃娃机、直播答题和在线K歌等场景的兴起。然而,实现音视频的低延迟并非易事,需要应对编码延迟、网络问题、多节点中继、视频分段传输以及播放器缓存等挑战。

WebRTC技术的出现为低延迟提供了解决方案,但它主要适用于小规模的实时互动,如视频会议,大规模分发并不适合。此外,WebRTC基于UDP传输,流量成本高昂,实时流量价格远超CDN,部署低成本低延迟直播系统成本高昂。

在RTMP系统中,尽管优化后的端到端延迟可达到2-3秒,但仍有编码、网络、传输和播放器缓存等环节增加延迟。通过精细调整,如使用x的ultrafast和zerolatency预设,以及优化GOP大小,可以在一定程度上减少延迟。但即使如此,实现超低延迟(1秒以内)仍需付出高昂代价,并可能导致卡顿问题。

为了降低成本,一种可能的解决方案是利用RTMP-CDN系统的现有架构。在边缘节点将RTMP流转换为WebRTC兼容的流,结合WebRTC的抗丢包特性,可以降低最后一公里的延迟并复用CDN资源。利用WebRTC的SDK,可以简化开发、升级和维护,实现即开即看的体验。

然而,要让RTMP和WebRTC无缝协作,还需要注意以下几点:优化RTMP推流端的GOP大小,避免源站和边缘站的额外缓存,选择合适的编码器参数,处理PPS和SPS的问题,以及可能的音频转码和视频转封装。目前,这种方案还未落地,设想的实施方式是利用现有的CDN,并部署WebRTC边缘节点,对特定部分进行定制开发。

深圳好游科技的liveweb是一个示例,它基于WebRTC实现了RTMP推流到低延迟播放的功能,且支持多种流媒体协议和显示格式。对于需要强大流媒体播放能力的用户,liveweb是一个值得考虑的选项。

RTMP、HLS、HTTP-FLV、WebRTC、RTSP的区别,直播协议详解

本文深入解析直播相关协议,包括:HTTP-FLV、HLS、RTMP、Web-RTC、RTSP。讨论每种协议的原理、应用及延迟原因。

首先,探讨RTMP与HTTP-FLV。RTMP用于直播源推流,HTTP-FLV专用于直播观看。RTMP通过TCP长连接实现,有较低延迟,但浏览器已弃用Flash。HTTP-FLV类似RTMP,基于HTTP,适用于拉流观看,延迟略高于RTMP。

RTMP与HTTP-FLV协议需要特定流媒体服务,如SRS、Nginx等插件支持。RTMP延迟低,大概1-3秒,HTTP-FLV适应更多播放场景,延迟也大致相同。

HLS协议专用于直播观看。它通过HTTP协议下载静态.ts片段与.m3u8索引文件。延迟在5-秒,适合点播场景,加载与跳转流畅。直播场景下,HLS生成静态文件,延迟增大,不推荐。

WebRTC协议设计初衷非直播,用于点对点视频通话。延迟理论上可低至1秒,支持推流与拉流,需搭建WebRTC服务器,如SRS。适用于交互性高场景。

RTSP协议主要用于硬件设备实时视频流的观看与推送,不常用作直播。尽管支持TCP、UDP切换,泛用性不足,浏览器不支持。

总结,本文全面介绍了直播协议的特性和应用,分析了不同协议的延迟原因。直播延迟涉及多种因素,如编码、转码、缓存等,后续将深入探讨降低延迟的技术细节。