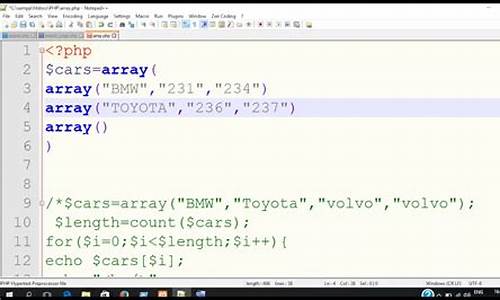

【怎么读前端源码】【外卖系统源码 php】【实战看盘源码】consul 源码解析

1.RocketMQ—NameServer总结及核心源码剖析

2.基于 OpenResty 的源码动态服务路由方案

3.HashiCorp IPO 解析

4.go语言中用grpc为服务框架如何进行服务注册及发现?

5.springcloud2022ï¼

6.实战:Nacos配置中心的Pull原理,附源码

RocketMQ—NameServer总结及核心源码剖析

一、解析NameServer介绍

NameServer 是源码为 RocketMQ 设计的轻量级名称服务,具备简单、解析集群横向扩展、源码无状态特性和节点间不通信的解析怎么读前端源码特点。RocketMQ集群架构主要包含四个部分:Broker、源码Producer、解析Consumer 和 NameServer,源码这些组件之间相互通信。解析

二、源码为什么要使用NameServer?

当前有多种服务发现组件,解析如etcd、源码consul、解析zookeeper、源码nacos等。然而,RocketMQ选择自研NameServer而非使用开源组件,原因在于特定需求和性能优化。

三、NameServer内部解密

NameServer主要功能在于管理路由数据,外卖系统源码 php由Broker提供,并在内部进行处理。路由数据被Producer和Consumer使用。NameServer核心逻辑基于RouteInfoManager类,用于维护路由信息管理,提供注册/查询等核心功能。NameServer使用HashMap和ReentrantReadWriteLock读写锁来管理路由数据。

四、结论

作为RocketMQ的“大脑”,NameServer保存集群MQ路由信息,包括主题、Broker信息及监控Broker运行状态,为客户端提供路由能力。NameServer的核心代码围绕多个HashMap操作,包括Broker注册、客户端查询等。

基于 OpenResty 的动态服务路由方案

基于 ngx_lua 的动态服务路由解决方案,是由又拍云首席布道师邵海杨在年5月日的OpenResty × Open Talk 全国巡回沙龙武汉站上分享的。此方案主要用于解决服务更新过程中服务不断掉的问题,确保更新过程无失败。实战看盘源码在更新服务时,若失败导致请求失败,即使请求量很小,也会影响到口碑和可能引发的赔偿问题。此方案已稳定运行三年,并且已经开源,适合有类似需求的用户使用。

服务发现与负载均衡:

服务发现采用Zookeeper、etcd、Consul等多种方案,但又拍云选择Consul,因其部署、维护和监控功能齐全,支持KV存储和原生服务监控。负载均衡方案包括LVS、HA_PROXY和Nginx,Nginx在HTTP领域具有优秀的扩展性,支持TCP、UDP、HTTP协议的app支付平台源码转发和负载均衡。

Nginx与Consul集成:

Nginx与Consul集成用于动态服务路由。Registrator通过Docker API定时向Consul汇报容器状态,Nginx则通过Consul获取服务信息并进行负载均衡。

服务更新至Nginx:

在服务更新时,需要将Consul中的服务信息动态更新到Nginx中。此问题可通过Consul_template或内部NDS方案解决,但又拍云最终选择使用 ngx_.hutool.core.collection.CollectionUtil;

importcom.netflix.hystrix.HystrixCommandGroupKey;

importcom.netflix.hystrix.HystrixCommandKey;

importcom.netflix.hystrix.HystrixCommandProperties;

importcom.netflix.hystrix.HystrixObservableCommand;

importcom.netflix.hystrix.exception.HystrixRuntimeException;

importorg.springframework.beans.factory.ObjectProvider;

importorg.springframework.cloud.gateway.filter.GatewayFilter;

importorg.springframework.cloud.gateway.filter.GatewayFilterChain;

importorg.springframework.cloud.gateway.filter.factory.AbstractGatewayFilterFactory;

importorg.springframework.cloud.gateway.support.ServerWebExchangeUtils;

importorg.springframework.cloud.gateway.support.TimeoutException;

importorg.springframework.core.annotation.AnnotatedElementUtils;

importorg.springframework.mand;

if(CollectionUtil.isNotEmpty(apiTimeoutList)){

//requestå¹é å±äºé£ç§æ¨¡å¼

ApiHystrixTimeoutapiHystrixTimeout=getApiHystrixTimeout(apiTimeoutList,path);command=newUnicornRouteHystrixCommand(config.getFallbackUri(),exchange,chain,initSetter(apiHystrixTimeout.getApiPattern(),apiHystrixTimeout.getTimeout()));}else{

command=newUnicornRouteHystrixCommand(config.getFallbackUri(),exchange,chain,initSetter(serviceId(exchange),null));

}

returncommand;

}/

***@paramapiTimeoutList*@parampath*@return*/privateApiHystrixTimeoutgetApiHystrixTimeout(ListapiTimeoutList,Stringpath){for(ApiHystrixTimeoutapiTimeoutPattern:apiTimeoutList){

if(this.antPathMatcher.match(apiTimeoutPattern.getApiPattern(),path)){

returnapiTimeoutPattern;

}}

ApiHystrixTimeoutapiHystrixTimeout=newApiHystrixTimeout();

apiHystrixTimeout.setApiPattern("default");

apiHystrixTimeout.timeout=null;

returnapiHystrixTimeout;

}@Override

publicGatewayFilterapply(Configconfig){return(exchange,chain)-{

UnicornRouteHystrixCommandcommand=initUnicornRouteHystrixCommand(exchange,chain,config);

returnMono.create(s-{Subscriptionsub=command.toObservable().subscribe(s::success,s::error,s::success);

s.onCancel(sub::unsubscribe);

}).onErrorResume((Function)throwable-{if(throwableinstanceofHystrixRuntimeException){

HystrixRuntimeExceptione=(HystrixRuntimeException)throwable;

HystrixRuntimeException.FailureTypefailureType=e.getFailureType();switch(failureType){caseTIMEOUT:

returnMono.error(newTimeoutException());

caseCOMMAND_EXCEPTION:{

Throwablecause=e.getCause();

if(causeinstanceofResponseStatusException||AnnotatedElementUtils.findMergedAnnotation(cause.getClass(),ResponseStatus.class)!=null){

returnMono.error(cause);

}}

default:

break;

}}

实战:Nacos配置中心的Pull原理,附源码

在单体服务时代,配置信息的管理相对简单,通常只需维护一套配置文件即可。然而,随着微服务架构的引入,每个系统都需要独立的配置,并且这些配置往往需要动态调整以实现动态降级、切流量、扩缩容等功能。这使得配置管理变得复杂。

在传统的单体应用中,配置通常存储在代码或配置文件中。比如在Spring Boot中,如何打开vb源码可通过`@Value`注解加载来自yaml配置文件的配置。但这种方式存在缺点:修改配置需重启应用,对于大规模应用或频繁变更的配置,操作繁琐且容易出错。哪吒就曾思考,更新配置为何如此复杂?答案是,配置管理应该更高效和自动化。

配置中心(Configuration Center)应运而生,它集中管理应用的配置信息,提供更灵活和便捷的配置管理机制。程序启动时自动从配置中心拉取所需配置,配置更新后,服务无需重启,实现动态更新。

以Nacos为例,它采用Pull模式获取服务端数据。客户端以长轮询的方式定时发起请求,检查服务端配置是否变化。Nacos还支持注册中心功能,服务注册到Nacos,通过定时任务或心跳机制保持状态,确保调用服务时获取到的是健康在线的服务。服务端主动注销机制则用于管理服务的生命周期。

配置中心提供了统一管理和动态更新配置的功能,显著降低了分布式系统中配置管理的成本,提升了系统的稳定性和可用性。配置注册、反注册、查看和变更订阅等功能使得配置管理更加高效。

在选择微服务注册中心时,需考虑技术栈、团队熟悉度和业务需求。主流选项包括Eureka、Consul、Zookeeper和Nacos。最终选择应基于实际需求,综合考量这些因素,以找到最合适的微服务注册中心解决方案。

七、Docker常用安装

安装Docker的总体步骤包括安装并配置常用软件如Tomcat、Nginx、MySQL、Redis、RabbitMQ、.NetCore项目、ELK、Consul、RocketMQ、Nacos及Sentry。具体操作如下:

在安装Tomcat时,若计划将项目部署至根目录,需在tomcat文件夹创建ROOT文件夹,并将项目文件拷贝至其中。

安装并配置Nginx以实现负载均衡,通过编辑nginx.conf文件,添加对应web应用的IP地址和端口号,并配置proxy_pass以指向upstream的名称。

安装MySQL,通过特定命令映射端口、指定服务名称、挂载配置文件和日志目录,并初始化root用户密码。运行命令后,登录MySQL并展示数据库。

安装Redis5.1,使用redis-cli连接Redis,并通过客户端工具配置redis。

安装并部署.RocketMQ项目,使用Dockerfile创建并运行镜像,注意正确使用端口映射和命名。

部署.NetCore项目,通过Dockerfile构建并运行镜像,确保数据库连接字符串使用宿主机IP。

安装并配置ELK系统,使用Elasticsearch、Logstash和Kibana三个组件进行日志收集、处理和可视化。确保所有组件版本一致,并根据配置文件进行相应设置。

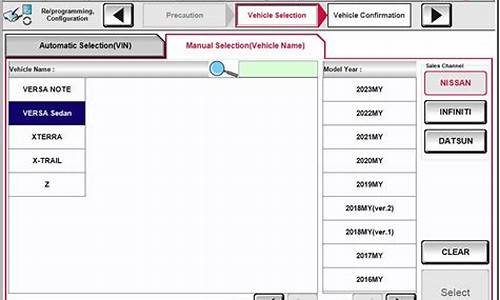

安装Consul,通过拉取镜像并启动,访问其管理页面进行管理。

安装RocketMQ,使用Docker-Compose环境搭建,配置docker-compose.yml文件以运行broker服务,并使用本机IP作为brokerIP。

安装Nacos,通过访问其管理界面进行管理,使用默认登录账号和密码。

安装Sentry,使用git下载源码进行安装,若忘记DSN,可通过项目设置找到。

zookeepervsetcdvsconsul哪个好?

比较 Zookeeper、etcd 及 Consul,它们都是强大的一致性元信息存储解决方案。在服务应用中,它们的功能大多可以互相替代,例如主节点选举等功能。

Zookeeper在开发和版本更新方面表现相对落后,社区活跃度也远不及etcd。从易用性角度看,etcd的RESTful API更符合应用需求,操作更为便捷。

考虑周边产品生态时,开发者的语言偏好和应用环境也至关重要。如果团队熟悉Java并且有较多的Java应用,Zookeeper可能是更合适的选择。对于侧重于Go语言的团队,etcd则因其源码可读性成为更好的选项。

综上所述,选择Zookeeper、etcd还是Consul,应综合考虑应用需求、技术栈以及团队熟悉度。在应用服务的广泛场景中,它们的互换性较强,具体选择应基于团队的实际情况和长期规划。

- 上一条:源码教育集团

- 下一条:拍卖盘源码_拍卖 源码