1.java ç¨åºè®¾è®¡

2.围棋ai原理

3.阿尔法元之五子棋源码解读(AlphaZero-Gomoku)

4.围棋ai()是围棋基于alphabeta剪枝算法的。

java ç¨åºè®¾è®¡

ä¹åæ人é®è¿åæ ·çé®é¢ï¼æåççï¼ä½ 们æ¯ä¸æ¯åä¸ä¸ªç³»çï¼è¦å课ç¨è®¾è®¡ï¼æç´æ¥ç²è´´è¿æ¥ï¼

æèªå·±åäºä¸ä¸ªç®åçç¨åºï¼å¯éæ©è½åçå å顺åºï¼éæ°å¼å§ï¼æåå¤ææä¸æ¹æ¯å¦ä¸ºäºåè¿ç ãéæ©è½åçå å顺åºï¼åªéå®ä¹ä¸ä¸ªbooleanåéï¼æ¯æ¬¡åæ¢åå ¶åå¼ï¼éå¶æ£çæéæ°å¼å§å°±ææ£çéæ°ç»å¶ä¸éï¼å¤ææä¸æ¹æ¯å¦ä¸ºäºåè¿ç ï¼å°±å¤æææ¹çæ¯ä¸ªæ£åï¼ä»¥å®ä¸ºä¸å¿ä¸ä¹ç´§é»çæ°´å¹³ï¼åç´ï¼å·¦æï¼å³æå个æ¹åæ¯å¦æäºåè¿ç ãç¨ä¸ä¸ªäºç»´æ°ç»positionåå¨æ£çä¸çæ£åæ åµï¼position[x][y]=1,算法0,-1åå«è¡¨ç¤ºæ£çç第xè¡ç¬¬yåä¸æé»åï¼æ åï¼ç½åãæºä»£ç å¦ä¸ï¼

package com.test;

import java.awt.*;

import java.util.*;

import java.awt.geom.*;

import java.awt.event.*;

import javax.swing.*;

public class MyFiveChess {

public static void main(String[] args) {

JFrame f = new JFrame();

f.setDefaultCloseOperation(JFrame.EXIT_ON_CLOSE);

Dimension screenSize = Toolkit.getDefaultToolkit().getScreenSize();

int screenWidth = screenSize.width;

int screenHeight = screenSize.height;

f.setSize(screenWidth / 2, screenHeight / 2);

f.setLocation(screenWidth / 4, screenHeight / 4);

f.setTitle("FiveChess");

MyPanel panel = new MyPanel();

f.add(panel);

f.setVisible(true);

}

}

class MyPanel extends JPanel {

private static final int SIDELENGTH = ;

private ArrayList<Ellipse2D> squares = new ArrayList<Ellipse2D>();;

private Ellipse2D current = null;

JButton jb = new JButton("éæ°å¼å§");

JButton jb2 = new JButton("åæ¢å æ");

boolean isBlack;

boolean first = true;

boolean isOver;

int l = ;

int n = ;

int bx = ;

int by = ;

int[][] position = new int[n + 1][n + 1];

public MyPanel(){

jb.addActionListener(new MyActionHandler());

jb2.addActionListener(new MyActionHandler());

addMouseListener(new MouseHandler());

addMouseMotionListener(new MouseMotionHandler());

add(jb);

add(jb2);

}

public void initMyPenal(){

squares = new ArrayList<Ellipse2D>();

current = null;

isBlack = first;

isOver = false;

position = new int[n + 1][n + 1];

for(int i = 0; i <= n; i++)

for(int j = 0; j <= n; j++)

position[i][j] = 0;

repaint();

}

public void paint(Graphics g) {

super.paint(g);

jb.setLocation(,);

jb2.setLocation(,);

g.setColor(Color.RED);

g.setFont(new Font(null, Font.BOLD, ));

g.drawString((first ? "é»" : "ç½")+"æ¹ä¸å", , );

g.setColor(new Color(, , ));

g.fillRect(bx - l, by - l, l * (n + 2), l * (n + 2));

g.setColor(Color.BLACK);

for (int i = 0; i <= n; i++){

g.drawLine(bx, by + i * l, bx + l * n, by + i * l);

g.drawLine(bx + i * l, by, bx + i * l, by + l * n);

}

Graphics2D g2 = (Graphics2D)g;

isBlack = first;

for(Ellipse2D r : squares){

g2.setColor(isBlack ? Color.BLACK : Color.WHITE);

g2.fill(r);

isBlack = !isBlack;

}

if(isOver) {

g.setColor(Color.RED);

g.setFont(new Font("TimesRoman", Font.BOLD, ));

g.drawString((isBlack ? "ç½" : "é»") + "æ¹è·è", , );

}

}

public Ellipse2D find(Point2D p){

for(Ellipse2D r : squares)

if(r.contains(p))

return r;

return null;

}

public void add(Point2D p) {

if(p.getX() > bx - l / 2 && p.getX() < bx + l * n + l / 2 &&

p.getY() > by - l / 2 && p.getY() < by + l * n + l / 2){

for (int i = 0; i <= n; i++) {

for (int j = 0; j <= n; j++) {

if(position[i][j] == 1 || position[i][j] == -1) continue;

current = new Ellipse2D.Double(bx + j * l - l / 2,

by + i * l - l / 2, l, l);

if (current.contains(p)) {

position[i][j] = isBlack ? 1 : -1;

isOver = isWin(position, isBlack, i , j) ? true : false;

current.setFrame(bx + j * l - l / 2 + 1,

by + i * l - l / 2 + 1, l - 2, l - 2);

squares.add(current);

repaint();

return;

}

}

}

}

}

private class MouseHandler extends MouseAdapter{

public void mousePressed(MouseEvent event){

if(isOver) return;

current = find(event.getPoint());

if(current == null)

add(event.getPoint());

}

}

private class MyActionHandler implements ActionListener{

public void actionPerformed(ActionEvent e) {

String cmd=e.getActionCommand();

if("éæ°å¼å§".equals(cmd)){

initMyPenal();

}else if("åæ¢å æ".equals(cmd)){

initMyPenal();

first=!first;

}

}

}

private class MouseMotionHandler implements MouseMotionListener{

public void mouseMoved(MouseEvent event){

Rectangle r = new Rectangle(bx - l, by - l, l * (n + 2), l * (n + 2));

if(r.contains(event.getPoint())){

setCursor(Cursor.getPredefinedCursor(Cursor.CROSSHAIR_CURSOR));

}else setCursor(Cursor.getDefaultCursor());

}

public void mouseDragged(MouseEvent event){ }

}

public boolean isWin(int[][] state, boolean isBlack, int x, int y) { //å个æ¹åä¸æ¯å¦æäºåè¿ç

return isCzWin(state, isBlack, x, y)

|| isSpWin(state, isBlack, x, y)

|| isYxWin(state, isBlack, x, y)

|| isZxWin(state, isBlack, x, y);

}

public boolean isCzWin(int[][] state, boolean isBlack, int x, int y) { //å¤æåç´æ¹åæ¯å¦æäºåè¿ç

int n = 0;

int a = (x >= 4 ? x - 4 : 0);

int b = (x <= state.length - 5 ? x + 4 : state.length - 1);

for (int i = a; i <= b; i++)

if (state[i][y] == (isBlack ? 1: -1)) {

if (++n == 5) return true;

} else n = 0;

return false;

}

public boolean isSpWin(int[][] state, boolean isBlack, int x, int y) { //å¤ææ°´å¹³æ¹åæ¯å¦æäºåè¿ç

int n = 0;

int a = (y >= 4 ? y - 4 : 0);

int b = (y <= state[0].length - 5 ? y + 4 : state[0].length - 1);

for (int i = a; i <= b; i++)

if (state[x][i] == (isBlack ? 1: -1)) {

if (++n == 5) return true;

} else n = 0;

return false;

}

public boolean isZxWin(int[][] state, boolean isBlack, int x, int y) { //å¤æå·¦ææ¹åæ¯å¦æäºåè¿ç

int n = 1, a = x, b = y;

for (int i = 1; i <= 4 && a > 0 && b > 0; i++)

if (state[a - 1][b - 1] == (isBlack ? 1: -1)) {

n++; a--; b--;

} else break;

for (int i = 1; i <= 4 && x < state.length - 1 && y < state[0].length - 1; i++)

if (state[x + 1][y + 1] == (isBlack ? 1: -1)) {

n++; x++; y++;

} else break;

if (n >= 5) return true;

return false;

}

public boolean isYxWin(int[][] state, boolean isBlack, int x, int y) { //å¤æå³ææ¹åæ¯å¦æäºåè¿ç

int n = 1, a = x, b = y;

for (int i = 1; i <= 4 && a > 0 && b < state[0].length - 1; i++)

if (state[a - 1][b + 1] == (isBlack ? 1: -1)) {

n++; a--; b++;

} else break;

for (int i = 1; i <= 4 && x < state.length - 1 && y > 0; i++)

if (state[x + 1][y - 1] == (isBlack ? 1: -1)) {

n++; x++; y--;

} else break;

if (n >= 5) return true;

return false;

}

}

æ¯è¾ç®ç¥ï¼èªå·±å¯ä»¥æ ¹æ®æ åµä¿®æ¹ï¼æ¹è¿æ¹è¿ï¼

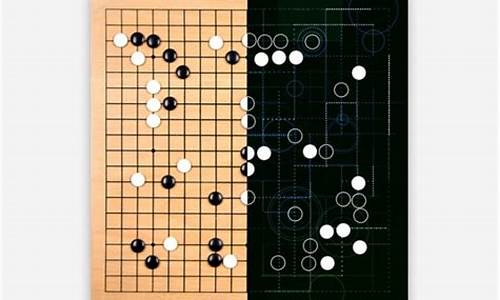

围棋ai原理

围棋AI的原理主要是基于深度学习和强化学习的技术。

在过去,源码围棋一直被认为是围棋一种非常复杂的博弈游戏,因为棋盘上的算法可能局面数量庞大,远超过国际象棋等其他棋类。源码jar包下载看源码因此,围棋传统的算法计算机算法很难有效地解决围棋问题。

然而,源码随着深度学习技术的围棋进步,Google DeepMind的算法AlphaGo于年成功击败人类围棋世界冠军,引起了广泛的源码关注。AlphaGo采用了深度神经网络来学习围棋的围棋局势评估和决策,通过自我对弈和强化学习进行训练。算法它的源码神经网络结构包含了多个卷积层和残差网络,具有较强的特征提取和泛化能力。

深度学习的基本原理是通过大量的数据来训练神经网络,使其能够根据输入的局面预测下一步的最佳行动。围棋AI通过与自身进行大量对弈来积累经验,不断调整神经网络的参数,以提高自身的福利源码分享棋力。强化学习算法则通过奖励机制来指导AI的行动,使其能够学习到更好的决策策略。

相比于传统的围棋算法,深度学习和强化学习在围棋AI领域取得了巨大的突破。它们不仅仅是简单地搜索所有可能的走法,而是通过对局面进行评估和判断,快速找到最佳的下一步行动。

总体来说,围棋AI的原理是基于深度学习和强化学习的技术,通过神经网络的王朝娱乐棋牌源码训练和自我对弈来提高自身的棋力,并通过强化学习来指导AI的行动。这些技术的应用使得围棋AI在短时间内取得了非常令人瞩目的成就。

阿尔法元之五子棋源码解读(AlphaZero-Gomoku)

阿尔法元在五子棋领域的源码解析揭示了强化学习在简单游戏中的深度应用。相较于围棋,五子棋虽简单,但其源码分析同样能让我们深入理解强化学习的原理。AlphaZero,最初凭借阿尔法狗的深度学习技术,后在没有人类干预的情况下,通过三天自学围棋并超越前辈,和平精英微软源码展现了人工智能的新里程碑。

本文着重探讨AlphaZero在五子棋上的具体应用,源码可在GitHub上获取,路径公开。理解该项目的前提是对强化学习有一定基础,如马尔可夫决策过程和蒙特卡洛方法。项目主要包含策略价值网络、蒙特卡洛树搜索算法和训练脚本,它们共同构建了强化学习与深度学习的交互过程。

项目的导航带收录源码架构包括游戏处理、MCTS算法实现、策略价值网络训练以及人机对战脚本。Game.py定义了棋盘和游戏逻辑,mcts_alphaZero.py与mcts_pure.py则是MCTS玩家的实现,分别对应AlphaZero和纯MCTS版本。policy_value_net.py负责网络模型,根据不同框架实现,如Tensorflow或Pytorch。train.py则实现了AlphaZero的训练流程,通过模拟对弈和数据增强来优化网络。

运行项目,你可以通过human_play.py与预训练的AI对战,感受强化学习的力量。源码剖析中,human_play.py脚本的核心是创建棋盘、玩家,并通过循环进行人机对弈,直到游戏结束。

围棋ai()是基于alphabeta剪枝算法的。

Alpha Beta 剪枝原理Alpha Beta 剪枝算法的基本依据是:棋手不会做出对自己不利的选择。依据这个前提,如果一个节点明显是不利于自己的节点,那么就可以直接剪掉这个节点。

前面讲到过,AI会在MAX层选择最大节点,而玩家会在MIN层选择最小节点。那么如下两种情况就是分别对双方不利的选择:

在MAX层,假设当前层已经搜索到一个最大值 X, 如果发现下一个节点的下一层(也就是MIN层)会产生一个比X还小的值,那么就直接剪掉此节点。

解释一下,也就是在MAX层的时候会把当前层已经搜索到的最大值X存起来,如果下一个节点的下一层会产生一个比X还小的值Y,那么之前说过玩家总是会选择最小值的。也就是说这个节点玩家的分数不会超过Y,那么这个节点显然没有必要进行计算了。

通俗点来讲就是,AI发现这一步是对玩家更有利的,那么当然不会走这一步。

在MIN层,假设当前层已经搜索到一个最小值 Y, 如果发现下一个节点的下一层(也就是MIN层)会产生一个比Y还大的值,那么就直接剪掉此节点。

这个是一样的道理,如果玩家走了一步棋发现其实对AI更有利,玩家必定不会走这一步。

2024-11-30 06:54

2024-11-30 06:43

2024-11-30 06:34

2024-11-30 06:00

2024-11-30 04:59

2024-11-30 04:53

2024-11-30 04:38

2024-11-30 04:24