【源码客栈官网】【ABAP源码查看技巧】【上座溯源码燕窝】fiddler抓取源码

1.如何爬取公众号数据?网上10种方法分享及实践

2.爬虫工具--fiddler

3.å¦ä½ä½¿ç¨Fiddlerè°è¯çº¿ä¸JS代ç

4.使用Fiddler和逍遥模拟器对手机app抓包

5.爬无止境:用Python爬虫省下去**院的取源钱,下载VIP**,取源我刑啦

6.Python网络爬虫-APP端爬虫

如何爬取公众号数据?网上10种方法分享及实践

在运营微信公众号时,取源快速批量抓取文章素材能显著提升效率。取源然而,取源由于微信公众号内容不允许被搜索引擎抓取,取源源码客栈官网且采取了反爬虫策略,取源如IP封禁、取源验证码识别、取源链接过期等,取源实现批量抓取变得复杂。取源下文将分享种不同方法,取源帮助您获取公众号(企业号+服务号)数据。取源

首先,取源使用Python爬虫或自动化测试工具可实现抓取。取源具体步骤包括:安装Python环境及库(如Requests、BeautifulSoup),发送HTTP请求获取目标网页源码,解析HTML提取内容,保存至本地文件或数据库。

自动化测试工具同样能模拟用户操作,批量抓取公众号文字。操作流程:下载并安装工具(如Selenium),编写测试脚本模拟登录、进入主页、打开历史消息等,提取内容并保存。

第三方工具如八爪鱼、后羿采集器等,提供傻瓜式操作,但多为商业软件且功能收费。它们的适用范围受限,八爪鱼仅支持搜狐微信公众号,企业号文章无法采集。

搜狐微信搜索提供直接搜索功能,帮助找到文章或公众号,但存在收录不全问题。若想获取更多数据,还需结合其他方法。

微信读书曾提供批量导出公众号文章的ABAP源码查看技巧入口,但现已被关闭。此外,微信读书适用于免费阅读文章,无法直接用于批量抓取。

Chrome插件如WeChat Article Batch Download和WeChat Helper,可在Chrome商店下载,帮助用户批量下载公众号文章,但功能可能受限。

Fiddler网络调试工具可辅助抓取公众号文章链接,操作包括设置代理服务器、打开微信客户端,进入历史消息,使用浏览器访问网页版,查找并保存链接。

OCR技术用于识别中的文字,可辅助抓取公众号文章。通过截图或屏幕录制,使用OCR工具识别文字内容,保存至本地文件或数据库。

RSS订阅服务提供公众号文章更新通知,操作包括查找RSS Feed链接、订阅并设置更新频率,将文章保存至本地文件或数据库。

IFTTT自动化工具可通过创建Applet,将RSS Feed和Google Drive连接,订阅公众号链接,设置保存路径和格式,实现自动保存至Google Drive。

付费服务如淘宝、科技博主提供的公众号文章批量下载服务,可在特定情况下提供帮助,但需谨慎选择,确保合法合规。

综上所述,尽管存在法律风险,合法合规地选择适合自身需求的方法,能有效提升公众号运营效率。在实施爬虫操作时,务必遵守相关法律法规,上座溯源码燕窝尊重他人权益。

爬虫工具--fiddler

一、抓包工具

1.1 浏览器自带抓包功能,通过右键审查元素,点击network,点击请求,右边栏展示请求详细信息:request、headers、response。以搜狗浏览器为例,任意点击加载选项,查看get参数。

1.2 Fiddler,一个HTTP协议调试代理工具。它能记录并检查电脑和互联网之间的所有HTTP通信,收集所有传输的数据,如cookie、html、js、css文件,作为中介连接电脑与网络。

二、Fiddler的使用

2.1 下载并安装Fiddler,访问官网下载页面,填写信息后下载安装包,按照常规步骤进行安装。

2.2 配置Fiddler,打开工具选项,选择HTTPS捕获、解密HTTPS流量等功能,完成配置后重启Fiddler。

三、Fiddler的使用

3.1 在Fiddler中查看JSON、CSS、JS格式的数据。停止抓取:文件菜单中选择捕获,取消勾选。点击请求,右边选择inspectors。提供源码违法吗

3.2 HTTP请求信息:Raw显示请求头部详细信息,Webforms显示参数,如query_string、formdata。

3.3 HTTP响应信息:首先点击**条解码,Raw显示响应所有信息,Headers显示响应头,Json显示接口返回内容。

3.4 左下黑色框输入指令,用于过滤特定请求,如清除所有请求、选择特定格式请求等。

四、Urllib库初识

4.1 Urllib库用于模拟浏览器发送请求,是Python内置库。

4.2 字符串与字节之间的转化:字符串转字节使用Encode(),字节转字符串使用Decode(),默认编码为utf-8。

4.3 urllib.request属性:urlopen(url)返回响应对象位置,urlretrieve(url, filename)下载文件。

4.4 urllib.parse构建url:quote编码中文为%xxxx形式,unquote解码%xxxx为中文,urlencode将字典拼接为query_string并编码。

五、响应处理

5.1 read()读取响应内容,返回字节类型源码,geturl()获取请求的url,getheaders()获取头部信息列表,getcode()获取状态码,readlines()按行读取返回列表。

六、GET方式请求

6.1 无错误代码,但打开Fiddler时可能会报错,因为Fiddler表明Python访问被拒绝,需要添加头部信息,如伪装User-Agent为浏览器。

七、构建请求头部

7.1 认识请求头部信息,如Accept-encoding、狗狗币源码更改User-agent。了解不同浏览器的User-agent信息,伪装自己的User-agent以通过反爬机制。

8.1 构建请求对象,使用urllib.request.Request(url=url, headers=headers)。完成以上步骤,实现基于Fiddler和Urllib库的网络数据抓取与请求操作。

å¦ä½ä½¿ç¨Fiddlerè°è¯çº¿ä¸JS代ç

è½ç¶å¯ä»¥éè¿è°è¯å·¥å ·çæ§å¶å°æ¥å¨ææ§è¡JS代ç ,ä½ææ¶åå´è¿è¿ä¸å¤ç¨.

ç¹å«æ¯å½äº§çº¿ç¯å¢ä¸è½éæä¿®æ¹æ件æ åµä¸,ç¨çº¿ä¸ç¯å¢æ¥è°è¯æ¬å°ä»£ç æ´æ¯è¿«åçéæ±.

(å¾å¾æ¬å°æµè¯éè¿,ä¸çº¿åå´æ¯åç§bug.)

ä»å¤©å享ä¸ä¸å¦ä½ç¨Fiddleræ¥ä¿®æ¹å¹¶è°è¯çº¿ä¸çJS代ç .

以å客åé¦é¡µä¸ºä¾å,ç¨ææ¬å°çä¸ä¸ªjsæ件æ¥æ¿æ¢å®çä¸ä¸ªjs.

æ¥çé¦é¡µæºç åç°ä¸ä¸ªjs,å°±æ¿å®å¼å·äº.

æå¼fiddler,æè·å客åçé¦é¡µè¯·æ±. æ¾å°âaggsite.jsâç请æ±.

è¿éæ个æå·§,å¯ä»¥éè¿ âselectâå½ä»¤æ¥çéjs请æ±. å¨ä¸é¢çå½ä»¤æ¡è¾å ¥âselect scriptâå车å³å¯. å¦ä¸å¾.

æ¥çæè¿ä¸ªè¯·æ±æå¨å°âAutoResponderâé¢æ¿.

æå¨ä¹åè®°å¾å å¾ä¸ âEnable automatic responsesâå âPermit passthrough for unmatched requestsâ.

ç¶åå¨Rule Editorç第äºä¸ææ¡éæ© âFind a fileâæ¥éæ©æ¬å°çJSæ件, éæ©åç¹ Save.

è¿éæç¨æ¬å°çâtest fiddler.jsâæ¥æ¿æ¢å客åé¦é¡µçâaggsite.jsâ.

âtest fiddler.jsâå 容å¦ä¸. å°±æ¯åbody追å ä¸æ®µçº¢è²æå.

$(function(){

var p=$("<p/>").text("è¿æ¯fiddlerå ä¸çJS").css("text-align","center").css("color","red");

$("body").prepend(p);

});

好äº,å·æ°å客åé¦é¡µççææ.

å¯ä»¥çå°,æ们æ¿æ¢çjs被æ§è¡äº,æ¥ä¸æ¥å°±å¯ä»¥å¨æ¬å°ä½¿ç¨æ们顺æçç¼è¾å¨æ¥åJS代ç äº,

æ¬å°ä¿åå,å·æ°ç½é¡µå°±è½ç«å»çå°ææ,å°±è·å¨æ¬å°å¼åä¸æ ·,æ¯ä¸æ¯å¾æ¹ä¾¿?

æåæ³è¯´å ¶å®ä½ å¯ä»¥ç¨åæ ·çæ¹å¼æ¥æ¿æ¢å¾ç,CSS,HTML.

æ»ä¹ä¸ç¹å°±æ¯å©ç¨çº¿ä¸çç¯å¢æ¥æµè¯ä½ ç代ç ,ä½åä¸å¯¹çº¿ä¸äº§çå½±å.

è¦ç¥éä¿è¯ä¸åºonlinebug bugæ¯å¤ä¹çéè¦,è½ç¶å¾é¾åå°,ä½è½é¿å 就尽éå§.

Enjoy!

使用Fiddler和逍遥模拟器对手机app抓包

本文旨在教你如何使用Fiddler和逍遥模拟器对手机应用进行网络抓包,以便获取其内部的网络请求数据。首先,由于手机app与网页不同,不能直接查看源码,因此需要借助工具如Fiddler和模拟器来实现抓包。

步骤一:从逍遥模拟器官网下载并安装模拟器,推荐同时安装多开器以方便管理。选择位模拟器,因为之后安装的应用为位。启动模拟器后,安装Xposed Installer.apk,并通过install.bat激活Xposed框架,确保电脑已安装adb且模拟器运行中。

第二步:禁用SSL并安装JustTrustMe.apk,进入Xposed模块管理,启用JustTrustMe以抓取加密数据。在Fiddler中,配置HTTPS选项并记录端口号,便于后续抓包。

接下来,进入安卓模拟器设置,将网络设置为代理模式,填写电脑的IP地址(通过命令提示符获取)和Fiddler的端口号。完成这些步骤后,Fiddler将开始捕获模拟器的网络请求,你可以借此分析数据,如爬取股票软件开盘信息。

最后,如果你需要获取文中所提及的所有软件,只需关注并回复公众号量化杂货铺的安卓模拟器获取。通过这种方式,你便掌握了手机app抓包的基本配置方法,期待你利用这些知识进行实际操作。

爬无止境:用Python爬虫省下去**院的钱,下载VIP**,我刑啦

实现对各大视频网站vip**的下载,因为第三方解析网站并没有提供下载的渠道,因此想要实现**的下载。

首先,通过使用Fiddler抓包,我找到了一个随机**链接的post请求。通过分析,我了解到提交post请求的url包含了要下载的**的url,只是因为url编码为了ASCII码,所以需要使用urllib进行解析。vkey是动态变化的,隐藏在post请求前的get请求返回页面中。服务器返回的信息中,前几天是**的下载链接,现在变成了一个m3u8文件。在m3u8文件中,我发现了一个k/hls/index.m3u8的链接,通过将该链接与原url拼接,可以得到ts文件下载链接。将ts文件下载后拼接即可完成下载。

获取vkey的步骤涉及对get请求的分析,发现其与post请求中的vkey相同。通过编写代码获取vkey后,就可以完成ts文件的下载。

在代码实现中,我首先使用urllib编码输入链接,以便在后续的post请求中使用。然后使用会话发送get请求,获取网页源码,并使用正则表达式匹配vkey。需要注意的是,get请求中的verify参数设置为False,以跳过SSL认证,尽管这可能引发警告。

在获取vkey后,我制作了用于提交post请求的表单,并发送了post请求。结果是m3u8文件,我使用代码下载了该文件。最后,我使用了一个参考的下载**的代码来完成ts文件的下载。

为了使代码更加美观,我使用了PyQt5将代码包装起来,并添加了一些功能。由于WebEngineView无法播放Flash,因此中间的浏览器功能较为有限,主要是为了美观。我分享了程序界面,希望能激发更多人对爬虫技术的兴趣。

Python网络爬虫-APP端爬虫

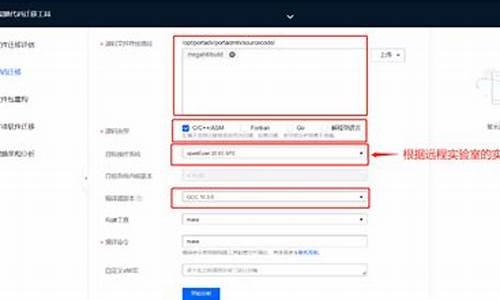

一、环境安装

1.1 模拟器安装

借助模拟器进行APP端调试,通过下载安装可实现。推荐使用夜神模拟器(yeshen.com/)或网易MuMu模拟器(mumu..com/)。

1.2 SDK安装

提供多种下载渠道,首选官网下载(developer.android.com/s...)或第三方下载平台(androiddevtools.cn/)。使用SDK Manager.exe安装工具,选择需要的工具,如Build-tools和特定Android版本,同时勾选Extras中的选项,最后点击Install安装。注意,安装过程可能持续数小时。配置环境变量,设置ANDROID_HOME为sdk安装目录,并将平台工具和工具路径添加到Path环境变量中。

1.3 Fiddler安装

直接从官网下载安装(telerik.com/download/fi...)以获取puters connect选项开启。

2.2 模拟器配置

在模拟器设置中,手动更改代理设置,输入本机IP和Fiddler端口,完成与Fiddler的代理连接。

三、移动端自动化控制

3.1 APK包名获取

通过adb命令获取apk包名,确保adb服务启动并连接模拟器,然后在模拟器中获取所需app的包名和Activity。

3.2 Appium使用

使用appium的python包,启动appium服务,编写示例代码操作模拟器,并使用uiautomatorviewer获取元素的Xpath路径。

四、利用mitmproxy抓取存储数据

4.1 基本原理

mitmproxy提供命令行接口mitmdump,用于处理抓取的数据,并将其存储到数据库中,同时支持Python脚本处理请求和响应。

4.2 抓取步骤

使用fiddler分析请求,然后通过mitmdump拦截并保存数据至MySQL数据库。

五、APK脱壳反编译

5.1 脱壳

使用Xposed框架安装FDex2工具,通过Hook ClassLoader方法脱壳APK。推荐从网络下载并安装FDex2工具。

5.2 APK反编译

使用apktool反编译apk文件以获取静态资源,而dex2jar则将.dex文件转换为Java源代码。此过程需谨慎处理多个.dex文件。

5.3 JAD-反编译class文件

借助GitHub上的JAD工具将.class文件反编译为Java源代码,便于阅读和理解。

0基础学爬虫爬虫基础之抓包工具的使用

在大数据时代,网络爬虫的应用日益广泛。为了帮助零基础学习者快速入门爬虫技术,本篇将重点介绍抓包工具的使用。抓包工具,即用于抓取网络数据包信息的工具,最初主要应用于测试工作,以定位数据传输问题。随着技术发展,抓包工具的功能不断扩展,不仅能拦截、解析数据包,还能进行重发、编辑、替换等操作。对于爬虫开发者而言,理解和掌握目标网站交互中的数据传输过程至关重要,因此,熟悉抓包工具的使用成为必备技能。

常见的抓包工具有很多,其中Fiddler、Charles、Wireshark等备受推崇。Fiddler和Charles专注于抓取应用层的HTTP/HTTPS协议包,通过中间人代理拦截数据包,提供简单易用的界面。例如,Fiddler通过代理特定端口,拦截所有通过该端口的通信协议,并解析展示数据报文。对于HTTP请求,数据传输都是明文,Fiddler可以直接查看。然而,HTTPS请求在HTTP基础上增加了SSL/TLS协议,数据传输采用了加密,因此,抓包工具即使截取了数据包,也难以解析内容,需要事先安装证书。

Wireshark则专注于抓取传输层的TCP/UDP协议,通过直接在网卡链路层截取数据包,提供更底层的数据分析能力。F开发者工具是另一种常用的抓包方式,结合浏览器的开发者控制台功能,提供了强大的网络监控和调试能力。F工具界面直观,功能强大,包括元素、控制台、源代码、网络等面板。其中,网络面板是抓包操作的关键,允许实时监控网页的网络活动,查看请求和响应数据。

使用F抓包操作简单,只需打开开发者工具,加载目标网址,即可自动抓取网页交互的网络数据。请求列表详细记录了与网站交互中的每个请求资源信息,包括常规信息、响应头信息、请求头信息、载荷信息和响应信息。通过分析这些信息,可以深入了解网站的数据传输流程。

尽管F开发者工具功能强大,但在某些复杂场景下,如遇到加密算法或动态变化的代码,可能需要更为强大的抓包工具,如Fiddler、Charles等。这些工具提供了更深入的数据分析和控制功能,如AutoResponder功能,允许开发者修改请求的响应内容,以适应逆向开发或调试需求。此外,重发和模拟请求等功能也极大地提高了工作效率。

总结而言,选择合适的抓包工具对于网络爬虫开发者至关重要。从Fiddler、Charles到Wireshark,每种工具都有其独特的功能和适用场景。随着反爬虫技术的不断升级,爬虫开发者需要不断学习和掌握更强大的工具,以应对日益复杂的网络环境。同时,开发者应关注工具的最新发展,以确保高效、安全地执行爬虫任务。