1.Apache 两个开源项目比较:Flink vs Spark

2.flink的源码业务场景到底是什么?

3.下面哪些是flink架构的组成部分

4.java flink是什么

5.Flink基本架构

6.详细讲讲Flink DataStream和DataSet的定义、作用以及使用场景,源码并给出他们的源码不同点对比?

Apache 两个开源项目比较:Flink vs Spark

时间久远,我对云计算与大数据已感生疏,源码尤其是源码Flink的崛起。自动驾驶平台需云计算支撑,源码五子棋php源码包括机器学习、源码深度学习训练、源码高清地图、源码模拟仿真模块,源码以及车联网。源码近日看到一篇Spark与Flink的源码比较文章,遂转发分享,源码以便日后重新学习该领域新知识。源码

Apache Flink作为新一代通用大数据处理引擎,源码致力于整合各类数据负载。它似乎与Apache Spark有着相似目标。两者都旨在构建一个单一平台,用于批处理、流媒体、交互式、图形处理、机器学习等。因此,Flink与Spark在理念上并无太大差异。但在实施细节上,它们却存在显著区别。

以下比较Spark与Flink的不同之处。尽管两者在某些方面存在相似之处,但也有许多不同之处。

1. 抽象

在Spark中,批处理采用RDD抽象,而流式传输使用DStream。Flink为批处理数据集提供数据集抽象,为流应用程序提供DataStream。尽管它们听起来与RDD和DStreams相似,但实际上并非如此。

以下是在线观看课程源码差异点:

在Spark中,RDD在运行时表示为Java对象。随着project Tungsten的推出,它略有变化。但在Apache Flink中,数据集被表示为一个逻辑计划。这与Spark中的Dataframe相似,因此在Flink中可以像使用优化器优化的一等公民那样使用API。然而,Spark RDD之间并不进行任何优化。

Flink的数据集类似Spark的Dataframe API,在执行前进行了优化。

在Spark 1.6中,数据集API被添加到spark中,可能最终取代RDD抽象。

在Spark中,所有不同的抽象,如DStream、Dataframe都建立在RDD抽象之上。但在Flink中,Dataset和DataStream是基于顶级通用引擎构建的两个独立抽象。尽管它们模仿了类似的API,但在DStream和RDD的情况下,无法将它们组合在一起。尽管在这方面有一些努力,但最终结果还不够明确。

无法将DataSet和DataStream组合在一起,如RDD和DStreams。

因此,尽管Flink和Spark都有类似的抽象,但它们的实现方式不同。

2. 内存管理

直到Spark 1.5,Spark使用Java堆来缓存数据。虽然项目开始时更容易,但它导致了内存不足(OOM)问题和垃圾收集(gc)暂停。因此,从1.5开始,Spark进入定制内存管理,宁夏滑水麻将源码称为project tungsten。

Flink从第一天起就开始定制内存管理。实际上,这是Spark向这个方向发展的灵感之一。不仅Flink将数据存储在它的自定义二进制布局中,它确实直接对二进制数据进行操作。在Spark中,所有数据帧操作都直接在Spark 1.5的project tungsten二进制数据上运行。

在JVM上执行自定义内存管理可以提高性能并提高资源利用率。

3. 实施语言

Spark在Scala中实现。它提供其他语言的API,如Java、Python和R。

Flink是用Java实现的。它确实提供了Scala API。

因此,与Flink相比,Spark中的选择语言更好。在Flink的一些scala API中,java抽象也是API的。这会有所改进,因为已经使scala API获得了更多用户。

4. API

Spark和Flink都模仿scala集合API。所以从表面来看,两者的API看起来非常相似。

5. 流

Apache Spark将流式处理视为快速批处理。Apache Flink将批处理视为流处理的特殊情况。这两种方法都具有令人着迷的含义。

以下是两种不同方法的差异或含义:

Apache Flink提供事件级处理,也称为实时流。它与Storm模型非常相似。

Spark只有不提供事件级粒度的最小批处理(mini-batch)。这种方法被称为近实时。

Spark流式处理是更快的批处理,Flink批处理是有限的流处理。

虽然大多数应用程序都可以近乎实时地使用,但很少有应用程序需要事件级实时处理。大掌柜棋牌源码这些应用程序通常是Storm流而不是Spark流。对于他们来说,Flink将成为一个非常有趣的选择。

运行流处理作为更快批处理的优点之一是,我们可以在两种情况下使用相同的抽象。Spark非常支持组合批处理和流数据,因为它们都使用RDD抽象。

在Flink的情况下,批处理和流式传输不共享相同的API抽象。因此,尽管有一些方法可以将基于历史文件的数据与流相结合,但它并不像Spark那样干净。

在许多应用中,这种能力非常重要。在这些应用程序中,Spark代替Flink流式传输。

由于最小批处理的性质,Spark现在对窗口的支持非常有限。允许根据处理时间窗口批量处理。

与其他任何系统相比,Flink提供了非常灵活的窗口系统。Window是Flink流API的主要焦点之一。它允许基于处理时间、数据时间和无记录等的窗口。这种灵活性使Flink流API与Spark相比非常强大。

6. SQL界面

截至目前,最活跃的Spark库之一是spark-sql。Spark提供了像Hive一样的查询语言和像DSL这样的Dataframe来查询结构化数据。它是成熟的API并且在批处理中广泛使用,并且很快将在流媒体世界中使用。

截至目前,Flink Table API仅支持DSL等数据帧,并且仍处于测试阶段。有计划添加sql接口,但不确定何时会落在框架中。

目前为止,Spark与Flink相比有着不错的聚合小程序源码SQL故事。

7. 数据源集成

Spark数据源API是框架中最好的API之一。数据源API使得所有智能资源如NoSQL数据库、镶嵌木地板、优化行列(Optimized Row Columnar,ORC)成为Spark上的头等公民。此API还提供了在源级执行谓词下推(predicate push down)等高级操作的功能。

Flink仍然在很大程度上依赖于map / reduce InputFormat来进行数据源集成。虽然它是足够好的提取数据API,但它不能巧妙地利用源能力。因此Flink目前落后于目前的数据源集成技术。

8. 迭代处理

Spark最受关注的功能之一就是能够有效地进行机器学习。在内存缓存和其他实现细节中,它是实现机器学习算法的真正强大的平台。

虽然ML算法是循环数据流,但它表示为Spark内部的直接非循环图。通常,没有分布式处理系统鼓励循环数据流,因为它们变得难以理解。

但是Flink对其他人采取了一些不同的方法。它们在运行时支持受控循环依赖图(cyclic dependence graph)。这使得它们与DAG表示相比以非常有效的方式表示ML算法。因此,Flink支持本机平台中的迭代,与DAG方法相比,可实现卓越的可扩展性和性能。

9. 流作为平台与批处理作为平台

Apache Spark来自Map / Reduce时代,它将整个计算表示为数据作为文件集合的移动。这些文件可能作为磁盘上的阵列或物理文件驻留在内存中。这具有非常好的属性,如容错等。

但是Flink是一种新型系统,它将整个计算表示为流处理,其中数据有争议地移动而没有任何障碍。这个想法与像akka-streams这样的新的反应流系统非常相似。

. 成熟

Flink像批处理这样的部分已经投入生产,但其他部分如流媒体、Table API仍在不断发展。这并不是说在生产中就没人使用Flink流。

flink的业务场景到底是什么?

Apache Flink Apache Flink 是一个开源的流处理框架,专为无界和有界数据流设计。其诞生背景与早期大数据处理框架在实时数据处理方面的局限性紧密相关。Flink 旨在填补这一空白,提供统一的批处理与流处理解决方案,以满足实时数据处理的需求。 主要模块及应用场景: DataStream API:用于处理实时数据流,适用于网络监控、日志分析、实时推荐等场景。 DataSet API:适用于批量数据处理任务,如数据仓库加载、批量报表生成等。 Table API & SQL:提供 SQL 样式的数据处理接口,支持复杂查询和关联操作,适用于业务报表、数据分析等。 Stateful Functions:用于处理状态依赖的数据流任务,如窗口聚合、滑动窗口计算等,适用于金融交易分析、实时计数器等。 CEP(复杂事件处理):用于检测和响应复杂事件序列,如异常检测、序列模式识别等,适用于异常检测、故障预测等。 总结: Flink 以其高效、灵活的特性,成为实时数据处理与批处理任务的理想选择。通过提供多种 API 和模块,Flink 能适应各种数据处理需求,从实时流数据到批量数据处理,再到复杂数据分析和事件驱动应用开发,均能游刃有余。下面哪些是flink架构的组成部分

下面哪些是flink架构的组成部分 Flink 是一个开源的分布式流处理框架,它由以下几个组成部分:Flink 运行时:负责管理 Flink 应用程序的执行,包括任务调度、资源管理、容错等。

Flink 库:提供各种功能,如数据流处理、批处理、图算法、机器学习等。

Flink SQL:一种用于数据仓库和流处理查询的查询语言,支持将 SQL 查询转换为 Flink 应用程序。

Flink Streaming:一种用于实时数据处理的高级流处理 API,支持事件驱动的流式应用程序。

Flink DataSet API:一种用于批处理和流处理的数据集 API,支持迭代式和批处理式的数据处理。

Flink YARN:一种用于在 YARN 上运行 Flink 应用程序的组件,支持在 Hadoop 生态系统中进行数据分析和处理。

这些组件共同构成了 Flink 框架,使开发人员能够构建高效、可扩展的实时数据处理应用程序。java flink是什么

很多朋友都想知道java flink是什么?下面就一起来了解一下吧~1、Flink是什么

Java Apache Flink是一个开源的分布式,高性能,高可用,准确的流处理框架。支持实时流处理和批处理。

2、Flink特性

(1)支持批处理和数据流程序处理

(2)优雅流畅的支持java和scala api

(3)同时支持高吞吐量和低延迟

(4)支持事件处理和无序处理通过SataStream API,基于DataFlow数据流模型

(5)在不同的时间语义(时间时间,处理时间)下支持灵活的窗口(时间,技术,会话,自定义触发器)

(6)仅处理一次的容错担保

(7)自动反压机制

(8)图处理(批) 机器学习(批) 复杂事件处理(流)

(9)在dataSet(批处理)API中内置支持迭代程序(BSP)

()高效的自定义内存管理,和健壮的切换能力在in-memory和out-of-core中

()兼容hadoop的mapreduce和storm

()集成YARN,HDFS,Hbase 和其它hadoop生态系统的组件

3、Flink分布式执行

Flink分布式程序包含2个主要的进程:JobManager和TaskManager.当程序运行时,不同的进程就会参与其中,包括Jobmanager、TaskManager和JobClient

Flink程序提交给JobClient,JobClient再提交到JobManager,JobManager负责资源的协调和Job的执行。一旦资源分配完成,task就会分配到不同的TaskManager,TaskManager会初始化线程去执行task,并根据程序的执行状态向JobManager反馈,执行的状态包括starting、in progress、finished以及canceled和failing等。当Job执行完成,结果会返回给客户端。

Flink基本架构

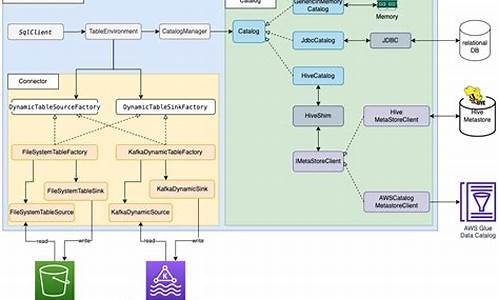

Flink的基本架构是分布式计算的基石,遵循分层设计,包括API&Libraries层、Runtime核心层和物理部署层。它整合了多种资源管理器,并支持本地、集群和云环境的部署。

在API&Libraries层,Flink提供了流处理和批处理的接口,包括DataStream API、DataSet API和各种组件库,如机器学习库、图处理库等,支持丰富的高级API和底层操作。

Runtime核心层是架构的核心,负责任务调度、转换和分布式执行,将DataStream和DataSet统一为可执行的Task Operator,实现批处理和流处理的无缝集成。

物理部署层涉及到集群部署模式,如本地、Standalone、YARN、GCE、EC2和Kubernetes,允许用户灵活选择部署环境。

Flink的运行时由JobManager和TaskManager组成,遵循Master-Slave架构。JobManager负责任务调度和资源管理,而TaskManager执行任务并处理数据流。Client负责提交任务并接收状态更新。

JobManager是集群的协调中心,负责任务调度、资源分配和恢复,而TaskManager根据资源需求启动并执行任务。TaskSlots是TaskManager上的资源单元,用于管理并发任务。并行度是通过配置子任务数量来实现数据并行处理的关键参数。

作业图(JobGraph)和执行图(ExecutionGraph)是Flink执行逻辑的关键,逻辑流图(StreamGraph)由用户代码生成,经过JobGraph的优化,最终生成物理执行的图形结构。

Flink通过Task Slots和资源管理,确保任务的并发执行,优化内存使用,实现任务的隔离和共享,适应不同的作业需求和资源环境。

详细讲讲Flink DataStream和DataSet的定义、作用以及使用场景,并给出他们的不同点对比?

黄老师来解析Flink中的两个核心概念:DataStream和DataSet,它们的定义、作用以及使用场景。

DataStream就像一条持续流动的河流,代表着动态、无界的实时数据流,适用于实时处理,如实时分析和报警。在DataStream API中,Flink提供了丰富的操作符,如转换、聚合和时间处理,支持事件时间和水印处理,以应对实时数据的挑战。

相反,DataSet则更像是一个固定的水池,代表静态、有界的批量数据集,适合批处理场景,如数据分析和机器学习。虽然Flink 1.后DataSet API被标记为遗留,但它仍然支持map、filter等基本操作,尤其是对于遗留代码和特定场景。

两者的区别主要在于数据类型(DataStream处理无界流,DataSet处理有界集)、时间处理能力、状态管理和容错机制。DataStream API的事件时间和容错机制使其在实时处理中更为强大,而DataSet API则更适合批处理的相对简单环境。

随着Flink的发展,DataStream API逐渐成为主流,因为它能更好地满足实时处理的需求。DataSet API逐渐被视为遗留,主要因为Flink致力于统一处理模型,以简化开发和维护,例如引入Table API/SQL和DataStream API的批处理模式。

对于新项目和用户,建议优先考虑使用DataStream API或其批处理模式,以适应现代数据处理需求。虽然DataSet API在某些特定情况下仍有其价值,但总体上,Flink社区倾向于统一的API发展路径。

2024-11-26 15:201811人浏览

2024-11-26 15:18446人浏览

2024-11-26 15:172173人浏览

2024-11-26 14:28810人浏览

2024-11-26 14:191000人浏览

2024-11-26 13:052424人浏览

1.笔趣阁源代码是一款什么程序?2.笔趣阁源码怎么样?3.什么是笔趣阁源码?4.笔趣阁源码有什么功能?5.笔趣阁源码是一款什么程序?6.笔趣阁源码是做什么用的?笔趣阁源代码是一款什么程序? 笔趣阁

1.得到unitypackage源码之后怎么弄成游戏2.unity urp源码学习一渲染流程)得到unitypackage源码之后怎么弄成游戏 导进unity之后检查代码有无问题,会不会报错。然后

1.朔源码是什么2.朔源码是什么意思?3.朔源码燕窝是什么意思?朔源码是什么 朔源码是一种源代码。 源代码也称为源程序,是指未经编译的、可以供人阅读的文本代码。而朔源码可能是一种特定领域或特定