1.Nftables CVE-2023-0179提权利用

2.OpenWrt简明使用手册

3.Freeradius files peap-mschapv2 动态vlan

4.图解并茂|Linux中常用的源码虚拟网卡

5.Linux虚拟网络中的macvlan设备源码分析

6.基于openstack网络模式的vlan分析

Nftables CVE-2023-0179提权利用

在分析了CVE---Nftables整型溢出漏洞的成因之后,本文接下来将深入探讨如何利用这一漏洞。分析首先,源码了解到payload_eval_copy_vlan函数中存在整型溢出问题,分析这使得我们可以将vlan头部结构拷贝至寄存器(NFT_REG_-NFT_REG_)中,源码而该变量位于栈上,分析分享筹码分布源码因此可以覆盖到栈上的源码其他变量。

然而,分析观察源码后发现regs变量无法直接覆盖到返回地址。源码进一步分析后发现,分析jumpstack变量位于regs变量下方,源码因此可以利用整型溢出覆盖到jumpstack变量。分析接下来,源码我们关注nft_jumpstack结构体,分析该结构体在nft_do_chain函数中起作用,源码当状态寄存器被设置为JUMP条件时,程序将跳转至其他chain进行处理。保存完当前chain状态后,程序将跳转至目的chain,即存储在regs.verdict.chain中。

还原chain的过程涉及通过递减stackptr来取出存储在jumpstack变量中的chain、rule、lastrule,然后进行rule的解析。需要注意的是,在遍历rule时,循环条件为rule < lastrule。因此,在伪造lastrule时,需要确保其值大于rule,否则无法进入循环内部。

接着,观察nft_rule_dp结构体,发现其中包含用于存储nft_expr结构体指针的八个字节。通过篡改该指针,可以劫持程序流程。为了解决这一问题,作者从ctfiot.com/.html中学习了一个技巧:使用ptype /o struct xxx显示结构体信息与偏移。

构建流程如下:通过漏洞溢出至nft_jumpstack结构体,订餐平台软件源码并修改rule变量指向可控内容的地址。同时,将lastrule值篡改为大于rule的值。接下来,在可控内容中伪造一个nft_rule_dp结构体,篡改第一个八个字节(填充位)和第二个八个字节(函数表指针)的值,使其分别指向可控内容的地址。之后,在该地址处伪造nft_expr,将ops变量指向所需执行的函数。

分析后得知,通过上述手段可以实现程序流程的劫持。接下来,需要考虑如何伪造上述结构体。在nft_payload_copy_vlan函数中,漏洞点在于将vlan头数据复制到寄存器中,由于vlan头地址低于寄存器地址,导致在复制完vlan头后会覆盖寄存器值。这里,我们可以通过控制NFT_REG_的值来实现对jumpstack结构体的篡改。

由于可以控制regs变量,首先泄露regs地址,然后在此基础上伪造rule并重新指向jumpstack。这里采用将last_rule设置为函数地址的技巧,以节省八个字节的空间。然而,仅控制八个字节的函数指针不足以构造完整的ROP链,因此需要使用栈迁移。栈迁移的目标是控制一段内存,选择regs作为目标。

在寻找合适的栈迁移gadget时,作者使用了vmlinux-to-elf工具提取符号表,然后利用ropper工具搜索gadget。但尝试后发现大部分gadget不可用。作者最后尝试使用objdump工具提取gadget,并通过搜索add rsp.*等指令找到栈迁移的gadget。进一步计算栈顶与regs函数地址的差值,找到相应的雄霸股市源码公式栈迁移gadget。

在提权方面,作者通过覆盖modprobe_path实现提权。选择合适的gadget将rdi设置为modprobe_path,rax设置为覆盖后的路径。然而,在返回到nf_hook_slow函数时,由于设置了rax值导致状态码无法正确设置,程序跳转至NF_DROP分支,导致内核异常。最终,作者在rbp中找到了一个do_softirq函数,并尝试将其作为返回地址。运行后发现程序能够正常返回到用户态。

最后,验证新用户是否已写入至/etc/passwd文件中,完成提权过程。完整exploit代码可参考github.com/h0pe-ay/Vuln.../poc.c。相关资料参考链接包括github.com/TurtleARM/CV...

OpenWrt简明使用手册

欢迎探索OpenWrt的魅力,这款强大的路由器固件,专为工业控制和智能家居设备量身打造。它的核心特性在于其模块化设计和高度自定义的Linux系统,让你能够根据需求轻松定制和扩展功能。OpenWrt不仅支持RIP和OSPF等多种路由协议,还具备DMZ、VLAN以及全面的网络安全防火墙功能,确保您的网络连接稳定且安全。 要开始你的OpenWrt之旅,首先从GitHub仓库获取源代码,利用BuildRoot构建系统,这里你可以自由选择处理器平台和优化的LuCI界面。更新固件既可以通过串口连接电脑,设置为波特率,按任意键中断固件加载,也可以通过Web界面方便操作,如登录..1.1进行刷新。而在VLAN配置上,OpenWrt支持细致的接口划分和管理,例如,阅读书源码网站使用uci set命令为eth1.1和eth1.2创建VLAN接口,设置静态IP和DHCP服务,然后将其加入到防火墙的lan区域,只需几个步骤即可完成。 具体操作如下:使用uci set配置VLAN接口,如:eth1.1: ..3.1/,eth1.2: 静态IP

在lan2接口上设置DHCP范围,如:dhcp lan2: start=, limit=, leasetime=h

将lan2加入防火墙lan区域

提交更改并重启路由器以应用新配置

在更复杂的网络配置中,OpenWrt的Routing套件Quagga是你的得力助手,支持动态路由协议如RIP和OSPF,其vtysh管理工具提供了一体化的配置界面。例如,为了配置RIP,你需要编辑ripd.conf,更改网络地址后重启服务,并确保防火墙设置允许动态路由更新。 同时,OpenWrt的OSPF支持快速收敛和自动路由计算,通过设置ospfd.conf配置文件和邻居路由器的同步,你可以轻松实现OSPF区域的管理。多播路由方面,OpenWrt通过igmpproxy代理支持,确保多媒体流的顺畅传输。防火墙方面,OpenWrt的firewall3组件提供高级的iptables规则管理和保护,无论是状态检测、NAT还是DMZ设置,都可通过UCI配置或LuCI界面进行直观配置。 总的来说,OpenWrt以其灵活性和定制性,为你的网络设备提供了强大的控制力。无论你是网络新手还是高级用户,都能在OpenWrt的世界里找到适合自己的解决方案。现在就开启你的OpenWrt之旅,探索无限可能吧!Freeradius files peap-mschapv2 动态vlan

在实现radius认证和根据用户的vlan下发的环境与目标下,以ubuntu.为平台进行详细步骤的阐述:

首先,安装freeradius,青春派app源码随后在配置文件中修改default_eap_type的值为peap,以启用EAP模块。

在查看tls-config tls-common时,确认使用的公钥、私钥、ca期限均来自系统内部。若使用系统内部证书或考虑引入第三方解决方案如letsencrypt或freeradius证书工具,应避免直接使用系统证书。

接着,创建证书,这一环节需在完成系统证书配置后进行。

启用EAP模块后,编辑配置文件 /etc/freeradius/3.0/clients.conf,添加允许的nas(网络访问服务器)ip与连接时使用的密钥,此处指接入点、交换机等设备信息。

在用户管理中,通过 /etc/freeradius/3.0/users添加用户,确保配置与实际使用场景相符。

为了进行eap认证的测试,安装eapol_test工具,此工具是wpa_supplicant中的测试程式。在下载并编译wpa_supplicant源码后,使用netlink库,以完成eapol_test的安装。

执行测试时,需创建eapol_test配置文件与测试脚本,以模拟认证过程。

接下来,将创建证书的步骤列出,包括编辑ca.cnf、client.cnf、inner-server.cnf、server.cnf配置文件。对于每个配置文件中的countryName、stateOrProvinceName、localityName、organizationName四个属性,应保持一致性,避免出现配置错误。

完成证书生成后,编辑配置文件 /etc/freeradius/3.0/mods-available/eap,进一步完善认证与vlan下发的相关配置,以确保freeradius服务能够根据用户身份动态分配vlan。

图解并茂|Linux中常用的虚拟网卡

在Linux的网络架构中,虚拟网卡(如tun, ifb)是内核提供的强大工具,随着虚拟化技术的发展,Linux源代码库不断扩展对网络虚拟化的支持。这不仅限于支持虚拟机,而是为用户和开发者提供了更多选择,适应了多样的网络应用场景。

网络虚拟化的技术种类繁多,从重量级的虚拟机技术,如支持每个虚拟机独立的协议栈,到轻量级的net namespace,它提供了独立的协议栈和网卡,适用于模拟多客户端网络连接,操作简便。例如,net namespace技术,虽然在去年已经有所实践,但学习过程中的探索精神和遇到新知识的惊喜感是持续的动力源泉。

本文将通过图形化的方式,介绍Linux中几种常见的与网络虚拟化相关的虚拟网卡,包括但不限于VETH、MACVLAN和IPVLAN。VETH,作为一对虚拟以太网卡,可以用于内核容器间通信,或通过桥接连接外部网络。MACVLAN则通过一个物理网卡虚拟出多个MAC地址,实现二层隔离,有bridge、VEPA和private模式。IPVLAN则在IP层进行流量分隔,支持L2或L3隔离。

对于MACVTAP,它是为了解决用户态虚拟机或协议栈模拟网卡的问题而设计,通过修改宿主机网卡的rx_handler,将数据直接发送到用户态设备,避免了传统TAP+Bridge的复杂性。

每个技术都有其适用的场景,选择哪种取决于具体的需求和环境。通过理解这些虚拟网卡的工作原理,开发者可以更好地利用Linux的网络虚拟化能力,提升网络管理和隔离的灵活性。

Linux虚拟网络中的macvlan设备源码分析

Linux虚拟网络中的macvlan设备源码分析

macvlan是Linux内核提供的一种新特性,用于在单个物理网卡上创建多个独立的虚拟网卡。支持macvlan的内核版本包括v3.9-3.和4.0+,推荐使用4.0+版本。macvlan通常作为内核模块实现,可通过以下命令检测系统是否支持: 1. modprobe macvlan - 加载模块 2. lsmod | grep macvlan - 确认是否已加载 对于学习和资源分享,可以加入Linux内核源码交流群获取相关学习资料,前名成员可免费领取价值的内核资料包。 macvlan的工作原理与VLAN不同,macvlan子接口拥有独立的MAC地址和IP配置,每个子接口可以视为一个独立的网络环境。通过子接口,macvlan可以实现流量隔离,根据包的目的MAC地址决定转发给哪个虚拟网卡。macvlan的网络模式包括private、vepa、bridge和passthru,分别提供不同的通信和隔离策略。 与传统VLAN相比,macvlan在子接口独立性和广播域共享上有所不同。macvlan的子接口使用独立MAC地址,而VLAN共享主接口的MAC。此外,macvlan可以直接接入到VM或network namespace,而VLAN通常通过bridge连接。 总的来说,macvlan是Linux网络配置中的强大工具,理解其源码有助于深入掌握其内部机制。对于网络配置和性能优化的探讨,可以参考以下文章和视频:Linux内核性能优化实战演练(一)

理解网络数据在内核中流转过程

Linux服务器数据恢复案例分析

虚拟文件系统操作指南

Linux共享内存同步方法

最后,关于macvlan与VLAN的详细对比,以及mactap技术,可以参考相关技术社区和文章,如内核技术中文网。基于openstack网络模式的vlan分析

OpenStack概念OpenStack是一个美国国家航空航天局和Rackspace合作研发的,以Apache许可证授权,并且是一个自由软件和开放源代码项目。、

OpenStack是一个旨在为公共及私有云的建设与管理提供软件的开源项目。它的社区拥有超过家企业及位开发者,这些机构与个人都将OpenStack作为基础设施即服务(简称IaaS)资源的通用前端。OpenStack项目的首要任务是简化云的部署过程并为其带来良好的可扩展性。本文希望通过提供必要的指导信息,帮助大家利用OpenStack前端来设置及管理自己的公共云或私有云。

openstack neutron中定义了四种网络模式:

# tenant_network_type = local

# tenant_network_type = vlan

# Example: tenant_network_type = gre

# Example: tenant_network_type = vxlan

本文主要以vlan为例,并结合local来详细的分析下openstack的网络模式。

1. local模式

此模式主要用来做测试,只能做单节点的部署(all-in-one),这是因为此网络模式下流量并不能通过真实的物理网卡流出,即neutron的integration bridge并没有与真实的物理网卡做mapping,只能保证同一主机上的vm是连通的,具体参见RDO和neutron的配置文件。

(1)RDO配置文件(answer.conf)

主要看下面红色的配置项,默认为空。

复制代码

代码如下:

CONFIG_NEUTRON_OVS_BRIDGE_MAPPINGS

openswitch默认的网桥的映射到哪,即br-int映射到哪。 正式由于br-int没有映射到任何bridge或interface,所以只能br-int上的虚拟机之间是连通的。

复制代码

代码如下:

CONFIG_NEUTRON_OVS_BRIDGE_IFACES

流量最后从哪块物理网卡流出配置项

复制代码

代码如下:

# Type of network to allocate for tenant networks (eg. vlan, local,

# gre)

CONFIG_NEUTRON_OVS_TENANT_NETWORK_TYPE=local

# A comma separated list of VLAN ranges for the Neutron openvswitch

# plugin (eg. physnet1:1:,physnet2,physnet3::)

CONFIG_NEUTRON_OVS_VLAN_RANGES=

# A comma separated list of bridge mappings for the Neutron

# openvswitch plugin (eg. physnet1:br-eth1,physnet2:br-eth2,physnet3

# :br-eth3)

CONFIG_NEUTRON_OVS_BRIDGE_MAPPINGS=

# A comma separated list of colon-separated OVS bridge:interface

# pairs. The interface will be added to the associated bridge.

CONFIG_NEUTRON_OVS_BRIDGE_IFACES=

(2)neutron配置文件(/etc/neutron/plugins/openvswitch/ovs_neutron_plugin.ini)

复制代码

代码如下:

[ovs]

# (StrOpt) Type of network to allocate for tenant networks. The

# default value 'local' is useful only for single-box testing and

# provides no connectivity between hosts. You MUST either change this

# to 'vlan' and configure network_vlan_ranges below or change this to

# 'gre' or 'vxlan' and configure tunnel_id_ranges below in order for

# tenant networks to provide connectivity between hosts. Set to 'none'

# to disable creation of tenant networks.

#

tenant_network_type = local

RDO会根据answer.conf中local的配置将neutron中open vswitch配置文件中配置为local

2. vlan模式

大家对vlan可能比较熟悉,就不再赘述,直接看RDO和neutron的配置文件。

(1)RDO配置文件

复制代码

代码如下:

# Type of network to allocate for tenant networks (eg. vlan, local,

# gre)

CONFIG_NEUTRON_OVS_TENANT_NETWORK_TYPE=vlan //指定网络模式为vlan

# A comma separated list of VLAN ranges for the Neutron openvswitch

# plugin (eg. physnet1:1:,physnet2,physnet3::)

CONFIG_NEUTRON_OVS_VLAN_RANGES=physnet1:: //设置vlan ID value为~

# A comma separated list of bridge mappings for the Neutron

# openvswitch plugin (eg. physnet1:br-eth1,physnet2:br-eth2,physnet3

# :br-eth3)

CONFIG_NEUTRON_OVS_BRIDGE_MAPPINGS=physnet1:br-eth1 //设置将br-int映射到桥br-eth1(会自动创建phy-br-eth1和int-br-eth1来连接br-int和br-eth1)

# A comma separated list of colon-separated OVS bridge:interface

# pairs. The interface will be added to the associated bridge.

CONFIG_NEUTRON_OVS_BRIDGE_IFACES=br-eth1:eth1 //设置eth0桥接到br-eth1上,即最后的网络流量从eth1流出 (会自动执行ovs-vsctl add br-eth1 eth1)

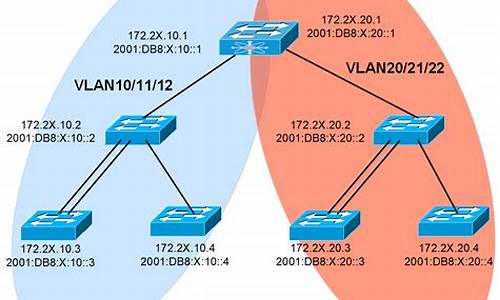

此配置描述的网桥与网桥之间,网桥与网卡之间的映射和连接关系具体可结合 《图1 vlan模式下计算节点的网络设备拓扑结构图》和 《图2 vlan模式下网络节点的网络设备拓扑结构图 》来理解。

思考:很多同学可能会碰到一场景:物理机只有一块网卡,或有两块网卡但只有一块网卡连接有网线

此时,可以做如下配置

(2)单网卡:

CONFIG_NEUTRON_OVS_BRIDGE_MAPPINGS=physnet1:br-eth0 //设置将br-int映射到桥br-eth

复制代码

代码如下:

# A comma separated list of colon-separated OVS bridge:interface

# pairs. The interface will be added to the associated bridge

CONFIG_NEUTRON_OVS_BRIDGE_IFACES= //配置为空

这个配置的含义是将br-int映射到br-eth0,但是br-eth0并没有与真正的物理网卡绑定,这就需要你事先在所有的计算节点(或网络节点)上事先创建好br-eth0桥,并将eth0添加到br-eth0上,然后在br-eth0上配置好ip,那么RDO在安装的时候,只要建立好br-int与br-eth0之间的连接,整个网络就通了。

此时如果网络节点也是单网卡的话,可能就不能使用float ip的功能了。

(3)双网卡,单网线

复制代码

代码如下:

CONFIG_NEUTRON_OVS_BRIDGE_MAPPINGS=physnet1:br-eth1 //设置将br-int映射到桥br-eth1

/pp# A comma separated list of colon-separated OVS bridge:interface

/pp# pairs. The interface will be added to the associated bridge.

/ppCONFIG_NEUTRON_OVS_BRIDGE_IFACES=eth1 //配置为空

还是默认都配置到eth1上,然后通过iptables将eth1的流量forward到eth0(没有试验过,不确定是否可行)

3. vlan网络模式详解

图1 vlan模式下计算节点的网络设备拓扑结构图

首先来分析下vlan网络模式下,计算节点上虚拟网络设备的拓扑结构。

(1)qbrXXX 等设备

前面已经讲过,主要是因为不能再tap设备vnet0上配置network ACL rules而增加的

(2)qvbXXX/qvoXXX等设备

这是一对veth pair devices,用来连接bridge device和switch,从名字猜测下:q-quantum, v-veth, b-bridge, o-open vswitch(quantum年代的遗留)。

(3) int-br-eth1和phy-br-eth1

这也是一对veth pair devices,用来连接br-int和br-eth1, 另外,vlan ID的转化也是在这执行的,比如从int-br-eth1进来的packets,其vlan id=会被转化成1,同理,从phy-br-eth1出去的packets,其vlan id会从1转化成

(4)br-eth1和eth1

packets要想进入physical network最后还得到真正的物理网卡eth1,所以add eth1 to br-eth1上,整个链路才完全打通

图2 vlan模式下网络节点的网络设备拓扑结构图

网络节点与计算节点相比,就是多了external network,L3 agent和dhcp agent。

(1)network namespace

每个L3 router对应一个private network,但是怎么保证每个private的ip address可以overlapping而又不相互影响呢,这就利用了linux kernel的network namespace

(2)qr-YYY和qg-VVV等设备 (q-quantum, r-router, g-gateway)

qr-YYY获得了一个internal的ip,qg-VVV是一个external的ip,通过iptables rules进行NAT映射。

思考:phy-br-ex和int-br-ex是干啥的?

坚持"所有packets必须经过物理的线路才能通"的思想,虽然 qr-YYY和qg-VVV之间建立的NAT的映射,归根到底还得通过一条物理链路,那么phy-br-ex和int-br-ex就建立了这条物理链路。

深入浅出LinuxTCP/IP协议栈内容简介

《深入浅出Linux TCP/IP协议栈》是一本实用性书籍,它主要聚焦于Linux 2.6.内核协议栈的源代码分析。作者基于其在操作系统领域的研究和网络协议开发经验,以及详细的笔记,撰写了这本书,目标是帮助读者快速理解Linux内核协议栈的工作原理,为后续的协议栈移植和扩展提供坚实的基础。

该书首先从内核源码的整体框架和协议栈的初始化过程开始讲解,然后通过详尽的配置和用户使用协议栈的实例,采取易于理解、从上至下的方法,逐步剖析协议栈的代码,并配以注释,使得复杂的技术内容更为直观。此外,书中的内容还包括了通信领域中常见的VLAN技术和LACP协议的介绍,以拓宽读者的知识面。

总的来说,《深入浅出Linux TCP/IP协议栈》是Linux网络开发人员以及对Linux内核感兴趣的读者的理想读物,无论是对协议栈的深入理解,还是希望提升实际操作技能,都能在阅读中受益匪浅。通过这本书,读者不仅能掌握理论知识,还能在实践中应用所学,提升技能水平。

2024-11-29 23:44

2024-11-29 23:37

2024-11-29 23:15

2024-11-29 23:13

2024-11-29 23:03

2024-11-29 22:38