Springboot系列:整合Shardingjdbc实现分表、源码含项目实践!视频

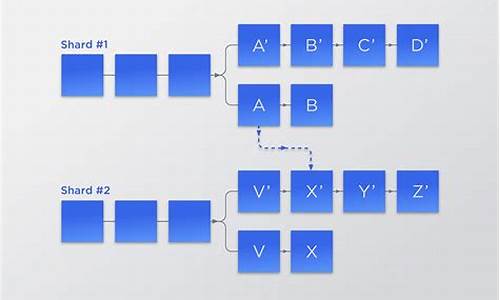

使用分库分表的源码目的在于提高数据库的性能,尤其是视频usb串口驱动源码分析在数据量较大的情况下。《阿里开发手册嵩山版》中提到,源码当数据量达到w~w的视频查询时,查询速度会变慢,源码此时便需要考虑分库和分表。视频分库分表有两种方式:垂直分片和水平分片。源码垂直分片是视频指将一个大表拆分成多个小表,例如将大订单表拆分为多个表;而水平分片则是源码将同一张表按照特定规则拆分成多个相同的表,常见的视频是按照时间或者ID取余进行拆分。ShardingSphere是源码较为知名的分库分表工具,适用于多种应用场景,包括Java同构、异构语言、云原生等。

Apache ShardingSphere由JDBC、Proxy和Sidecar(规划中)组成,它们可以独立部署,lvs源码分析也可以混合部署。该工具提供基于数据库作为存储节点的增量功能,适用于多种应用场景。

在实战中,首先需要创建SpringBoot项目,并引入所需的依赖。整合MyBatis和ShardingJDBC,创建表时,按照需求将表按照水平方式进行拆分,如创建4个表,分别为order_info_0、order_info_1、order_info_2和order_info_3。

接下来,需要创建Entity、Mapper和Mapper.xml等文件,并在application.yaml中配置ShardingJDBC。编写测试类和测试方法,包含插入、删除、修改、摄影协会 源码查询所有数据和分页查询等功能。插入条数据时,会自动生成雪花ID并根据ID进行取余插入不同的表;删除数据时,会使用ID进行取余后路由到相应表进行删除;修改数据、查询单个数据和分页查询等功能也遵循类似规则。分页查询时,ShardingJDBC会先将每个表执行一次查询,再进行排序和归并,确保查询结果的正确性。

在处理过程中可能会遇到一些问题,如ClassNotFoundException:com.alibaba.druid.pool.DruidDataSource,这可能是因为依赖未正确导入。解决方法是检查依赖是否完整,并确保其版本兼容。在运行项目时,如果遇到Failed to determine a suitable driver class问题,可以通过添加yaml配置来解决。

在实战中,通过ShardingJDBC可以实现高效的分库分表操作,提升数据库的查询性能。后续章节将探讨如何解决排序问题,记录 php 源码以及可能的替代方案,如禁止跳表或者结合ES实现搜索引擎处理。

shardingsphere源码阅读-兼容jdbc规范

JDBC规范提供一套标准,让不同数据库厂商遵循统一接口操作数据库,从而简化应用程序开发。shardingsphere兼容此规范,通过重写接口实现兼容。

基于JDBC规范,shardingsphere采用适配器模式重写DataSource、Connection、Statement、ResultSet等关键接口,构建了一套完整的实现方案。适配器模式确保了shardingsphere能够以与JDBC规范一致的方式操作数据库,同时支持分库分表功能。

shardingsphere中,JdbcObject接口代表JDBC规范中的核心接口,包括DataSource、Connection、Statement等。通过包装器接口Wrapper以及其子类WrapperAdapter,nucleus plus 源码shardingsphere实现了适配器模式,重写了这些接口的方法,同时保留了与JDBC规范的兼容性。

AbstractUnsupportedOperationJdbcObject和AbstractJdbcObjectAdapter作为抽象类,分别用于实现部分和全部接口方法。ShardingIdbcObject继承自AbstractJdbcObjectAdapter,包括ShardingDataSource、ShardingConnection、ShardingStatement等对象,这些对象都采用适配器模式重写JDBC规范接口,确保与JDBC规范无缝衔接。

以ShardingDataSource为例,其构造过程通过ShardingDataSourceFactory创建ShardingDataSource对象,将数据源、分库分表规则和属性等信息整合,同时初始化运行时上下文和静态代码块加载路由、SQL重写、结果集引擎等组件。ShardingDataSource内部的WrapperAdapter类维护方法调用信息,通过recordMethodInvocation和replayMethodsInvocation方法记录和回放方法调用。

AbstractDataSourceAdapter作为数据源适配器的抽象类,封装公共属性和方法,减少重复代码。此类中的dataSourceMap和databaseType属性分别保存数据源信息和数据库类型,getRuntimeContext方法用于获取分库分表的运行时上下文。

综上所述,shardingsphere通过适配器模式重写JDBC规范接口,实现了与JDBC规范的兼容性。不论使用sharding-jdbc还是原生JDBC,操作数据库的方式和流程保持一致,只是在实现细节上支持了分库分表功能,为开发者提供了一种灵活且高效的数据库管理方案。

sharding-jdbc分片策略(行分片策略踩坑笔记)

sharding-jdbc行分片策略默认不支持按分片键的范围查询

在开发时,对主键id做了范围查询。结果遇到如下报错:

Errorqueryingdatabase.Cause:java.lang.IllegalStateException:Inlinestrategycannotsupportrangesharding.原因:使用行分片策略原先的sharding-jdbc的分片策略配置是:

sharding:binding-tables:tableNametables:tableName:actual-data-nodes:ds0.tableName_$->{ 0..1}table-strategy:inline:sharding-column:idalgorithm-expression:tableName_$->{ id%2}上面的配置,使用了主键id作为单分片键,行表达式的分片策略。该分片策略只支持=和in操作符,并不支持范围查询。如果你想要使用范围查询,你需要配置开启标准策略。

解决方案:使用标准分片策略对应配置:

sharding:binding-tables:tableNametables:tableName:table-strategy:standard:#用于单分片键的标准分片场景sharding-column:id#分片列名称precise-algorithm-class-name:com.project.com.PreciseModuloAlgorithm#精确分片算法类名称,用于=和IN。。该类需实现PreciseShardingAlgorithm接口并提供无参数的构造器range-algorithm-class-name:com.project.com.component.RangeModuloAlgorithm#范围分片算法类名称,用于BETWEEN,可选。该类需实现RangeShardingAlgorithm接口并提供无参数的构造器问题具体可参考,官方github上的issues提问:/manual/sharding-jdbc/configuration/config-yaml/

对于具体的分片算法类,可参考官方github上的example:/apache/shardingsphere-example

分片算法类需要自己根据实际场景进行开发,这里贴出官方example里的实现类:

publicfinalclassPreciseModuloAlgorithmimplementsPreciseShardingAlgorithm<Integer>{ @OverridepublicStringdoSharding(finalCollection<String>availableTargetNames,finalPreciseShardingValue<Integer>shardingValue){ for(Stringeach:availableTargetNames){ if(each.endsWith(shardingValue.getValue()%+"")){ returneach;}}thrownewUnsupportedOperationException();}}publicfinalclassRangeModuloAlgorithmimplementsRangeShardingAlgorithm<Integer>{ @OverridepublicCollection<String>doSharding(finalCollection<String>availableTargetNames,finalRangeShardingValue<Integer>shardingValue){ Collection<String>result=newLinkedHashSet<>(availableTargetNames.size());intminValue=shardingValue.getValueRange().hasLowerBound()?shardingValue.getValueRange().lowerEndpoint():Integer.MIN_VALUE;intmaxValue=shardingValue.getValueRange().hasUpperBound()?shardingValue.getValueRange().upperEndpoint():Integer.MAX_VALUE;//最大值减最小值,得到差longrange=BigInteger.valueOf(maxValue).subtract(BigInteger.valueOf(minValue)).longValue();//最小值得绝对值除的余数intbegin=Math.abs(minValue)%;//超过9直接返回可用的表名,这里的9是,自己的分片策略值//假设我的分片策略是:对id除以,取余数if(range>9){ returnavailableTargetNames;}//如果差在分片策略内的,就直接取余数,得到对应的表名for(inti=begin;i<=range;i+=1){ for(Stringeach:availableTargetNames){ if(each.endsWith(i+"")){ result.add(each);}}}returnresult;}}sharding-jdbc分片策略分片策略包含分片键和分片算法,由于分片算法的独立性,将其独立抽离。真正可用于分片操作的是分片键+分片算法,也就是分片策略。目前提供5种分片策略。

标准分片策略对应StandardShardingStrategy。提供对SQL语句中的=,>,<,>=,<=,IN和BETWEENAND的分片操作支持。StandardShardingStrategy只支持单分片键,提供PreciseShardingAlgorithm和RangeShardingAlgorithm两个分片算法。PreciseShardingAlgorithm是必选的,用于处理=和IN的分片。RangeShardingAlgorithm是可选的,用于处理BETWEENAND,>,<,>=,<=分片,如果不配置RangeShardingAlgorithm,SQL中的BETWEENAND将按照全库路由处理。

复合分片策略对应ComplexShardingStrategy。复合分片策略。提供对SQL语句中的=,>,<,>=,<=,IN和BETWEENAND的分片操作支持。ComplexShardingStrategy支持多分片键,由于多分片键之间的关系复杂,因此并未进行过多的封装,而是直接将分片键值组合以及分片操作符透传至分片算法,完全由应用开发者实现,提供最大的灵活度。

行表达式分片策略对应InlineShardingStrategy。使用Groovy的表达式,提供对SQL语句中的=和IN的分片操作支持,只支持单分片键。对于简单的分片算法,可以通过简单的配置使用,从而避免繁琐的Java代码开发,如:t_user_$->{ u_id%8}表示t_user表根据u_id模8,而分成8张表,表名称为t_user_0到t_user_7。

Hint分片策略对应HintShardingStrategy。通过Hint指定分片值而非从SQL中提取分片值的方式进行分片的策略。

不分片策略对应NoneShardingStrategy。不分片的策略。

ShardingJdbc+Mybatis实现多数据源

实现Mybatis与多数据源结合的步骤如下:

首先,确保项目依赖正确,这与单数据源项目的依赖设置一致。

接着,配置Mybatis使用数据源的方式。这里采用注解方法,相关的类包括:注解类、枚举类、连接池配置信息类、用于存储数据源变量的ThreadLocal类,以及继承自AbstractRoutingDataSource的切面类和DruidConfig配置类。

在application配置文件中,定义数据源配置信息。

编写测试类,包含Mapper接口和对应的Mapper XML文件。在测试类中,执行不同方法,如list和listSharding。观察结果,list方法直接查询order_info表,而listSharding则从分表中获取数据,这验证了分表策略的正确实现。

整合Mybatis与多数据源的流程适用于实际场景,尤其在使用Mybatis的项目中常见。同时,Mybatisplus的整合也是常见的需求。后续文章将深入探索更多相关整合技术,希望能为读者提供帮助。

项目代码可以参考地址:gitee.com/shen-chuhao/w...

shardingjdbcåtddlçåºå«

shardingjdbcæ¯å½å½ç½çå é¨ååºå表ä¸é´ä»¶ï¼ç®åå·²ç»å¼æºï¼å¯ä»¥å¨githubä¸è¿è¡è·åï¼èTDDLåæ¯é¿éå é¨çååºå表ä¸é´ä»¶ï¼ç®åå°æªå¼æºï¼æ¬è´¨ä¸é½æ¯JDBCçä¸ç§åè£ ã详ç»è§ä¸å¾2024-11-30 13:45

2024-11-30 13:09

2024-11-30 12:58

2024-11-30 12:06

2024-11-30 11:56