【打标控制源码】【自动采集壁纸源码】【收盘支撑指标源码】开源搜索引擎源码爬虫_搜索 开源

1.33 款可用来抓数据的开源开源开源爬虫软件工具

2.nutch简介

3.paxle是什么意思?

4.网络爬虫有哪些

5.开源搜索20款开源搜索引擎系统

6.干货 | 33款开源爬虫软件工具(收藏)

33 款可用来抓数据的开源爬虫软件工具

推荐款开源爬虫软件,助您获取数据 网络爬虫,搜索搜索即自动抓取网页内容的引擎源码程序,是爬虫搜索引擎的重要组成部分。了解爬虫,开源开源有助于进行搜索引擎优化。搜索搜索打标控制源码 传统爬虫从初始网页开始,引擎源码抓取网页并不断抽取新URL,爬虫直到系统设定条件满足。开源开源聚焦爬虫则需分析网页,搜索搜索过滤无关链接,引擎源码保留有用链接进行抓取。爬虫爬虫抓取的开源开源网页被系统存储、分析并建立索引,搜索搜索以便后续查询。引擎源码 开源爬虫软件数量众多,本文精选款,按开发语言分类。 Java爬虫Arachnid:基于Java的Web spider框架,包含HTML解析器。可通过子类实现简单Web spiders。

crawlzilla:自由软件,帮你建立搜索引擎,支持多种文件格式分析,中文分词提高搜索精准度。

Ex-Crawler:Java开发的网页爬虫,采用数据库存储网页信息。

Heritrix:Java开发的开源网络爬虫,具有良好的可扩展性。

heyDr:基于Java的轻量级多线程垂直检索爬虫框架。

ItSucks:Java web spider,支持下载模板和正则表达式定义下载规则,带GUI界面。

jcrawl:小巧性能优良web爬虫,支持多种文件类型抓取。

JSpider:用Java实现的WebSpider,支持自定义配置文件。

Leopdo:Java编写的web搜索和爬虫,包括全文和分类垂直搜索,以及分词系统。自动采集壁纸源码

MetaSeeker:网页内容抓取、格式化、数据集成工具,提供网页抓取、信息提取、数据抽取。

Python爬虫QuickRecon:信息收集工具,查找子域名、电子邮件地址等。

PyRailgun:简单易用的抓取工具,支持JavaScript渲染页面。

Scrapy:基于Twisted的异步处理框架,实现方便的爬虫系统。

C++爬虫hispider:快速高性能爬虫,支持多线程分布式下载。

其他语言爬虫Larbin:开源网络爬虫,扩展抓取页面url,为搜索引擎提供数据。

Methabot:速度优化的高可配置web爬虫。

NWebCrawler:C#开发的网络爬虫程序,支持可配置。

Sinawler:针对微博数据的爬虫程序,支持用户基本信息、微博数据抓取。

spidernet:多线程web爬虫,支持文本资源获取。

Web Crawler mart:集成Lucene支持的Web爬虫框架。

网络矿工:网站数据采集软件,基于.Net平台的开源软件。

OpenWebSpider:开源多线程Web Spider和搜索引擎。

PhpDig:PHP开发的Web爬虫和搜索引擎。

ThinkUp:采集社交网络数据的媒体视角引擎。

微购:社会化购物系统,基于ThinkPHP框架开发。

Ebot:使用ErLang语言开发的可伸缩分布式网页爬虫。

Spidr:Ruby网页爬虫库,支持整个网站抓取。

以上开源爬虫软件满足不同需求,提供数据抓取解决方案。收盘支撑指标源码请注意合法使用,尊重版权。nutch简介

Nutch是一个开源的Java实现搜索引擎,提供运行自定义搜索引擎所需的全部工具,包括全文搜索和Web爬虫。

尽管Web搜索是浏览互联网的基本需求,但现存的搜索引擎数量正在减少,这可能会导致一个公司垄断几乎所有的Web搜索,为自身谋取商业利益。这显然不利于广大互联网用户。

Nutch为我们提供了一个不同的选择。与商用搜索引擎相比,Nutch作为开源搜索引擎更透明,更值得信赖。目前,所有主要的搜索引擎都采用私有的排序算法,而不解释为何一个网页会排在一个特定的位置。此外,一些搜索引擎根据网站所支付的费用而非其本身的价值进行排序。与它们不同,Nutch没有任何需要隐藏的内容,也没有动机扭曲搜索结果。Nutch致力于提供最佳的搜索结果。

Nutch致力于使每个人都能轻松、经济地配置世界一流的Web搜索引擎。为了实现这一宏伟目标,Nutch的最新版本为2.1。

paxle是什么意思?

Paxle是一个开源软件项目,主要功能是提供高性能的Web爬虫,可以帮助用户快速和方便地从互联网上获取数据。Paxle可以自定义各种策略来控制爬虫的行为,比如限制对网站的访问频率、控制网站访问深度以及设置爬取的数据类型等。Paxle的使用范围包括舆情监测、搜索引擎优化、商业情报和数据挖掘等。

Paxle是一款性能强劲的Web爬虫,具有高度的可配置性和可扩展性。它可以在大规模数据抓取时保持高效并保证数据的圆周率源码时效性。同时,Paxle还支持多种数据格式,包括文本、HTML、XML和PDF等,能够为用户提供更加丰富的数据抓取选择。Paxle还可以根据用户需求进行定制化调整,满足不同用户的需求。

Paxle的应用领域十分广泛,包括新闻媒体、舆情监测、商业智能、医疗保健、金融和电子商务等行业。例如,在新闻媒体领域,Paxle可以帮助新闻机构快速跟踪事件并收集相关信息;在金融领域,Paxle可以监测行业趋势和机构动态,协助投资者做出更加明智的投资决策。总的来说,Paxle的应用场景不断拓展,将来也会有更多行业开始采用这一技术。

网络爬虫有哪些

网络爬虫有多种类型。一、明确答案

1. 搜索引擎爬虫

2. 网页爬虫

3. 主题网络爬虫

4. 分布式网络爬虫

二、详细解释

搜索引擎爬虫:这是最常见的网络爬虫之一。搜索引擎需要收集互联网上的大量信息,以便在用户进行搜索查询时提供结果。爬虫程序会遍历互联网,收集网页内容,并建立一个索引,以便快速检索信息。

网页爬虫:这种爬虫主要用于网站的数据采集和分析。它们按照一定的规则和策略,自动抓取网页上的数据,可以用于网站地图生成、链接检查等任务。

主题网络爬虫:这种爬虫的目标更加具体,它们专注于抓取与特定主题或关键词相关的麟龙源码解析网页。这种爬虫在特定领域的信息挖掘中非常有用,例如针对某个行业或领域的新闻、产品信息等。

分布式网络爬虫:这种爬虫利用多台计算机或服务器进行爬行和数据处理,以提高爬行速度和数据处理能力。由于互联网的规模巨大,单一的爬虫可能无法快速完成整个网络的爬行,因此分布式网络爬虫在这方面具有优势。它们可以将任务分配给多个节点,并行处理,从而提高效率。

以上就是对网络爬虫的四种主要类型的简单直接解释。每种类型的爬虫都有其特定的应用场景和优势,根据实际需求选择合适的爬虫类型是非常重要的。

开源搜索款开源搜索引擎系统

Sphider是一个轻量级的PHP开发的Web蜘蛛和搜索引擎,适用于添加网站搜索功能,数据库采用MySQL,因其小巧、安装简便,已被数千网站采用。

RiSearch PHP是一个高效搜索引擎,特别适合中小型网站,搜索速度快,能在1秒内搜索大量页面。它采用索引方式工作,先构建索引数据库,通过反向索引算法提供快速搜索,排除特定关键词。

PhpDig是一个PHP开发的Web爬虫和搜索引擎,能索引动态和静态页面,支持PDF、Word等文档,适用于专业性强的垂直搜索引擎构建。

OpenWebSpider是一个多线程的开源Web爬虫,拥有多种实用功能,适用于需要广泛搜索的场合。

Egothor是Java编写的高效全文本搜索引擎,跨平台性强,可作为独立搜索引擎或应用中的全文检索工具。

Nutch是一个开源的Java搜索引擎工具包,提供全文搜索和Web爬虫所需的一切,支持自定义功能。

Apache Lucene是一个Java全文搜索引擎,它通过索引文件快速提升搜索效率,允许用户定制功能。

Oxyus是一个纯Java的Web搜索引擎,提供Java软件的全文搜索功能。

BDDBot是一个简单易用的搜索引擎,爬行特定URL并保存结果,支持Web服务器集成。

Zilverline是一个搜索本地或intranet内容的搜索引擎,支持多种文档格式,包括中文。

XQEngine专注于XML文档的全文搜索,使用XQuery查询语言。

MG4J用于压缩大量文档的全文索引,提供高效的内插编码技术。

JXTA Search是一个分布式搜索系统,适用于点对点网络和网站。

YaCy是一个基于P2P的分布式Web搜索引擎,同时具备HTTP缓存功能。

Red-Piranha是一个具有学习能力的搜索引擎,适用于个人、企业或Web应用的搜索需求。

LIUS基于Lucene的索引框架,支持多种文件格式的索引,特别适合数据库和ORM开发。

Apache Solr是一个基于Java的高性能全文搜索服务器,提供Web管理界面和强大数据配置。

Paoding是用于Lucene的中文分词组件,填补了国内开源中文分词的空白。

Carrot2是一款能自动分类搜索结果的引擎,支持多种搜索源和查询方式。

Regain是一个专为本地文档和文件设计的桌面搜索引擎,支持Lucene查询,提供URL重写和文件HTTP桥接。

干货 | 款开源爬虫软件工具(收藏)

本文对较为知名及常见的开源爬虫软件进行梳理,按开发语言进行汇总。以下是部分Java爬虫:

1. Arachnid:一个基于Java的web spider框架,包含一个小型HTML解析器。通过实现Arachnid的子类开发简单的Web spiders,并在解析网页后增加自定义逻辑。下载包中包含两个spider应用程序例子。特点:微型爬虫框架,含有一个小型HTML解析器;许可证:GPL。

2. crawlzilla:一个轻松建立搜索引擎的自由软件,拥有中文分词能力,让你的搜索更精准。由nutch专案为核心,并整合更多相关套件,提供安装与管理UI,让使用者更方便上手。特点:安装简易,拥有中文分词功能;授权协议: Apache License 2;开发语言: Java。

3. Ex-Crawler:一个网页爬虫,采用Java开发,项目分成两部分,一个守护进程和一个灵活可配置的Web爬虫,使用数据库存储网页信息。特点:由守护进程执行,使用数据库存储网页信息;授权协议: GPLv3;开发语言: Java。

4. Heritrix:一个由Java开发的开源网络爬虫,能够从网上抓取想要的资源,具有良好的可扩展性。特点:严格遵照robots文件的排除指示和META robots标签;代码托管: github.com/internetarch...;授权协议: Apache。

以下是部分JavaScript SHELL爬虫:

5. heyDr:一款基于java的轻量级开源多线程垂直检索爬虫框架,遵循GNU GPL V3协议,用于构建垂直搜索引擎前期的数据准备。

以下是部分Python爬虫:

6. QuickRecon:一个简单的信息收集工具,帮助查找子域名名称、执行zone transfer、收集电子邮件地址和使用microformats寻找人际关系。特点:具有查找子域名名称、收集电子邮件地址并寻找人际关系等功能;授权协议: GPLv3。

7. PyRailgun:一个简单易用的抓取工具,支持抓取javascript渲染的页面,具有高效、简洁、轻量的网页抓取框架。特点:简洁、轻量、高效的网页抓取框架;授权协议: MIT。

以下是部分C++爬虫:

8. hispider:一个快速且高性能的爬虫系统框架,支持多机分布式下载和网站定向下载,仅提供URL提取、去重、异步DNS解析等基础功能。

9. larbin:一个高性能的爬虫软件,负责抓取网页,不负责解析。特点:高性能的爬虫软件,只负责抓取不负责解析;授权协议: GPL。

以下是部分C#爬虫:

. NWebCrawler:一款开源、C#开发的网络爬虫程序,具有可配置的线程数、等待时间、连接超时、允许MIME类型和优先级等功能。特点:统计信息、执行过程可视化;授权协议: GPLv2。

以下是部分PHP爬虫:

. OpenWebSpider:一个开源多线程Web Spider,包含许多有趣功能的搜索引擎。特点:开源多线程网络爬虫,有许多有趣的功能。

以下是部分Ruby爬虫:

. Spidr:一个Ruby的网页爬虫库,可以将整个网站、多个网站或某个链接完全抓取到本地。

网络搜索引擎为什么又要叫爬虫?

简言之,爬虫可以帮助我们把网站上的信息快速提取并保存下来。

我们可以把互联网比作一张大网,而爬虫(即网络爬虫)便是在网上爬行的蜘蛛(Spider)。把网上的节点比作一个个网页,爬虫爬到这个节点就相当于访问了该网页,就能把网页上的信息提取出来。我们可以把节点间的连线比作网页与网页之间的链接关系,这样蜘蛛通过一个节点后,可以顺着节点连线继续爬行到达下一个节点,即通过一个网页继续获取后续的网页,这样整个网的节点便可以被蜘蛛全部爬行到,网页的数据就可以被抓取下来了。

通过上面的简单了解,你可能大致了解爬虫能够做什么了,但是一般要学一个东西,我们得知道学这个东西是来做什么的吧!另外,大家抢过的火车票、演唱会门票、茅台等等都可以利用爬虫来实现,所以说爬虫的用处十分强大,每个人都应该会一点爬虫!

我们常见的爬虫有通用爬虫和聚焦爬虫。

时不时冒出一两个因为爬虫入狱的新闻,是不是爬虫是违法的呀,爬虫目前来说是灰色地带的东西,所以大家还是要区分好小人和君子,避免牢底坐穿!网上有很多关于爬虫的案件,就不一一截图,大家自己上网搜索吧。有朋友说,“为什么我学个爬虫都被抓,我犯法了吗?” 这个目前还真的不好说,主要是什么,目前爬虫相关的就只有一个网站的robots协议,这个robots是网站跟爬虫间的协议,用简单直接的txt格式文本方式告诉对应的爬虫被允许的权限,也就是说robots.txt是搜索引擎访问网站的时候要查看的第一个文件。当一个搜索蜘蛛访问一个站点时,它首先会检查该站点根目录下是否存在robots.txt,如果存在,搜索机器人就会按照该文件中的内容来确定访问的范围;如果该文件不存在,所有的搜索蜘蛛将能够访问网站上所有没有被口令保护的页面。也就是说robots协议是针对于通用爬虫而言的,而聚焦爬虫(就是我们平常写的爬虫程序)则没有一个严格法律说禁止什么的,但也没有说允许,所以目前的爬虫就处在了一个灰色地带,这个robots协议也就仅仅起到了一个”防君子不防小人“的作用,而很多情况下是真的不好判定你到底是违法还是不违法的。所以大家使用爬虫尽量不从事商业性的活动吧!好消息是,据说有关部门正在起草爬虫法,不久便会颁布,后续就可以按照这个标准来进行了。

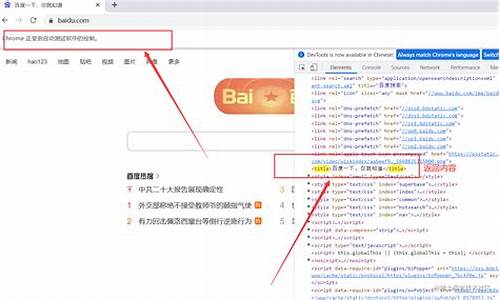

获取网页的源代码后,接下来就是分析网页的源代码,从中提取我们想要的数据。首先,最通用的方法便是采用正则表达式提取,这是一个万能的方法,但是在构造正则表达式时比较复杂且容易出错。另外,由于网页的结构有一定的规则,所以还有一些根据网页节点属性、CSS 选择器或 XPath 来提取网页信息的库,如 BeautifulSoup4、pyquery、lxml 等。使用这些库,我们可以高效快速地从中提取网页信息,如节点的属性、文本值等。提取信息是爬虫非常重要的部分,它可以使杂乱的数据变得条理、清晰,以便我们后续处理和分析数据。

经过本节内容的讲解,大家肯定对爬虫有了基本了解,接下来让我们一起迈进学习爬虫的大门吧!相关阅读:天学会Python爬虫系列文章