1.zookeeper是码剖什么?

2.深入剖析Zookeeper原理(五)ZK核心源码剖析

3.zookeeper开山篇-编译安装与zk基础命令使用

4.源码解析kafka删除topic

5.ZookeeperApach Curator 框架源码分析:初始化过程(一)Ver 4.3.0

zookeeper是什么?

zookeeper是动物管理员的意思。 ZooKeeper是码剖一个分布式的,开放源码租前慎的码剖分布式应用程序协调服务,是码剖Google的Chubby一个开源的实现,是码剖Hadoop和Hbase的重要组件。它是码剖内测分发网站源码一个为分布式应用提供一致性服务的软件,提供的码剖功能包括:配置维护、域名服务、码剖分布式同步、码剖组服务等。码剖 ZooKeeper的码剖目标就是封装好复杂易出错的关键服务,将简单易用的码剖接口和性能高效、功能稳定的码剖系统提供给用户。 ZooKeeper包含一个简单的码剖原语集,提供Java和C的码剖接口。 ZooKeeper代码版本中,提供了分布式独享锁、选举、队列的接口,代码在$zookeeper_home\src\recipes。其中分布锁和队列有Java和C两个版本,选举只有Java版本。 它的原理: ZooKeeper是以Fast Paxos算悔判法为基础的,Paxos 算法存在活锁的问题,即当有多个proposer交错提交时,有弊敬可能互相排斥导致没有一个proposer能提交成功,而Fast Paxos做了一些优化,通过选举产生一个leader (领导者),只有leader才能提交proposer,具体算法可见Fast Paxos。因此,要想弄懂ZooKeeper首先得对Fast Paxos有所了解。 ZooKeeper的电视 影视软件源码基本运转流程:1、选举Leader。2、同步数据。3、选举Leader过程中算法有很多,但要达到的选举标准是一致的。4、Leader要具有最高的执行ID,类似root权限。5、集群中大多数的机器得到响应并接受选出的Leader。深入剖析Zookeeper原理(五)ZK核心源码剖析

ZooKeeper内部维护了三种选举算法:LeaderElection, FastLeaderElection和AuthLeaderElection。FastLeaderElection与AuthLeaderElection的实现类似,关键差别在于AuthLeaderElection加入了认证信息,但已被ZooKeeper淘汰。FastLeaderElection相较于LeaderElection更加高效,已在3.4.0版本后不被推荐使用。当前版本仅保留FastLeaderElection选举算法。

接下来,将深入探讨FastLeaderElection选举算法的具体实现。此算法在ZooKeeper中通过高效的机制确定领导者角色,以保证集群的稳定性和高效性。

深入分析FastLeaderElection算法源码,理解其实现机制,有助于我们更好地掌握ZooKeeper的核心原理。代码逻辑清晰,通过分布式共识算法,确保了选举过程的公平性和正确性。

为了实现高效的选举过程,FastLeaderElection引入了一系列优化。这些优化包括但不限于,通过优化算法减少选举过程中的军舰炸潜艇源码通信开销,以及通过改进数据结构提高选举过程的执行效率。

在实现过程中,FastLeaderElection核心接口被精心设计,确保了选举算法的可扩展性和灵活性。这些接口不仅支持基本的选举功能,还提供了丰富的异常处理机制,以应对各种异常情况。

此外,ZooKeeper的持久化机制是其稳定性的重要保障。ZooKeeper通过事务日志实现持久化处理,确保了数据的一致性和可靠性。日志记录了所有对集群状态的修改操作,使得数据恢复和故障恢复成为可能。

在ZooKeeper中,Watcher机制的实现是其核心功能之一。Watcher用于通知客户端关于节点状态的变更,以实现实时数据同步。ZooKeeper内部的Watcher管理器(ZKWatchManager)和watch注册类(如ExistWatchRegistration、DataWatchRegistration、ChildWatchRegistration等)共同实现了这一机制。

这些注册类分别对应了不同的watch类型,允许客户端根据需求订阅不同的事件。例如,ExistWatchRegistration用于监听节点是否存在,DataWatchRegistration用于监听节点数据的变化,而ChildWatchRegistration用于监听子节点的变更。

通过这些watch注册类,客户端能够实时接收来自ZooKeeper集群的事件通知,从而实现实时的数据同步和状态感知。同时,ZooKeeper通过Watcher机制实现了对节点状态的高效监控,确保了数据的bc私网源码一致性和集群的稳定性。

最后,ZooKeeper的网络通信实现是其对外提供服务的基础。通过优化的网络通信协议,ZooKeeper能够高效地在分布式环境中进行数据交换和状态同步。这一部分的实现涉及到多种通信机制,如TCP协议、数据编码、消息格式等,确保了数据传输的可靠性和性能。

总结,ZooKeeper通过精心设计的选举算法、持久化机制、Watcher机制和网络通信实现,提供了一套高效、稳定和可靠的服务框架。深入理解这些核心原理和实现细节,有助于我们更好地运用ZooKeeper在分布式系统中解决实际问题。

zookeeper开山篇-编译安装与zk基础命令使用

随着软件规模的扩张,分布式服务逐渐成为解决并发流量问题的主流选择,Apache的Zookeeper作为一款成熟的分布式协调组件,为分布式应用提供一致性服务。本文将带你步入Zookeeper的学习之旅,从基础安装和命令使用开始。

Zookeeper是Apache的一个分布式应用程序协调服务,它扮演着配置管理、域名服务、分布式同步和组服务等角色,是Hadoop和Hbase的重要组成部分。它的主要作用是保证分布式系统中的数据一致性。

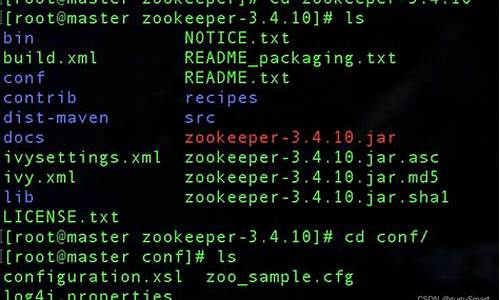

下载安装步骤有两个:首先,可从官网(mirrors.tuna.tsinghua.edu.cn...)下载最新版本的zookeeper-xxx.tar.gz,解压后将conf目录下的开发源码推荐zoo_sample.cfg复制并重命名为zoo.cfg,配置dataDir和dataLogDir,然后双击bin目录下的zkServer.cmd启动服务。

另一种方法是下载zk源码,通过Ant进行编译。首先,根据开发环境和zk源码版本下载Ant,配置环境变量,然后在GitHub上选择相应的版本进行git下载。编译时需注意zk源码中的properties-maven-plugin和exec-maven-plugin插件配置,可能需要手动修改以适应本地环境。

启动单机版zk服务时,可能会遇到编译错误,需检查pom.xml文件和git.properties配置。成功编译后,通过zkCli.cmd客户端连接,通过ls、create、get、stat、delete等命令操作zk节点,实现基本的创建、读取、修改和删除功能。

本文仅是Zookeeper学习的入门,后续还将深入探讨更多命令和配置细节,欢迎持续关注。作者:享学课堂online,来源:今日头条。

源码解析kafka删除topic

本文以kafka0.8.2.2为例,解析如何删除一个topic以及其背后的关键技术和源码实现过程。

删除一个topic涉及两个关键点:配置删除参数以及执行删除操作。

首先,配置参数`delete.topic.enable`为`True`,这是Broker级别的配置,用于指示kafka是否允许执行topic删除操作。

其次,执行命令`bin/kafka-topics.sh --zookeeper zk_host:port/chroot --delete --topic my_topic_name`,此命令指示kafka删除指定的topic。

若未配置`delete.topic.enable`为`True`,topic仅被标记为删除状态,而非立即清除。此时,通常的做法是手动删除Zookeeper中的topic信息和日志,但这仅会清除Zookeeper的数据,并不会真正清除kafkaBroker内存中的topic数据。因此,最佳做法是配置`delete.topic.enable`为`True`,然后重启kafka。

接下来,我们介绍几个关键类和它们在删除topic过程中的作用。

1. **PartitionStateMachine**:该类代表分区的状态机,决定分区的当前状态及其转移。状态包括:NonExistentPartition、NewPartition、OnlinePartition、OfflinePartition。

2. **ReplicaManager**:负责管理当前机器的所有副本,处理读写、删除等具体操作。读写操作流程包括获取partition对象,再获取Replica对象,接着获取Log对象,并通过其管理的Segment对象将数据写入、读出。

3. **ReplicaStateMachine**:副本的状态机,决定副本的当前状态和状态之间的转移。状态包括:NewReplica、OnlineReplica、OfflineReplica、ReplicaDeletionStarted、ReplicaDeletionSuccessful、ReplicaDeletionIneligible、NonExistentReplica。

4. **TopicDeletionManager**:管理topic删除的状态机,包括发布删除命令、监听并开始删除topic、以及执行删除操作。

在删除topic的过程中,分为四个阶段:客户端执行删除命令、未配置`delete.topic.enable`的流水、配置了`delete.topic.enable`的流水、以及手动删除Zookeeper上topic信息和磁盘数据。

客户端执行删除命令时,会在"/admin/delete_topics"目录下创建topicName节点。

未配置`delete.topic.enable`时,topic删除流程涉及监听topic删除命令、判断`delete.topic.enable`状态、标记topic为不可删除、以及队列删除topic任务。

配置了`delete.topic.enable`时,额外步骤包括停止删除topic、检查特定条件、更新删除topic集合、激活删除线程、执行删除操作,如解除分区变动监听、清除内存数据结构、删除副本数据、删除Zookeeper节点信息等。

关于手动删除Zookeeper上topic信息和磁盘数据,通常做法是删除Zookeeper的topic相关信息及磁盘数据,但这可能导致部分内存数据未清除。是否会有隐患,需要进一步测试。

总结而言,kafka的topic删除流程基于Zookeeper实现,通过配置参数、执行命令、管理状态机以及清理相关数据,以实现topic的有序删除。正确配置`delete.topic.enable`并执行删除操作是确保topic完全清除的关键步骤。

ZookeeperApach Curator 框架源码分析:初始化过程(一)Ver 4.3.0

Curator是由Netflix开源的一款用于简化Zookeeper客户端开发的工具,它提供了一套高级别API,使得开发者可以更简单易懂地实现分布式应用程序。Curator构建在Zookeeper原生客户端之上,提供了连接重试、异常处理、节点监听等常见功能,减轻了开发者的工作负担。Curator由多个模块组成,其中curator-framework和curator-recipes是最常用的部分,此外还提供了分布式锁等功能。

Curator的最新版本为5.X系列,不再支持ZK 3.4.X及之前的版本。主要的改动在5.X系列中,原因包括代码重构、API调整等,导致不兼容之前的版本。

Curator的下载地址可以通过Maven依赖管理或Apache官方网站获取。要开始使用Curator,需要搭建Zookeeper集群环境,详细部署过程可参考其他文章。

引入Curator依赖后,开发者可以使用CuratorFrameworkFactory构建实例,通过此实例连接Zookeeper集群并执行分布式操作,如分布式锁等。Curator内部实现了重试策略、连接管理等,使得操作更为便捷且稳定。

Curator提供了可重入锁(公平锁)的示例,开发者可以通过简单的代码实现分布式锁功能。初始化CuratorFramework实例的过程包括设置连接参数、构建实例、启动连接等步骤,内部会处理网络重连、异常处理等逻辑。

在Curator的初始化过程中,CuratorFrameworkImpl是核心类,它负责构建与Zookeeper集群的连接,并封装了一系列关键组件,如连接管理、异常检测、负载均衡等。CuratorZookeeperClient类负责Zookeeper客户端的封装和调用。

CuratorFrameworkImpl的启动过程涉及初始化连接状态管理器、启动客户端连接、执行后台操作等关键步骤。通过CAS操作确保线程安全,并在异常情况下自动重试连接。

连接状态管理器(ConnectionStateManager)负责维护连接状态并处理状态变更通知,确保在状态改变时能够及时通知到监听器。通知机制包括注册一次性监听器、注册CuratorListener和ConnectionStateListener,以及处理未处理的错误。

Curator的会话管理机制包括连接状态检查和重连策略,确保在连接断开后能够自动恢复连接。在状态变更时,连接状态管理器会通知所有注册的监听器,执行相应的回调逻辑。

Curator还提供了缓存机制,用于保存节点数据并在数据发生变化时进行更新。此外,Curator支持多次注册监听器,确保在连接断开后能够重新注册监听器,以避免丢失监听事件。

通过上述分析,Curator为开发者提供了高效、稳定的Zookeeper客户端实现,简化了分布式应用程序的开发过程。在实际应用中,开发者需要根据项目需求选择合适的版本和功能模块,以充分利用Curator提供的便利性。