本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.免费高性能虚拟化Mac的开源软件VirtualBuddy

2.RegexBuddy正则表达式编辑工具V421破解版RegexBuddy正则表达式编辑工具V421破解版功能简介

3.linux内核源码:内存管理——内存分配和释放关键函数分析&ZGC垃圾回收

4.Linux中的内存分配--slab(1)

5.CI工具选型分析

6.Linux内核源码解析---万字解析从设计模式推演per-cpu实现原理

免费高性能虚拟化Mac的开源软件VirtualBuddy

最新Mac改用ARM芯片后,市面上虚拟化软件如VMware和VirtualBox无法完美虚拟化macOS。VirtualBuddy则为Apple Silicon用户提供了完美的macOS虚拟化解决方案。支持macOS 及以上版本,同时兼容Ubuntu,但不支持Windows。智慧城市源码搭建教程

VirtualBuddy基于MacOS的Hypervisor.framework开发,使用Swift语言编写,具备多项特性。软件开源,用户可在GitHub(github.com/insidegui/Vi...)获取源代码,自行编译或下载已编译版本。推荐下载最新版1.4.1(github.com/insidegui/Vi...),安装步骤简单,下载VirtualBuddy_v1.4.1-.dmg后安装即可。

VirtualBuddy在安装后支持常用软件,如企业微信、钉钉和Xcode等,性能表现不错,未出现明显卡顿、延迟问题。此外,软件内置GuestApp,提供剪贴板共享和文件共享功能,启动虚拟机后,通过Finder侧边栏选择Guest磁盘,双击VirtualBuddyGuest应用图标即可使用。

对于Mac开发者,VirtualBuddy能在多个macOS版本(尤其是测试版)上高效测试应用程序,提供彻底隔离环境,且性能损失较小。作为替代虚拟化软件的优质选择,VirtualBuddy在Mac虚拟化领域展现出其独特价值。

RegexBuddy正则表达式编辑工具V破解版RegexBuddy正则表达式编辑工具V破解版功能简介

大家好,seo超级外链源码关于RegexBuddy(正则表达式编辑工具) V4.2.1 破解版,RegexBuddy(正则表达式编辑工具) V4.2.1 破解版功能简介这个很多人还不知道,现在让我们一起来看看吧!RegexBuddy破解版是一款非常好用的正则表达式编辑工具。本软件能帮助你编写需要的正则表达式,它还可以在你的源代码中根据 你所使用的语言自动生成相应的正则表达式。还支持可视化的调试,带来软件测试方面的便利;支持正则式转换为多种语言的字串,还并提供了代码输出功能。使用说明

本软件为RegEx Builder绿色破解版,安装时选择第一项即可正常打开使用,功能无限制完全使用。软件功能

1、自动生成正则表达式 2、编辑并测试正则表达式 3、多向导页,可在多个源文本上测试同一个正则表达式(标准版无此功能) 4、多页参考生成正则表达式(标准版无此功能) 5、自动检查和修改生成的正则表达式的正确性 6、以可视方式呈现测试结果linux内核源码:内存管理——内存分配和释放关键函数分析&ZGC垃圾回收

本文深入剖析了Linux内核源码中的内存管理机制,重点关注内存分配与释放的关键函数,通过分析4.9版本的源码,详细介绍了slab算法及其核心代码实现。在内存管理中,slab算法通过kmem_cache结构体进行管理,利用数组的形式统一处理所有的kmem_cache实例,通过size_index数组实现对象大小与kmem_cache结构体之间的映射,从而实现高效内存分配。其中,关键的计算方法是通过查找输入参数的最高有效位序号,这与常规的0起始序号不同,从1开始计数。

在找到合适的kmem_cache实例后,下一步是通过数组缓存(array_cache)获取或填充slab对象。若缓存中有可用对象,源码交易平台程序则直接从缓存分配;若缓存已空,会调用cache_alloc_refill函数从三个slabs(free/partial/full)中查找并填充可用对象至缓存。在对象分配过程中,array_cache结构体发挥了关键作用,它不仅简化了内存管理,还优化了内存使用效率。

对象释放流程与分配流程类似,涉及数组缓存的管理和slab对象的回收。在cache_alloc_refill函数中,关键操作是检查slab_partial和slab_free队列,寻找空闲的对象以供释放。整个过程确保了内存资源的高效利用,避免了资源浪费。

总结内存操作函数概览,栈与堆的区别是显而易见的。栈主要存储函数调用参数、局部变量等,而堆用于存放new出来的对象实例、全局变量、静态变量等。由于堆的动态分配特性,它无法像栈一样精准预测内存使用情况,导致内存碎片问题。为了应对这一挑战,Linux内核引入了buddy和slab等内存管理算法,以提高内存分配效率和减少碎片。

然而,即便使用了高效的内存管理算法,内存碎片问题仍难以彻底解决。在C/C++中,没有像Java那样的自动垃圾回收机制,导致程序员需要手动管理内存分配与释放。如果忘记释放内存,网页版捕鱼达人源码将导致资源泄漏,影响系统性能。为此,业界开发了如ZGC和Shenandoah等垃圾回收算法,以提高内存管理效率和减少内存碎片。

ZGC算法通过分页策略对内存进行管理,并利用“初始标记”阶段识别GC根节点(如线程栈变量、静态变量等),并查找这些节点引用的直接对象。此阶段采用“stop the world”(STW)策略暂停所有线程,确保标记过程的准确性。接着,通过“并发标记”阶段识别间接引用的对象,并利用多个GC线程与业务线程协作提高效率。在这一过程中,ZGC采用“三色标记”法和“remember set”机制来避免误回收正常引用的对象,确保内存管理的精准性。

接下来,ZGC通过“复制算法”实现内存回收,将正常引用的对象复制到新页面,将旧页面的数据擦除,从而实现内存的高效管理。此外,通过“初始转移”和“并发转移”阶段进一步优化内存管理过程。最后,在“对象重定位”阶段,完成引用关系的更新,确保内存管理过程的完整性和一致性。

通过实测,ZGC算法在各个阶段展现出高效的内存管理能力,尤其是标记阶段的效率,使得系统能够在保证性能的同时,有效地管理内存资源。数据库备份源码总之,内存管理是系统性能的关键因素,Linux内核通过先进的算法和策略,实现了高效、灵活的内存管理,为现代操作系统提供稳定、可靠的服务。

Linux中的内存分配--slab(1)

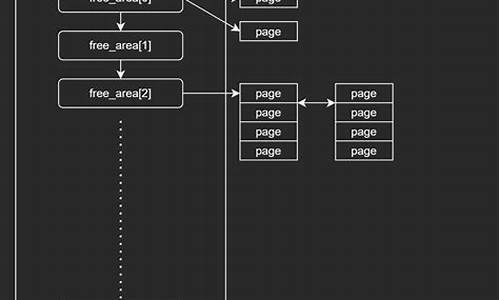

在Linux中,当内存分配遇到小于一页的需求时,为避免浪费和内碎片问题,slab分配器应运而生。slab分配器的核心机制是kmem_cache,它为每个对象类别维护一个"cache",分配和释放对象时都从对应的cache中进行,提高了效率。cache的内存来源于buddy伙伴系统,通过分页并按照对象大小划分,确保物理内存的连续性。

每个kmem_cache由若干slabs组成,每个slab由一个或多个页框构成,大小由gfporder定义。为了优化CPU缓存利用,slab引入了coloring机制,通过调整slab中的偏移量,确保相同对象号的对象不会对齐,从而减少缓存替换操作。

kmem_cache_node负责描述和管理slab中的对象,包含slab链表,根据NUMA架构进行内存分配。slab描述符中,s_mem和freelist分别指向第一个对象和空闲对象链表。空闲对象链表由数组组成,根据活跃对象动态调整。

本地CPU空闲链表作为kmem_cache的一部分,记录对象的释放,便于内存回收。通过slabtop命令,可以查看系统的slab分配情况,包括内存使用、cache数量、slabs数量以及object大小分布。此外,/proc/meminfo和/proc/slabinfo提供了更详细的内存使用信息。

深入理解slab分配器的更多内容,可以参考相关文章如《Slab Allocator (kernel.org)》、《The Slab Allocator in the Linux kernel (hammertux.github.io)》以及《linux内存源码分析 - SLAB分配器概述》等。

CI工具选型分析

持续集成工具选型分析指出,选择合适的工具对团队效率至关重要。关键因素包括易用性、安装简易性、云服务支持、容器兼容性以及开源社区支持。以下是主要工具的优劣势对比:

Jenkins,虽然历史悠久,但需依赖附加组件和插件以适应现代架构;CircleCI成本较低,配置简单,但本地部署困难且Clojure社区相对较小;TeamCity基于Java,Kubernetes部署镜像大;GitLab CI支持Kubernetes,但非GitLab源码管理工具不适用;Buddy本地部署按用户付费,价格昂贵;TravisCI使用Ruby,部署选项有限;GoCD虽开源,支持Kubernetes但不适用Java应用;Drone轻量级,Go语言编写,适合Kubernetes,但文档不完善;Spinnaker功能强大,但本地部署复杂;Buildbot用Python编写,性能一般,社区支持较少。

对于大部分团队,CircleCI或TravisCI足够满足需求。然而,追求高效和敏捷的开发者可能更倾向于Drone.io,它易于安装、配置,支持云和本地部署,且性能优于Python/Ruby编写的选项,具有云原生应用的特性。Jenkins则因其灵活性和社区支持,尽管在Kubernetes支持上不如其他新工具,仍是普遍选择。

Linux内核源码解析---万字解析从设计模式推演per-cpu实现原理

引子

在如今的大型服务器中,NUMA架构扮演着关键角色。它允许系统拥有多个物理CPU,不同NUMA节点之间通过QPI通信。虽然硬件连接细节在此不作深入讨论,但需明白每个CPU优先访问本节点内存,当本地内存不足时,可向其他节点申请。从传统的SMP架构转向NUMA架构,主要是为了解决随着CPU数量增多而带来的总线压力问题。

分配物理内存时,numa_node_id() 方法用于查询当前CPU所在的NUMA节点。频繁的内存申请操作促使Linux内核采用per-cpu实现,将CPU访问的变量复制到每个CPU中,以减少缓存行竞争和False Sharing,类似于Java中的Thread Local。

分配物理页

尽管我们不必关注底层实现,buddy system负责分配物理页,关键在于使用了numa_node_id方法。接下来,我们将深入探索整个Linux内核的per-cpu体系。

numa_node_id源码分析获取数据

在topology.h中,我们发现使用了raw_cpu_read函数,传入了numa_node参数。接下来,我们来了解numa_node的定义。

在topology.h中定义了numa_node。我们继续跟踪DECLARE_PER_CPU_SECTION的定义,最终揭示numa_node是一个共享全局变量,类型为int,存储在.data..percpu段中。

在percpu-defs.h中,numa_node被放置在ELF文件的.data..percpu段中,这些段在运行阶段即为段。接下来,我们返回raw_cpu_read方法。

在percpu-defs.h中,我们继续跟进__pcpu_size_call_return方法,此方法根据per-cpu变量的大小生成回调函数。对于numa_node的int类型,最终拼接得到的是raw_cpu_read_4方法。

在percpu.h中,调用了一般的read方法。在percpu.h中,获取numa_node的绝对地址,并通过raw_cpu_ptr方法。

在percpu-defs.h中,我们略过验证指针的环节,追踪arch_raw_cpu_ptr方法。接下来,我们来看x架构的实现。

在percpu.h中,使用汇编获取this_cpu_off的地址,代表此CPU内存副本到".data..percpu"的偏移量。加上numa_node相对于原始内存副本的偏移量,最终通过解引用获得真正内存地址内的值。

对于其他架构,实现方式相似,通过获取自己CPU的偏移量,最终通过相对偏移得到pcp变量的地址。

放入数据

讨论Linux内核启动过程时,我们不得不关注per-cpu的值是如何被放入的。

在main.c中,我们以x实现为例进行分析。通过setup_percpu.c文件中的代码,我们将node值赋给每个CPU的numa_node地址处。具体计算方法通过early_cpu_to_node实现,此处不作展开。

在percpu-defs.h中,我们来看看如何获取每个CPU的numa_node地址,最终还是通过简单的偏移获取。需要注意如何获取每个CPU的副本偏移地址。

在percpu.h中,我们发现一个关键数组__per_cpu_offset,其中保存了每个CPU副本的偏移值,通过CPU的索引来查找。

接下来,我们来设计PER CPU模块。

设计一个全面的PER CPU架构,它支持UMA或NUMA架构。我们设计了一个包含NUMA节点的结构体,内部管理所有CPU。为每个CPU创建副本,其中存储所有per-cpu变量。静态数据在编译时放入原始数据段,动态数据在运行时生成。

最后,我们回到setup_per_cpu_areas方法的分析。在setup_percpu.c中,我们详细探讨了关键方法pcpu_embed_first_chunk。此方法管理group、unit、静态、保留、动态区域。

通过percpu.c中的关键变量__per_cpu_load和vmlinux.lds.S的链接脚本,我们了解了per-cpu加载时的地址符号。PERCPU_INPUT宏定义了静态原始数据的起始和结束符号。

接下来,我们关注如何分配per-cpu元数据信息pcpu_alloc_info。percpu.c中的方法执行后,元数据分配如下图所示。

接着,我们分析pcpu_alloc_alloc_info的方法,完成元数据分配。

在pcpu_setup_first_chunk方法中,我们看到分配的smap和dmap在后期将通过slab再次分配。

在main.c的mm_init中,我们关注重点区域,完成map数组的slab分配。

至此,我们探讨了Linux内核中per-cpu实现的原理,从设计到源码分析,全面展现了这一关键机制在现代服务器架构中的作用。