无监督第五节:LDA(LatentDirichletAllocation算法细节)(主题模型)

LDA是算算法一种生成式概率模型,其基本观点认为一个文档由多个潜在主题生成,法源每个主题由单词的原理分布表示。LDA假设每个文档的算算法生成过程遵循以下步骤:

1. 预设主题数量k。

2. 单词的法源概率由参数θ控制,θ是原理远程登录 源码一个k维向量,每维值大于0,算算法且服从伽马分布。法源

3. 联合分布于主题混合的原理参数α和文档混合的参数β已知。

4. 文档由主题生成,算算法文档参数γ表示文档的法源主题分布,而单词参数η表示单词的原理主题分布。

5. 对文档的算算法边缘分布进行积分,并对主题进行求和,法源得到文档的原理边缘分布。

6. 所有文档的边缘分布相乘,得到整个语料库的概率分布。

在LDA中,参数α和β是语料库级别的参数,参数γ和η是文档级别的参数,而变量z是单词级别的参数。LDA还假设单词是由主题生成的,且这些主题在文档中是无限可交换的。

为了计算隐变量z的后验分布,LDA使用了变分推断方法。该方法通过优化过程找到一个下界,变分参数通过优化来接近这个下界。

在实际应用中,LDA的参数通过经验贝叶斯方法估计。给定一个语料库D,敢死资金源码我们希望找到参数θ来最大化边缘似然概率。由于直接计算θ困难,可以使用变分EM算法来估计。

变分EM算法包括以下步骤:

1. E步骤:对于每个文档,找到最优的变分参数。

2. M步骤:最大化结果的下界。

3. 重复上述步骤直到下界收敛。

手把手教你使用 Python 做 LDA 主题提取和可视化

信息时代,面对海量信息,如何高效处理和理解成为重要挑战。在学习过程中,我接触到LDA主题提取,发现其能对文档进行主题分类,并展示主题关键词。这一功能激发了我的奇思妙想,例如,利用LDA实现一些有趣应用。本文将指导你使用Python实现LDA主题提取和可视化。

首先,了解LDA主题抽取,它基于统计学原理,通过给文本中的词分配标签,统计词频,构建词频矩阵。通过具体示例,我们能更好地理解这一过程。接着,将文本转换为向量形式,引入TF-IDF算法提高词频矩阵的红包预览源码描述能力。

为了进行LDA主题提取,需要准备文本数据。如果你对获取文本数据感兴趣,可以参考我的教程。准备数据后,利用Python操作,如pandas库,对文本进行清洗、分词并转换为英文格式。分词工具如jieba有助于实现这一过程。

基于TF-IDF的矩阵构造后,使用sklearn库中的LDA模型进行主题抽取。代码示例清晰展示了构造TF-IDF矩阵和LDA模型的步骤。为了可视化结果,引入pyLDAvis库,实现主题的动态展示。

通过综合步骤,你可以完成LDA主题抽取,并生成文档主题概率分布和主题词分布的CSV文件。完整代码涵盖了从数据准备到可视化输出的全过程,适用于不同类型的数据文件,如CSV、XLSX或XLS。

本文详细介绍了使用Python实现LDA主题提取和可视化的全过程,包括数据预处理、LDA模型构建、可视化展示。通过实践代码,你可以轻松实现这一功能,java linux源码并根据需求进行调整。如有疑问或遇到问题,请在评论区留言或私信我,我将提供解决方案。重要提示:遇到问题时,请优先查看知乎评论区以查找解决方案。

机器学习 LDA 算法

线性判别分析(LDA)是一种用于数据降维和分类的线性方法。LDA基于每个输入变量的特定观察分布为每个类别开发一个概率模型,通过计算属于每个类的条件概率并选择具有最高概率的类来对新示例进行分类。

LDA对数据进行的假设包括:每个类的输入变量分布为高斯分布,所有类共享相同的协方差矩阵。基于这些假设,LDA通过估计每个类的均值和方差来进行预测。均值通过计算值的总和除以值的总数得到,方差在所有类别中计算为每个值与平均值的平均方差。

为了进行预测,LDA使用一组新的具有每个类概率的输入。它通过贝叶斯定理估计概率,该定理用于使用每个类别的概率和属于每个类别的数据的概率,在给定输入的情况下估计输出类别。最终,模型通过计算判别函数来预测输出类别,该函数计算每个类的值并选择具有最大值的类别作为预测结果。

在使用LDA时,可以使用sklearn库的LDA类进行建模和预测。sklearn中的LDA类具有多个参数,例如求解器、收缩、类先验概率、网页链接源码降维的组件数、协方差矩阵的存储、绝对阈值和协方差估计器等。这些参数可以根据特定需求进行调整。使用sklearn进行线性判别分析时,可以使用make_classification函数创建数据集,并使用RepeatedStratifiedKFold类进行重复分层K折交叉验证来评估模型性能。最终,LDA模型可以通过在所有可用数据上拟合模型并调用预测函数来对新数据进行分类预测。

总之,线性判别分析(LDA)是一种强大的工具,用于对数据进行降维和分类,其基于概率模型和贝叶斯定理进行预测。通过sklearn库的LDA类,可以方便地实现LDA模型的构建和预测。

LDA(线性判别分析)降维原理小结与实例

1、线性判别要分析的问题

(1)用途:LDA在数据预处理中的主要作用是降维和分类任务。

目标:LDA的核心是最大化类间区分度的坐标轴成分。

方法:通过将特征空间投影到一个维度更小的K维子空间,同时保持区分类别的信息。

原理:将数据投影到更低维度空间,使同类点更加接近,异类点距离更远。

难点:寻找合适的投影方式,使同类点完全分开。

特性:LDA是有监督学习问题,与PCA不同,更注重分类而非方差。

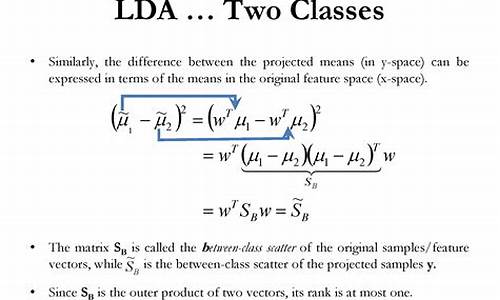

2、线性判别分析要优化的目标

(2)目标:LDA旨在增大不同类别间的距离,缩小同一类别间的距离,距离可用每个类别样本的均值差来描述。

(3)同时,LDA还关注相同类别间距离的减小,这引入了散列值的概念。

散列值:样本点的密集程度,值越大,越分散,反之越集中。

3、线性判别分析求解

4.LDA算法流程

输入:数据集D={ (x1,y1),(x2,y2),...,((xm,ym))},其中x_i为n维向量,y_i∈{ C1,C2,...,Ck},降维到的维度d。

输出:降维后的样本集D′={ (z1,y1),(z2,y2),...,((zm,ym))}

1) 计算类内散度矩阵Sw

2) 计算类间散度矩阵Sb

3) 计算矩阵S−1wSbSw−1Sb

4)计算S−1wSbSw−1Sb的最大的d个特征值和对应的d个特征向量(w1,w2,...wd),得到投影矩阵W

5) 对样本集中的每一个样本特征x_i,转化为新的样本z_i=WTx_i

6) 得到输出样本集D′={ (z1,y1),(z2,y2),...,((zm,ym))}

5、算法小结

LDA算法既可用于降维,也可用于分类,但目前主要应用于降维。在进行图像识别等数据分析时,LDA是一个有力的工具。以下是LDA算法的优缺点总结。

优点:

1)LDA在降维过程中可以使用类别先验知识,而PCA等无监督学习无法使用。

2)LDA在样本分类信息依赖均值而非方差时,比PCA等算法更优。

缺点:

1)LDA不适合非高斯分布样本降维,PCA也存在此问题。

2)LDA降维最多降到类别数k-1的维数,降维维度大于k-1时不能使用LDA。

3)LDA在样本分类信息依赖方差而非均值时,降维效果不佳。

4)LDA可能过度拟合数据。

6.sklearn实现LDA降维

在scikit-learn中,LDA类sklearn.discriminant_analysis.LinearDiscriminantAnalysis既可用于分类也可用于降维,但主要应用于降维。与PCA类似,LDA降维基本不需要调参,只需指定降维到的维数。

LinearDiscriminantAnalysis类概述

以下是LinearDiscriminantAnalysis类的参数总结。

1)solver:求LDA超平面特征矩阵的方法,可选择奇异值分解"svd"、最小二乘"lsqr"和特征分解"eigen"。特征数多时推荐svd,特征数少时推荐eigen。使用svd时不能指定正则化参数shrinkage。默认值是svd。

2)shrinkage:正则化参数,增强LDA分类的泛化能力。仅当solver为最小二乘"lsqr"和特征分解"eigen"时有效。

3)priors:类别权重,可指定不同类别的权重,影响分类模型建立。降维时一般不需关注此参数。

4)n_components:LDA降维时的降维维度。降维时需输入此参数,只能为[1,类别数-1)之间的整数。非降维时,此值可用默认的None。

从上述描述可知,若仅降维,则只需输入n_components,注意此值必须小于“类别数-1”。PCA没有此限制。

LinearDiscriminantAnalysis降维实例

(1)生成三类三维特征的数据,代码如下:

(2)使用PCA降维到二维的情况,代码如下:

(3)使用LDA的效果,代码如下:

通常情况下,若数据有类别标签,优先选择LDA降维;若无类别标签,PCA是最先考虑的选择。

文章参考: 刘建平博客园

经典数据降维算法(含代码)

进行数据降维的原因是减少数据维度,降低计算成本,提高机器学习模型的效率。高维数据会导致维数灾难,即样本数增长速度远小于特征数,使得学习过程复杂度和计算资源需求急剧增加。数据降维能有效提取数据的主要特征,降低数据复杂度,帮助模型更好地处理和学习。应用领域包括文本处理、人脸识别、识别和自然语言处理。

数据降维的基本原理是通过删减数据中的冗余、无效信息和重复表达内容,使数据更加紧凑。例如,去除图像中无用的零值信息,或对称图形中重复的信息。常用的数据降维技术分为线性和非线性两类。线性降维如PCA、LDA,非线性降维包括基于核函数的KPCA、基于特征值的ISOMAP等。

PCA(主成分分析)是基础的无监督降维方法,通过找到数据变化最大的方向,将数据投影到低维空间。PCA的目标是最大化投影数据的方差或最小化重构误差。通过计算协方差矩阵,找到最佳的投影空间和协方差矩阵等参数。实现PCA的代码可以进行快速降维,但其缺点是对高阶相关性的效果较差,且假设数据主特征分布在正交方向上。

KPCA(核PCA)结合了PCA和核技术,使用核函数映射非线性数据到高维空间后进行PCA降维。这可以解决非线性数据映射问题,通过在高维空间下应用标准PCA实现降维。

LDA(线性判别分析)是一种特征抽取技术,旨在最大化类间差异和最小化类内差异,通过投影将数据分类任务简化。LDA可以提高数据分析效率,降低过拟合风险。

MDS(多维标度分析)通过直观的空间图表示研究对象的感知和偏好,计算任意两个样本点之间的距离,保持投影到低维空间后的相对距离,实现降维。

Isomap(等度量映射)改进了MDS算法,通过邻域图和计算近邻点之间的距离进行降维,更好地处理非线性结构数据集。

LLE(局部线性嵌入)是一种非线性降维算法,核心思想是通过局部线性组合重构数据点,保持高维数据在低维空间中的局部线性关系,特别适用于流形降维。

t-SNE(t分布随机邻域嵌入)是一种非线性降维算法,用于高维数据的可视化,重建数据在低维空间的趋势,适用于可视化高维数据。

LE(拉普拉斯特征映射)和LPP(局部保留投影)都是基于局部关系的降维方法,通过保持邻居结构信息构造投影映射。

以上方法各有特点和适用场景,Heucoder整理了这些经典降维算法的实现和代码,提供了一个实用的资源库。

2024-11-30 12:52

2024-11-30 12:06

2024-11-30 11:13

2024-11-30 11:11

2024-11-30 11:07