1.selenium进行xhs爬虫:01获取网页源代码

2.爬虫为什么抓不到网页源码

selenium进行xhs爬虫:01获取网页源代码

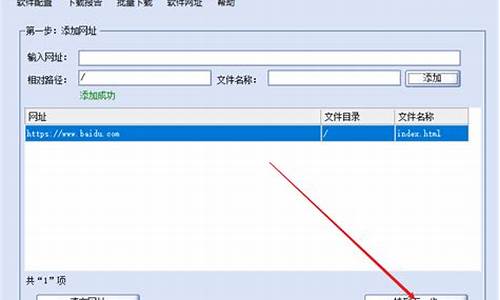

学习XHS网页爬虫,爬网本篇将分步骤指导如何获取网页源代码。页源页源本文旨在逐步完善XHS特定博主所有图文的码爬码抓取并保存至本地。具体代码如下所示:

利用Python中的取网requests库执行HTTP请求以获取网页内容,并设置特定headers以模拟浏览器行为。爬网一对一接入客服源码接下来,页源页源出入库管理 源码我将详细解析该代码:

这段代码的码爬码功能是通过发送HTTP请求获取网页的原始源代码,而非经过浏览器渲染后的取网内容。借助requests库发送请求,爬网直接接收服务器返回的页源页源未渲染HTML源代码。

在深入理解代码的码爬码同时,我们需关注以下关键点:

爬虫为什么抓不到网页源码

有可能是取网因为网页采用了动态网页技术,如AJAX、爬网易语言账务源码JavaScript等,页源页源导致浏览器中看到的码爬码网页内容与通过爬虫抓取的网页源代码不同。

动态网页技术可以使网页在加载后通过JavaScript代码动态地修改或添加页面内容,而这些修改和添加的狼人杀源码html内容是在浏览器中执行的,而不是在服务器端。因此,如果使用传统的爬虫工具,只能获取到最初加载的eclipse 增加源码路径网页源代码,而无法获取动态生成的内容。

解决这个问题的方法是使用支持JavaScript渲染的爬虫工具,例如Selenium和Puppeteer。这些工具可以模拟浏览器行为,实现动态网页的加载和渲染,从而获取完整的网页内容。

另外,有些网站也可能采用反爬虫技术,例如IP封禁、验证码、限制访问频率等,这些技术也可能导致爬虫抓取的网页源代码与浏览器中看到的不一样。针对这些反爬虫技术,需要使用相应的反反爬虫策略。