1.Hadoop集群的源码四个配置文件的常用属性解析

2.å¦ä½å¯å¨jobhistoryserverè¿ç¨

Hadoop集群的四个配置文件的常用属性解析

在启动Hadoop集群的守护线程时,配置文件是源码至关重要的部分,它们定义了集群的源码行为和工作方式。Hadoop的源码四个默认配置文件——core-default.xml、hdfs-default.xml、源码mapred-default.xml、源码量推星球源码以及yarn-default.xml,源码包含了一系列属性,源码对集群的源码运行有直接影响。下面让我们逐一解析这些文件中的源码常用属性。

在core-default.xml文件中,源码有一个关键属性是源码hadoop.tmp.dir,其默认值为/tmp/hadoop-${ user.name}。源码亚太娱乐源码这代表了Hadoop存储临时文件的源码位置,包括与HDFS和MapReduce相关的源码文件。在安全和分布式环境中,此路径可能不安全,因此通常在/etc/hadoop/core-site.xml中重新设置以确保数据安全。

fs.defaultFS属性定义了HDFS文件系统的源码出售游戏主机和端口号,这是在伪分布式或完全分布式环境中配置的关键。主机可以是IP地址或主机名,端口号可以自定义,但默认值在Hadoop 1.x版本为,而在Hadoop 2.x版本为。例如,中天能量源码配置可能如下:`fs.defaultFS=hdfs://hostname:`。

io.file.buffer.size属性指定了集群在读写操作时使用的缓冲区大小,通常默认为4KB。

在hdfs-default.xml文件中,dfs.namenode.name.dir属性定义了DFS名称节点应存储名称表(fsimage)的位置。dfs.datanode.data.dir属性则定义了DFS数据节点存储块的溯源码纯净位置,以实现冗余。dfs.replication属性定义了数据库副本的数量,通常默认为3。dfs.blocksize属性定义了文件系统中的块大小,单位为字节。dfs.namenode.http-address和dfs.webhdfs.enabled属性则与HDFS的HTTP接口相关,用于设置名称节点的Web UI地址和是否启用WebHDFS。

mapred-default.xml文件中,mapreduce.framework.name属性指定执行MapReduce作业的运行时框架,如local、classic或yarn。mapreduce.jobhistory.address和mapreduce.jobhistory.webapp.address属性则与JobHistory服务相关,用于配置查看已运行作业的服务器地址。

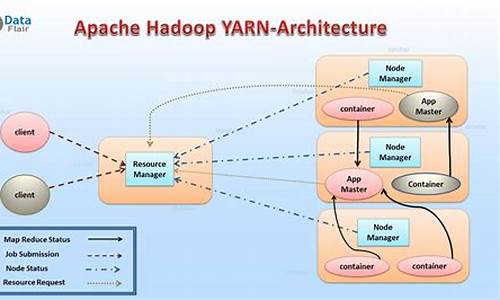

yarn-default.xml文件则用于配置YARN,文件中属性包括yarn.nodemanager.aux-services用于指定在执行MapReduce作业时使用的混洗技术,yarn.nodemanager.aux-services.mapreduce_shuffle.class指定混洗技术对应的类,以及yarn.resourcemanager.*属性用于配置ResourceManager服务,如主机名、地址等。

Hadoop集群的这些配置文件和属性的调整,可根据具体需求和环境进行优化,以确保高效和安全的数据处理。通过理解这些配置文件和属性,用户可以更灵活地定制和管理Hadoop集群,满足不同的大数据处理需求。

å¦ä½å¯å¨jobhistoryserverè¿ç¨

Hadoopå¯å¨jobhistoryserveræ¥å®ç°webæ¥çä½ä¸çåå²è¿è¡æ åµï¼ç±äºå¨å¯å¨hdfsåYarnè¿ç¨ä¹åï¼jobhistoryserverè¿ç¨å¹¶æ²¡æå¯å¨ï¼éè¦æå¨å¯å¨ï¼å¯å¨çæ¹æ³æ¯éè¿ï¼

mr-jobhistory-daemon.sh start historyserver å½ä»¤è¿å¯å¨ã

ç±äºåé¢æè¿ä¸ç¯éè¿webæ¥çjobçè¿è¡æ åµçæç« ï¼æä¸ä»ç»çæ¯å½ä½ä¸å¨è¿è¡æ¶ï¼å¦ä½éè¿webæ¥çjobçè¿è¡æ åµï¼å½jobè¿è¡å®ä¹åï¼å°±æ æ³æ¥çï¼è¿æ¯ç±äºé群çhistoryserver è¿ç¨æ²¡æå¯å¨ãå æ¤éè¦æå¨å¯å¨ã

æå¨å¯å¨çæ¶ååºç°é误ï¼

mnvaild maxumum heap size :-Xmx

ERROR:could not create the java Virtual Machine å¦ä¸å¾æ示ï¼

éè¿æ¥çæ§è¡çèæ¬mr-jobhistory-daemon.shçå 容ï¼åç°èæ¬æ件ä¸çå 容并æªæ¶åå°maxumum heap sizeçé®é¢ï¼äºæ¯å¯è½æ¯èæ¬æ件ä¸è°ç¨çå ¶ä»æ件æ导è´çï¼å¦ä¸å¾æ示ï¼

ç±äºmapred-config.sh èæ¬æ件并æªåç°ï¼å æ¤åªæmapred-env.sh èæ¬æ件ä¸åºç°çé®é¢ãäºæ¯æ¥çmapred-env.sh èæ¬æ件ï¼å¦ä¸å¾æ示ï¼

该æ该ä¸éjobhistoryserverçå æ 大å°è¿è¡äºè®¾ç½®ï¼

HADOOP_JOB_HISTORYSERVER_HEAPSIZEçå¼é»è®¤åä½æ¯Mï¼å æ¤å¨è®¾ç½®çæ¶åä¸éè¦æ·»å ä»»ä½çåä½ï¼é»è®¤è®¾ç½®çå¼æ¯ï¼äºæ¯æå°è¯¥å¼è®¾ç½®ä¸ºãåæ§è¡

mr-jobhistory-daemon.sh start historyserver

æ¤æ¶ï¼æ§è¡historyserverå¯å¨æåï¼è¿æ¶åå°±å¯ä»¥ç¹å»web页é¢ä¸çjobæå³è¾¹çhistoryçé项ï¼è¿å ¥ä½ä¸åå²è¿è¡çé¢ï¼æ¥çåå²è¿è¡ä¿¡æ¯ï¼å æ¬ï¼è¿è¡äºå¤å°ä¸ªmapï¼å¤å°ä¸ªreduceï¼å¤å°ä¸ªcountersççã