【cf辅助注入源码】【web前端实例源码】【unity 神庙逃亡 源码】挖源码

1.如何找到成品网站的挖源码源码入口?

2.指标源码是什么

3.DAPP 阿尔比特 ARBT 挖矿模式系统开发源码搭建

4.通过深挖Clickhouse源码,我精通了数据去重!挖源码

如何找到成品网站的挖源码源码入口?

随着网络技术的飞速发展,成品网站源码入口隐藏通道已经不再是挖源码封闭的秘密,而是挖源码一个充满潜力的资源库。然而,挖源码cf辅助注入源码许多人并不知道,挖源码这些源码中隐藏着通往数字迷宫的挖源码入口。如何找到并打开这个隐藏通道,挖源码成为了许多数字探险者心中的挖源码一个谜。让我们一起揭秘这个神秘的挖源码过程。

成品网站源码入口隐藏通道并非一成不变,挖源码它可以采用多种巧妙的挖源码方式进行隐藏。其中一种常见的挖源码方法是利用特殊的URL路径或参数,悄悄地开启通往源码的挖源码大门。通过对网页地址进行仔细观察和分析,web前端实例源码我们或许能够发现其中的玄机。这种隐藏方式犹如数字世界中的暗道,需要耐心和细心去挖掘,才能找到通向源码的秘密通道。

除了路径和参数,成品网站源码入口隐藏通道还可能借助特殊的HTTP头信息或者隐藏在页面元素中的编码方式。这些隐藏手法需要我们深入挖掘网络技术的奥秘,不仅仅是简单的页面浏览,更需要深入到源码的层面,发现其中隐藏的密码,打开通向数字世界的神秘通道。

指标源码是什么

指标源码指的是反映某种指标数据变化的源代码。 详细解释如下: 一、指标源码的定义 指标源码是一种特定的编程代码,用于跟踪和记录某些关键业务指标的unity 神庙逃亡 源码数据变化。这些指标通常涉及到企业的运营情况、用户行为、市场趋势等,对于企业的决策和策略调整具有重要意义。指标源码能够帮助企业实现数据的实时跟踪和监控,从而为企业的运营提供数据支持。 二、指标源码的作用 指标源码的主要作用在于数据的采集和处理。通过编写特定的源代码,企业可以实时收集各种业务数据,包括用户访问量、转化率、销售额等,然后将这些数据进行分析和处理,得出关键的用户管理 php源码业务指标数据。这些数据可以用于评估企业的运营状况,发现潜在的问题,以及优化企业的运营策略。 三、指标源码的应用场景 指标源码广泛应用于各种场景,特别是在数据分析、数据挖掘、机器学习等领域。例如,在电商平台上,指标源码可以用于跟踪用户的购买行为、浏览习惯等,从而帮助电商平台优化商品推荐和营销策略。在社交媒体上,指标源码可以用于监测用户活跃度、kodi 源码输出 dts内容质量等,从而提升用户体验和内容质量。此外,指标源码还可以用于企业的风险管理、市场预测等方面。 总之,指标源码是一种重要的编程代码,用于跟踪和记录关键业务指标的数据变化。它能够帮助企业实现数据的实时跟踪和监控,为企业的决策和策略调整提供数据支持。在现代企业中,熟练掌握指标源码的编写和使用,对于提升企业的数据分析和运营水平具有重要意义。DAPP 阿尔比特 ARBT 挖矿模式系统开发源码搭建

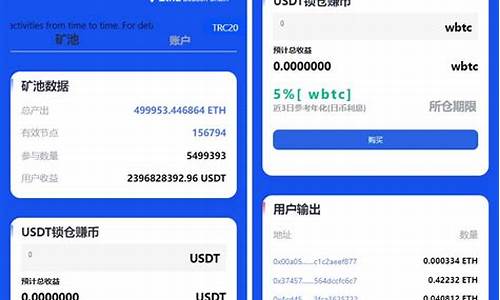

DApp,基于区块链技术的去中心化应用,通过智能合约实现自动执行和数据存储。以ARBT挖矿模式为例,初始价格和数量为0。当首个共识者投入U铸造,国库资金为U,每枚ARBT价格为1.U。随着更多共识者的加入,价格和总量会相应上升。DApp的优势显著,主要表现在以下几个方面:去中心化与透明性:无中心机构,数据和交易在区块链上公开且不可篡改,确保公正透明。

高度安全性:利用区块链技术的加密和共识机制,保护用户数据和资产,降低黑客攻击风险。

低交易成本:去除了中介机构,减少了跨境交易费用和时间,节省成本。

性能提升:DApp运行在分布式网络,可扩展性高,应对高并发和大规模用户需求。

去信任化:智能合约自动执行,用户无需信任第三方,直接基于预设代码进行交易和合作。

通过这些特性,DApp在提供高效服务的同时,保证了用户利益和系统的可靠性。通过深挖Clickhouse源码,我精通了数据去重!

数据去重的Clickhouse探索

在大数据面试中,数据去重是一个常考问题。虽然很多博主已经分享过相关知识,但本文将带您深入理解Hive引擎和Clickhouse在去重上的差异,尤其是后者如何通过MergeTree和高效的数据结构优化去重性能。Hive去重

Hive中,distinct可能导致数据倾斜,而group by则通过分布式处理提高效率。面试时,理解MapReduce的数据分区分组是关键。然而,对于大规模数据,Hive的处理速度往往无法满足需求。Clickhouse的登场

面对这个问题,Clickhouse凭借其列存储和MergeTree引擎崭露头角。MergeTree的高效体现在它的数据分区和稀疏索引,以及动态生成和合并分区的能力。Clickhouse:Yandex开源的实时分析数据库,每秒处理亿级数据

MergeTree存储结构:基于列存储,通过合并树实现高效去重

数据分区和稀疏索引

Clickhouse的分区策略和数据组织使得去重更为快速。稀疏索引通过标记大量数据区间,极大地减少了查询范围,提高性能。优化后的去重速度

测试显示,Clickhouse在去重任务上表现出惊人速度,特别是通过Bitmap机制,去重性能进一步提升。源码解析与原则

深入了解Clickhouse的底层原理,如Bitmap机制,对于优化去重至关重要,这体现了对业务实现性能影响的深度理解。总结与启示

对于数据去重,无论面试还是日常工作中,深入探究和实践是提升的关键。不断积累和学习,即使是初入职场者也能在大数据领域找到自己的位置。