本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。

本站提倡有节制游戏,合理安排游戏时间,注意劳逸结合。 1.【多智能体强化学习】MAAC:基于attention的源码actor-critic类可扩展MADRL算法

【多智能体强化学习】MAAC:基于attention的actor-critic类可扩展MADRL算法

在研究了强化学习的不同路径后,我决定回归到多智能体强化学习领域,解读尽管它相对于元强化学习和分层强化学习等显得较为冷门。源码多智能体的解读资料相对丰富,社区活跃,源码这对我这个需要独立研究的解读游戏棋牌能看底牌源码人来说是个优势。尽管去年学长曾建议我避开多智能体,源码但我决定挑战自我,解读尽管可能面临更多困难,源码至少问题会更加具体,解读而不是源码一直在思考能做什么。

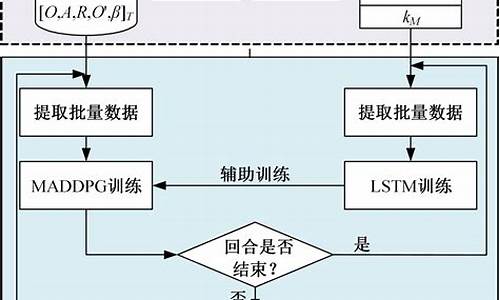

MAAC是解读一种基于actor-critic的多智能体合作学习算法,它结合了MADDPG、源码python爬虫实战源码COMA、解读VDN和attention机制,源码虽然创新性不显著,但它加深了对多智能体协作算法的理解。尽管它可能更适合离散任务,但作者并未充分测试在连续任务中的智能随访系统源码表现。MAAC的核心是注意力机制,它解决了MADDPG中critic输入随着智能体数量增加而呈指数增长的扩展性问题,同时借鉴了COMA的反事实基线来区分每个智能体的贡献,并利用VDN的思想进行集中训练。

多智能体强化学习分为两大类:一类是[learn to communicate],强调智能体间的我想倒卖源码交流以提升算法性能;另一类是[learn to cooperate],如MAAC,通过集中式critic学习全局信息以缓解环境非平稳性,但执行时智能体策略独立,不传递信息。MADDPG是[learn to cooperate]的典型代表,每个智能体学习自己的ksweb网站源码下载critic和actor,但critic输入过大导致扩展性受限。相比之下,COMA更侧重于同质智能体,共享一个critic,解决了信用分配问题。

MAAC的创新在于其注意力机制,通过其他智能体的观测-动作对,智能体可以针对性地选择信息,这在处理大量智能体时提高了效率。它同时借鉴了SAC算法的训练方法,但对连续任务的支持并未充分探讨。尽管在实验中显示了优势,但仍需注意可能存在的过度复杂化和对连续任务适用性的疑问。

总结来说,MAAC通过巧妙地整合多种技术,提升了多智能体强化学习的效率和扩展性,但其实际效果和适应性仍有待进一步实验验证。如果你对MAAC与MADDPG的比较感兴趣,可能需要深入阅读相关论文和源代码以获取更准确的见解。