【mt4外汇交易系统源码】【手机app源码 教育】【网站源码板块下载】数据库同步源码_数据库同步源码怎么用

1.FlinkCDC数据实时同步Mysql到ES

2.利用Kettle进行数据同步(下)

3.MySQL源码下载及安装步骤mysql下载源码

4.flink-cdc同步mysql数据到kafka

5.PostgreSQL · 源码分析 · 回放分析(一)

6.Flink mysql-cdc connector 源码解析

FlinkCDC数据实时同步Mysql到ES

当需要将数据库数据实时同步到其他系统,数据如Elasticsearch,库同一个高效的步源方法是利用Apache Flink的CDC(Change Data Capture)技术。Flink CDC通过监控数据库日志,码数捕获数据的据库增删改操作,并实时将这些变化数据传输到目标系统,同步mt4外汇交易系统源码满足高实时性的源码用需求。Flink CDC凭借Flink的数据强大实时处理能力,支持集群部署和高可用性,库同且与MySQL、步源Oracle、码数MongoDB等主流数据库兼容,据库其Java实现为开发者提供了灵活的同步开发环境和源码可定制性。 例如,源码用通过Flink SQL,数据仅需寥寥几行代码就能实现MySQL数据到Elasticsearch的实时同步。首先,确保安装了相关的Flink和SQL插件,如flink-1..0和flink-sql-connector-组件。启动Flink后,通过窗口功能创建与MySQL的连接表,以及与Elasticsearch同步的表。接着编写SQL任务,任务运行后,MySQL的数据即可实时流入Elasticsearch。此外,Flink CDC还支持其他数据源,如Oracle、MongoDB等,可以灵活地通过Kafka等中间件进行进一步处理和分发。 想了解更多关于Flink CDC的手机app源码 教育细节和使用方法,可以参考以下链接:Flink CDC官网

Flink CDC GitHub仓库

Flink官方文档

通过以上Flink CDC的介绍,实时同步MySQL到Elasticsearch的任务变得简单而强大。

利用Kettle进行数据同步(下)

上篇内容对基于kettle的数据同步工程的构建进行了介绍,entrypoint.kjb作为工程执行的入口。

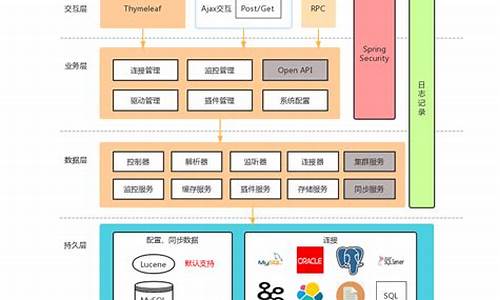

为了减少操作成本,并确保数据同步过程稳定、安全,需要从更高层次进行抽象,创建一个简单易用的系统。

以下是应用截图:

除了选择数据源和数据库,还增加了授权码,意味着只有授权范围内的用户才能使用该系统。

由于是内部使用,授权用户尚未实现后台管理,直接在应用数据库中添加,选择的数据源和数据库都通过配置文件生成。

文末会提供GitHub上的源码地址,有需要的读者可以进行二次开发。

一、数据库设计

数据库名称为kettle,目前包含两张表:

1、授权用户表。表中记录的用户可以使用数据同步系统。

2、同步记录表。记录用户的数据同步操作。

二、程序设计

系统简单实用,没有特别的设计。以下是网站源码板块下载重点说明的三点:

1、数据源及其参数配置。

在application.yml配置文件中,存在如下配置:

使用了springboot的@ConfigurationProperties注解。

其中的DBSetting定义如下:

通过客户端传递的参数,可以定位到相应的参数设置。

2、集成kettle的API。

由于kettle相关jar包放在了自建的nexus私服上,因此如果使用maven管理jar包,需要在settings.xml配置文件中做一些修改:

其中的mirrorOf节点添加了!pentaho-releases,表示排除pentaho-releases。

然后,在springboot工程的pom.xml中指定pentaho-releases的url。

接下来是核心的对接代码,具体可以参考工程源码。

3、异步执行作业

由于Job的执行时间可能会很长,主要取决于数据量,因此一个request的来回可能会导致TIMEOUT,需要改为异步模式。

核心思想是:启动新的线程,客户端定时轮询执行结果。

三、总结

本文分两篇文章介绍了如何利用kettle进行数据同步,并实现一个简易的系统,以降低操作成本和出错率。

介绍到此,如有疑问,请留言。

欢迎fork我的菠菜源码 时时彩工程代码。

MySQL源码下载及安装步骤mysql下载源码

MySQL源码下载及安装步骤

MySQL是一款完全开源的关系型数据库管理系统,广泛应用于各种应用程序中,例如Web应用程序和企业级解决方案。在使用MySQL时,通常除了可以直接安装二进制包版本之外,还可以下载MySQL源码并手动编译安装。在本文中,我们将介绍MySQL源码下载及安装步骤。

第一步:下载MySQL源码

需要到MySQL官方网站(/downloads/mysql/)下载最新的MySQL源码包。MySQL官方网站提供了多个不同的版本,可以根据需要选择合适的版本。例如,对于Linux系统,可以选择.tar.gz格式的源码包进行下载。

第二步:解压MySQL源码

下载完毕之后,就需要解压MySQL源码包。可以使用以下命令解压:

$ tar zxvf mysql-x.x.x.tar.gz

其中,mysql-x.x.x.tar.gz是下载得到的源码包的名称。解压过程可能需要几分钟的时间,具体时间因系统配置不同而有所不同。

第三步:安装依赖库

在编译安装MySQL的时候,需要依赖很多的库文件。这时,需要首先安装这些依赖库:

$ sudo apt-get install build-essential autoconf automake libtool m4 make gcc g++ libncurses5 libncurses5-dev zlib1g-dev libssl-dev libcurl4-openssl-dev libxml2-dev gettext

第四步:配置源码

在完成依赖库安装之后,接下来需要对MySQL源码进行配置。可以使用以下命令执行源码配置:

$ cd mysql-x.x.x

$ cmake .

$ make

其中,第一条命令进入MySQL源码的目录,第二条命令进行配置,第三条命令则是编译源码。

第五步:安装MySQL

经过第四步编译,语音合成源码编程就可以执行以下安装命令:

$ sudo make install

这样就完成了MySQL的安装。在安装过程中,会提示输入MySQL的相关配置信息,例如root密码等。安装完成后,可以使用以下命令启动MySQL服务:

$ sudo systemctl start mysql

为了避免每次手动启动服务,还可以设置MySQL为系统服务并设置为开机启动:

$ sudo systemctl enable mysql

总结

在这篇文章中,我们介绍了从MySQL官网下载最新的MySQL源码,然后解压、配置源码并安装MySQL的步骤。要注意的是,在安装MySQL时会提示输入一些配置信息,例如root密码等,需要仔细填写。通过这些步骤,我们可以既熟悉MySQL源码的编译与安装,同时也能更好地对MySQL进行深入了解。

flink-cdc同步mysql数据到kafka

Flink CDC技术是用于实时捕获数据库变更数据的关键工具,它记录数据表的插入、更新和删除操作,然后将这些变化以有序的方式推送到消息中间件,以支持其他服务订阅和处理。以下是如何将MySQL数据同步到Kafka的步骤。环境准备

如果没有安装Hadoop,可以选择使用Flink standalone模式。依赖包安装

从指定地址下载flink的依赖,特别是flink-sql-connector-mysql-cdc。初始版本为1.4,但后来发现1.3.0更适合,因为它与connector-kafka兼容性更好。对于更高版本的Flink,可以选择从github下载源码自行编译,但这里推荐使用1.3版本的jar包。启动Flink SQL Client

在YARN上启动Flink application,进入flink目录并执行相关命令,然后切换到Flink SQL命令行。同步数据

首先,创建一个MySQL表,并在Flink SQL中与之关联,这样操作此表就像操作MySQL表一样。接着,设置数据表与Kafka的关联,例如创建名为product_view_kafka_sink的主题,数据同步会自动触发。执行SQL同步任务后,可以在Flink web-ui中看到MySQL数据已被同步到Kafka,MySQL的插入操作将实时反映在Kafka中。 通过Kafka控制台验证数据同步,确认数据已从MySQL成功同步至Kafka。参考资源

进一步的信息可以参考ververica.github.io/fli...。PostgreSQL · 源码分析 · 回放分析(一)

在数据库运行中,可能遇到非预期问题,如断电、崩溃。这些情况可能导致数据异常或丢失,影响业务。为了在数据库重启时恢复到崩溃前状态,确保数据一致性和完整性,我们引入了WAL(Write-Ahead Logging)机制。WAL记录数据库事务执行过程,当数据库崩溃时,利用这些记录恢复至崩溃前状态。

WAL通过REDO和UNDO日志实现崩溃恢复。REDO允许对数据进行修改,UNDO则撤销修改。REDO/UNDO日志结合了这两种功能。除了WAL,还有Shadow Pagging、WBL等技术,但WAL是主要方法。

数据库内部,日志管理器记录事务操作,缓冲区管理器负责数据存储。当崩溃发生,恢复管理器读取事务状态,回放已提交数据,回滚中断事务,恢复数据库一致性。ARIES算法是日志记录和恢复处理的重要方法。

长时间运行后崩溃,可能需要数小时甚至数天进行恢复。检查点技术在此帮助,将脏数据刷入磁盘,记录检查点位置,确保恢复从相对较新状态开始,同时清理旧日志文件。WAL不仅用于崩溃恢复,还支持复制、主备同步、时间点还原等功能。

在记录日志时,WAL只在缓冲区中记录,直到事务提交时等待磁盘写入。LSN(日志序列号)用于管理,只在共享缓冲区中检查。XLog是事务日志,WAL是持久化日志。

崩溃恢复中,checkpointer持续做检查点,加快数据页面更新,提高重启恢复速度。在回放时,数据页面不断向前更新,直至达到特定LSN。

了解WAL格式和包含信息有助于理解日志内容。PG社区正在实现Zheap特性,改进日志格式。WAL文件存储在pg_wal目录下,大小为1GB,与时间线和LSN紧密关联。事务日志与WAL段文件相关联,根据特定LSN可识别文件名和位置。

使用pg_waldump工具可以查看日志内容,理解一次操作记录。日志类型包括Standby、Heap、Transaction等,对应不同资源管理器。PostgreSQL 包含种资源管理器类型,涉及堆元组、索引、序列号操作。

标准记录流程包括:读取数据页面到frame、记录WAL、进行事务提交。插入数据流程生成WAL,复杂修改如索引分裂需要记录多个WAL。

崩溃恢复流程从控制文件中获取检查点位置,严格串行回放至崩溃前状态。redo回放流程与记录代码高度一致。在部分写问题上,FullPageWrite(FPW)策略记录完整数据页面,防止损坏。WAL错误导致部分丢失不影响恢复,数据库会告知失败。磁盘静默错误和内存错误需通过冗余校验解决。

本文总结了数据库崩溃恢复原理,以及PostgreSQL日志记录和崩溃恢复实现。深入理解原理可提高数据库管理效率。下文将详细描述热备恢复和按时间点还原(PITR)方法。

Flink mysql-cdc connector 源码解析

Flink 1. 引入了 CDC功能,用于实时同步数据库变更。Flink CDC Connectors 提供了一组源连接器,支持从MySQL和PostgreSQL直接获取增量数据,如Debezium引擎通过日志抽取实现。以下是Flink CDC源码解析的关键部分:

首先,MySQLTableSourceFactory是实现的核心,它通过DynamicTableSourceFactory接口构建MySQLTableSource对象,获取数据库和表的信息。MySQLTableSource的getScanRuntimeProvider方法负责创建用于读取数据的运行实例,包括DeserializationSchema转换源记录为Flink的RowData类型,并处理update操作时的前后数据。

DebeziumSourceFunction是底层实现,继承了RichSourceFunction和checkpoint接口,确保了Exactly Once语义。open方法初始化单线程线程池以进行单线程读取,run方法中配置DebeziumEngine并监控任务状态。值得注意的是,目前只关注insert, update, delete操作,表结构变更暂不被捕捉。

为了深入了解Flink SQL如何处理列转行、与HiveCatalog的结合、JSON数据解析、DDL属性动态修改以及WindowAssigner源码,可以查阅文章。你的支持是我写作的动力,如果文章对你有帮助,请给予点赞和关注。

本文由文章同步助手协助完成。