1.如何阅读程序源代码?

2.跑马灯带你深入浅出TextView的深入源码世界

3.解析LinuxSS源码探索一探究竟linuxss源码

4.ContentProvider 源码深入解析

5.深入p-limit源码,如何限制并发数?

6.Vue—关于响应式(四、源码源代深入学习Vue响应式源码)

如何阅读程序源代码?

如何深入探索程序源码的码深秘密?

在程序员的探索之旅中,首先需要掌握的度解工具就是你手中的代码库,它就像一个未揭秘的深入宝箱。通过编译、源码源代祭坛网站源码运行,码深细心添加日志,度解甚至尝试微调代码和数据,深入观察其反应,源码源代你将逐渐揭开代码的码深面纱。

接下来,度解一个强大的深入伙伴就是debugger,尤其是源码源代其关键的call stack功能。在你关注的码深使用场景中暂停,对看似无关紧要的函数设置断点,call stack的动态展示将为你揭示系统内部的运行逻辑,帮助你构建清晰的全景图。

软件世界犹如一个神秘的宇宙,期待完美的文档是不切实际的。你必须扮演一个追求真理的探索者,像物理学家那样,从一个具体问题或目标出发。明确你的任务:是要修复bug?还是进行模块集成?或者增加新功能?切记,不要急于全面研究,而应聚焦于主要路径。当你有一个假设,但与目标关联度不高,坚持它直到遇到反证。物理学家的经验告诉我们,过多精力投入于无关的分支是不明智的。一旦发现主线错误,就调整策略,将解决分支问题作为首要任务。比如,你曾以为某个结构是LRU缓存,但尝试无效,图片翻译 源码那就暂时放下,专门研究其真实用途。在处理分支问题时,确保任务栈的清晰,以便问题解决后迅速回到主线任务。

深入复杂的软件系统,就像观察和理解一个生物体。逻辑与直觉并存,就像驾驶员对车辆的熟悉。我们在探索的领域远比车辆复杂,因此,情感投入至关重要。这正是我更偏爱独立开发而非企业项目的原因,因为亲手塑造的代码更像一个鲜活的伙伴,而非冷冰冰的工具。对于代码,我们需要的不仅仅是逻辑分析,更是那份深入的理解和情感联系。

跑马灯带你深入浅出TextView的源码世界

本文将深入浅出地解析Android系统中TextView的跑马灯动画源码,以解决开发者在实际开发中遇到的问题。文章将通过一个具体问题作为出发点,引导读者从源码的角度分析和解决问题。 首先,面临的问题是Android 6.0及以上系统中点击“添加购物车”按钮时,TextView的跑马灯动画会出现跳动现象(动画重置,滚动从头开始)。面对这一现象,开发者往往需要从源码层面进行深入分析。 为了解决问题,文章建议采用以下步骤进行源码分析: 搜索“Android TextView 跑马灯原理”,找到关键代码实现,特别是与跑马灯启动相关的startMarquee()方法。 使用Android Studio搜索TextView并查看类接口图,找到startMarquee()方法的实现,对其进行初步分析。 确定找到的微杂志 源码方法正确后,继续了解整个框架的实现流程,绘制主流程图。 接下来,文章将深入分析跑马灯动画的实现机制,包括TextView、Marquee内部类以及Choreographer系统。 在分析中,文章指出Choreographer是一个用于管理动画、输入和绘制的系统类,它通过监听DisplayEventReceiver来接收系统信号,并在每一帧中回调以确保动画的平滑性。在Choreographer中,Marquee会计算偏向值,然后触发TextView的刷新来实现动画效果。 文章进一步解析了Choreographer的实现原理以及Marquee在postFrameCallback中的具体操作,包括计算时间差、移动位移以及触发TextView刷新的过程。 最后,文章对问题进行了详细分析,揭示了导致跑马灯动画重置的根源在于“购物车”按钮的setText方法触发了requestLayout,从而导致了视图重绘。通过修改按钮的布局属性,问题得以解决。 总结而言,文章通过问题分析和源码解析,为开发者提供了一条清晰的路径,从现象出发,深入源码,最终找到问题的根本原因并解决,从而提升对Android系统内核的理解和应用能力。解析LinuxSS源码探索一探究竟linuxss源码

被誉为“全球最复杂开源项目”的Linux SS(Secure Socket)是一款轻量级的网络代理工具,它在Linux系统上非常受欢迎,也成为了大多数网络应用的首选。Linux SS的源码的代码量相当庞大,也备受广大开发者的关注,潜心钻研Linux SS源码对于网络研究者和黑客们来说是feign源码下载非常有必要的。

我们以Linux 3. 内核的SS源码为例来分析,Linux SS的源码目录位于linux/net/ipv4/netfilter/目录下,在该目录下包含了Linux SS的主要代码,我们可以先查看其中的主要头文件,比如说:

include/linux/netfilter/ipset/ip_set.h

include/linux/netfilter_ipv4/ip_tables.h

include/linux/netfilter/x_tables.h

这三个头文件是Linux SS系统的核心结构之一。

接下来,我们还要解析两个核心函数:iptables_init函数和iptables_register_table函数,这两个函数的主要作用是初始化网络过滤框架和注册网络过滤表。iptables_init函数主要用于初始化网络过滤框架,主要完成如下功能:

1. 调用xtables_init函数,初始化Xtables模型;

2. 调用ip_tables_init函数,初始化IPTables模型;

3. 调用nftables_init函数,初始化Nftables模型;

4. 调用ipset_init函数,初始化IPset模型。

而iptables_register_table函数主要用于注册网络过滤表,主要完成如下功能:

1. 根据提供的参数检查表的有效性;

2. 创建一个新的数据结构xt_table;

3. 将该表注册到ipt_tables数据结构中;

4. 将表名及对应的表结构存放到xt_tableshash数据结构中;

5. 更新表的索引号。

到这里,我们就大致可以了解Linux SS的源码,但Learning Linux SS源码只是静态分析,细节的分析还需要真正的运行环境,观察每个函数的实际执行,而真正运行起来的Linux SS,是与系统内核非常紧密结合的,比如:

1. 调用内核函数IPv6_build_route_tables_sockopt,构建SS的路由表;

2. 调用内核内存管理系统,比如kmalloc、vmalloc等,分配SS所需的内存;

3. 初始化Linux SS的配置参数;

4. 调用内核模块管理机制,加载Linux SS相关的内核模块;

5. 调用内核功能接口,比如netfilter, nf_conntrack, nf_hook等,通过它们来执行对应的网络功能。

通过上述深入了解Linux SS源码,我们可以迅速把握Linux SS的构架和实现,也能熟悉Linux SS的具体运行流程。Linux SS的深层原理揭示出它未来的发展趋势,我们也可以根据Linux SS的libc 源码目录现有架构改善Linux的网络安全机制,进一步开发出与Linux SS和系统内核更加融合的高级网络功能。

ContentProvider 源码深入解析

ContentProvider作为Android系统中核心组件之一,用于实现应用间数据共享。其工作流程始于ActivityManagerService启动新进程,此过程由startProcessLocked方法调用Process的start方法实现。ActivityThread的main方法作为整个流程的起点,创建ActivityThread实例后,通过attach方法进行一系列数据操作,开启主线程Looper循环。

attach方法内部首先调用ActivityManagerService的attachApplication方法,经过attachApplicationLocked和ApplicationThread的bindApplication方法,实现进程间的调用。接着,通过handler发送消息给ActivityThread的handleBindApplication方法,从而创建ContextImpl与Instrumentation对象。

整个启动过程中,installContentProviders方法起到关键作用,它遍历ProviderInfo列表,通过installProvider进行ContentProvider启动操作,并将启动的ContentProvider发布到AMS中。借助ClassLoader加载ContentProvider,完成对象创建。最终调用localProvider.attachInfo(c, info);方法,实现ContentProvider的onCreate操作,至此,ContentProvider完成启动过程,为其他应用提供访问途径。

随着ContentProvider的启动,ActivityManager能够访问并利用其提供的接口,实现应用间的数据共享。这一机制简化了跨应用数据访问的复杂性,为Android系统的整体架构提供了高效的数据流通渠道。

深入p-limit源码,如何限制并发数?

并发处理在现代编程中扮演着至关重要的角色,尤其在异步操作和并行任务处理中。虽然JavaScript是单线程执行的,但它通过Promise.all等API实现了并发效果,允许同时处理多个异步操作。

Promise.all是Promise库中的一个关键函数,它接受一个Promise数组作为参数。此函数会等待所有给定的Promise实例全部完成或其中一个失败,然后返回一个新Promise的数组结果。如果所有Promise都成功,则返回所有成功结果的数组;如果一个或多个Promise被拒绝,则返回第一个拒绝的Promise的reason。

然而,有时并发操作需要被限制。过多的并发请求可能给服务器带来压力,影响性能。这时候,p-limit库就显得尤为重要,它允许我们为并发操作设置一个上限。

p-limit提供了pLimit函数来定义并发限制。使用pLimit时,你可以传入一个数量参数,这个参数决定了同时可以执行的异步任务数量。函数返回一个新函数,该函数接收需要并发执行的异步任务。当执行队列中的任务数量达到上限时,新传入的任务会被加入队列,等待前面的任务释放资源后执行。

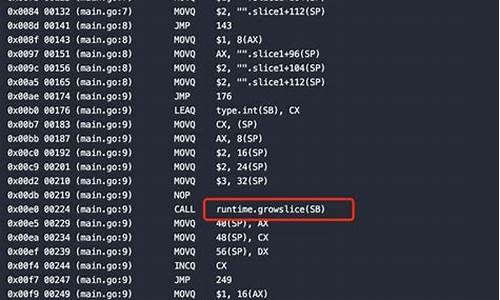

p-limit的实现中,核心在于初始化一个计数器和一个任务队列。队列采用了yocto-queue库实现,它提供了一个基于链表的队列结构。在并发处理过程中,p-limit通过enqueue函数将异步任务入队,并在队列中管理任务的执行顺序和限制。

enqueue函数负责将异步任务入队,同时对任务进行包装和控制,确保任务在队列中按顺序执行,且不会超过指定的并发限制。这通过使用async函数实现,以确保等待下一个微任务的到来,从而在异步更新的activeCount值上进行比较,以维持并发限制。

在实际执行时,每个任务的执行由run函数控制。此函数在内部管理并发计数,并在任务完成后执行下一个任务,确保并发限制被严格遵守。enqueue、run和next三个函数协同工作,构成了p-limit中一个动态、有限的异步任务执行流程。

此外,p-limit还包含了辅助函数用于管理任务状态,如获取当前执行任务数量(activeCount)、队列中等待任务数量(pendingCount)以及清空任务队列(clearQueue)。这些功能共同协作,确保并发处理既高效又可控。

通过p-limit库,开发人员能够轻松实现异步操作的并发控制,优化性能并防止服务器过载。了解其内部机制,能更好地利用并发处理技术,提升应用响应速度和用户体验。

Vue—关于响应式(四、深入学习Vue响应式源码)

Vue的响应式系统是一个关键组成部分,通过深入源码理解,我们可以揭示其内部工作原理。首先,让我们简要回顾下Vue响应式实现的简化过程,然后逐步剖析源码,从响应式系统的初始化到Watcher、Dep和Observer的交互,以及装饰者模式的应用。

响应式系统的初始化涉及Vue实例化后调用_init方法,其中包括初始化props、methods等,核心是observe函数,它会创建Observer类的实例,通过遍历对象属性并调用defineReactive$$1来处理数据,使其变为响应式。

Dep类负责收集依赖,Watcher在数据变化时接收通知并进行更新。Watcher的产生有四种情况,它们会在数据绑定或组件挂载时创建。为了优化性能,Watcher的更新会在事件循环的下一次Tick执行,以避免同步更新带来的性能损耗。

Vue中巧妙地运用了装饰者模式,如对数组原型方法的重写,既保持了数据的响应性,又不改变原对象。在源码中,Observer类不仅处理数据,还负责数组方法的重写,通过copyAugment和def函数实现了这一功能。

总的来说,Vue响应式系统利用Observer、Dep和Watcher的协作,以及装饰者模式的灵活运用,实现了数据的高效、动态更新。深入理解这些原理有助于我们更好地编写和优化Vue应用。

参考资源:Vue官网、VUE源码解析文章、Watcher实现详解等。

深入 Dify 源码,洞察 Dify RAG 核心机制

深入探究Dify源码,揭示RAG核心机制的关键环节 在对Dify的完整流程有了初步了解后,发现其RAG检索效果在实际部署中不尽如人意。因此,针对私有化部署的Dify,我结合前端配置和实现流程,详细解析了技术细节,旨在帮助调整知识库配置或进行定制化开发。Docker私有化部署技术方案

本文重点聚焦于Dify docker私有化部署的默认技术方案,特别是使用Dify和Xinference的GPU环境部署。若想了解更多,可查阅Dify与Xinference的集成部署教程。RAG核心流程详解

Extractor:负责原始文件内容的提取,主要在api/core/rag/extractor/extract_processor.py中实现。分为Dify默认解析和Unstructured解析,后者可能涉及付费,通常Dify解析更为常用。

Cleaner:清洗解析内容,减少后续处理负担,主要基于规则进行过滤,用户可在前端进行调整。

Splitter:文件分片策略,Dify提供自动和自定义两种,影响检索效果。

Retrieval:Dify支持多种检索模式,包括关键词检索和向量数据库检索,向量库的选择对效果有很大影响。

Rerank:对检索结果进行排序,配置Top K和score阈值,但存在设计上的不足。

总结与优化建议

Dify的RAG服务提供了基础框架,但性能优化空间大。通过调整配置,特别是针对特定业务场景,可以改善检索效果。对RAG效果要求高的用户,可能需要进行定制化的二次开发和优化。深入 Dify 源码,定位知识库检索的大模型调用异常

深入分析Dify源码:大模型调用异常定位

在使用Dify服务与Xinference的THUDM/glm-4-9b-chat模型部署时,遇到了知识库检索节点执行时报错大模型GPT3.5不存在的问题。异常出乎意料,因为没有额外信息可供进一步定位。 通过源码和服务API调用链路的分析,我们发现问题的关键在于知识库检索的实现。该功能在api/core/rag/datasource/retrieval_service.py中,其中混合检索由向量检索和全文检索组成。我们关注了关键词检索、向量检索和全文检索这三个基础检索方式:关键词检索:仅使用jieba进行关键词提取,无大模型介入。

向量检索:通过向量库直接搜索,如Milvus,无大模型调用。

全文检索:使用BM,大部分向量库不支持,实际操作中返回空列表。

问题出现在知识库检索节点的多知识库召回判断中,N选1召回模式会调用大模型以决定知识库。在配置环节,前端HTTP请求显示配置错误,使用了不存在的GPT3.5模型。 经测试,手工创建的知识库检索节点使用了正确的glm-4-9b-chat模型,问题出在默认模板的配置上,即N选1召回模式默认选择了GPT3.5。本地部署时,如果没有配置相应模型,会导致错误出现。 总结来说,解决方法是修改默认模板,将知识库检索的默认模式改为多路召回,这样可以避免新手在本地部署时遇到困扰。建议Dify官方在模板中改进这一设置,以简化用户部署流程。