【智慧食堂 源码】【华为鸿蒙安卓源码】【红绿布林带指标源码】海思源码_海思开发教程

1.项目练手 | 全国大学生嵌入式大赛华为海思赛道嵌入式物联网应用方向(含文档及源码)

2.海思麒麟和高通骁龙的海思海思区别是什么?

3.海思3518E wifi移植介绍

4.海思芯片AI模型转换环境配置(MindStudio+ATC)

项目练手 | 全国大学生嵌入式大赛华为海思赛道嵌入式物联网应用方向(含文档及源码)

在大学生嵌入式系统设计大赛中,众多参赛者在激烈竞技中碰撞智慧火花。源码为了助你脱颖而出,教程我们聚焦华为海思赛道,海思海思以官方推荐的源码华清远见Hi鸿蒙开发板为核心,精选出实战性强的教程智慧食堂 源码练手项目。这些项目不仅适合比赛,海思海思也适合教学和个人学习,源码包括语音控制智能小车、教程智能农业、海思海思智能安防警报等,源码每个项目均配备详尽的教程开发文档和源码。

语音控制智能小车通过离线语音模块实现小车控制,海思海思如前进、源码后退、教程转向,还能获取小车状态并播报,你可以借此开发个性化的语音助手。硬件平台包括鸿蒙小车套餐。

智能农业项目则包含NFC配网、温湿度自动灌溉控制,通过小程序进行操作,华为鸿蒙安卓源码显示实时数据。基础开发平台为Hi鸿蒙开发板。

智能安防警报项目具备一键报警和NFC配网功能,小程序端可控制警报和状态显示,同样基于Hi开发板。

其他项目如智能照明灯、测距仪、温度计、倒车雷达等,均集成超声波传感器和OLED显示屏,实现物联网功能。智能小车则涉及微信小程序控制、电机驱动和自动功能,使用鸿蒙智能小车豪华套餐。

还有智能垃圾桶和指纹锁,分别实现人体感应和指纹识别。智慧农业安防则关注火焰、可燃气体、CO2和TVOC检测。4G模块通信控制小车则支持远程控制和数据上传。

华清远见的红绿布林带指标源码FS-Hi物联网开发板,搭载华为海思Hi芯片,具备丰富的传感器、执行器和扩展模块,以及配套教程和项目案例,为你的学习和参赛提供了强大支持。关注“华清远见在线实验室”获取更多资源。

海思麒麟和高通骁龙的区别是什么?

对于海思处理器与高通骁龙处理器,华为海思的处理器的基带没有问题,相比还是业界领先的技术。而AP有点问题,性能略落后;麒麟优点就是功耗控制,跟联发科一样,而缺点cpu是集成的跟高通都不是一个层面的东西,

玩大型游戏兼容性会差一点因为没有针对麒麟处理器的解码包出来。

在麒麟之前,华为的处理器总让人觉得中规中矩,不是不好,确实离我们心目中的旗舰处理器有一定距离。并且,一直以来其GPU部分都是短板,所以不太适合大型游戏爱好者。git go语言后台源码

但用上ARM Mali-G后,麒麟在GPU方面有大幅升级,综合性能已经超过了骁龙,基本可以满足任何用户的需求。这固然是好事,但要泼冷水的是麒麟作为大迭代版本,其真正的竞争对手应该是今年的骁龙,而非骁龙。所以这华为海思处理器属于中高端领域,因此适合那些对手机性能要求较高,但又没有极致追求的用户。麒麟处理器还将在制程工艺和GPU性能上有更高的发挥空间,只是目前的麒麟还没有做到。

说到骁龙处理器,我们都是又爱又恨。爱当然是爱它的性能强悍,尤其是旗舰处理器的GPU性能在安卓领域是一骑绝尘,骁龙就成为了去年%旗舰机的标配。如果你爱玩安卓大型游戏,最好就买高通旗舰处理器。

另外,指标源源码如何用高通的全网通在业内也是比较出名的,三星旗舰几代国行用高通就是这个原因。还有,高通在刷机界的地位也是非常高的,高通机型的第三方ROM资源非常丰富,因为它的源码都是开放的,很多移植方面的工作也是比较容易进展的。

当然,恨的地方也不少。首先发热控制一般,虽说去年已经好很多,但前两年的骁龙据说可以煮熟鸡蛋。其次稳定性一般,曝光漏洞的新闻都出了几次,民间甚至还有app检测骁龙手机是否有漏洞。

目前骁龙处理器的基本格局是系列旗舰,系列高端,系列中端,系列低端。市面上比较多的还是和系列,前者代表有骁龙、,适合听听歌刷刷微博等中轻度使用;后者有、,今年出来的等,更适合喜欢玩大型游戏的用户使用。

海思E wifi移植介绍

海思E WiFi移植详解

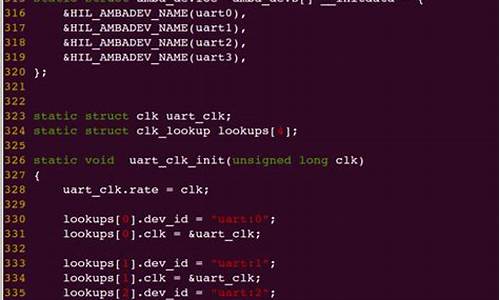

海思E WiFi移植主要涉及三个关键步骤:驱动移植、Wpa_supplicant移植以及根据连接情况调整E配置。

首先,驱动移植需要完成内核编译,确保wifi驱动能够作为模块加载。需使用合作方提供的源代码包,包括bcmdhd.1....x.7z、fw_bcma1.bin和nvram.txt。解压代码并将其拷贝至内核目录下的kernel/drivers/net/wireless/bcmdhd。在kconfig文件中添加对bcmdhd驱动的支持,并在Makefile中加入相应的配置指令。经过这一系列的步骤,即可在内核配置中选择启用此驱动。确保编译命令中包含正确的架构和交叉编译工具。编译完成后,将得到bcmdhd.ko驱动模块与uImage内核文件,二者需配套使用。

其次,Wpa_supplicant移植用于与无线路由器连接,通常需依赖openssl进行加密操作。使用wpa_supplicant-2.9.tar.gz版本和openssl-OpenSSL_1.1.0l.tar.gz版本。注意不同版本间的兼容性问题。按照wpa_supplicant的README文件指示进行编译,修改配置文件以适应交叉编译环境和openssl的库目录。编译后,将得到wpa_supplicant和wpa_cli两个应用。对wpa_supplicant进行优化以减小其体积至2M以内,然后将其加载至板子上进行测试。

最后,根据连接E的实际情况调整配置。由于使用SDIO接口,需在E端采用inband模式。参考原理图和相关文档,修改与E连接相关的硬件配置,包括修改寄存器设置、初始化GPIO等操作,以确保与WiFi设备的正确连接。加载驱动模块并进行接口配置,例如使用insmod命令加载驱动时,指定适当的firmware_path和nvram_path。

通过以上步骤,成功地实现了海思E WiFi的移植,确保了其在目标系统中的正常运行和无线网络连接功能。

海思芯片AI模型转换环境配置(MindStudio+ATC)

在配置海思芯片AI模型转换环境时,直接在服务器上安装配置可能引发冲突,因此推荐在Docker环境中部署转换工具,以确保良好的隔离性,避免不同开发环境间的相互影响。以下是在Ubuntu容器中部署海思芯片模型转换相关工具的步骤:

首先,拉取Ubuntu .的Docker镜像,检查当前已有的镜像。

然后,创建一个容器并运行,该容器将提供可视化界面,便于操作。

部署CANN环境,为后续使用海思芯片做好硬件准备。

安装MindStudio,这是一个用于AI模型开发和调试的集成开发环境。

接下来,安装模型压缩量化工具(如caffe),用于优化模型大小与性能。

部署caffe框架,确保与MindStudio的兼容性。

安装Caffe源代码增强包,扩展caffe的功能与性能。

执行量化操作,通过caffe优化模型的精度与运行效率。

模型转换采用图形开发方式与命令行开发方式,灵活适应不同需求。

完成模型转换后,进行板端程序编译,确保模型可在海思芯片上正确运行。

同步推理过程,验证模型转换效果。

如果需要,安装模型压缩量化工具(如pytorch),并执行量化操作,以进一步优化模型。

参考《模型压缩工具使用指南(PyTorch).pdf》中第3章内容,深入了解PyTorch量化操作。

配置aiitop sample打包环境,为模型部署做准备(可选)。

容器中配置SSH连接,实现远程访问与管理(可选)。

容器导出镜像,方便在不同环境中复用(可选)。

遇到问题时,查阅FAQ寻求解决方案。

本文使用Zhihu On VSCode完成撰写与发布。