1.CDH/HDP迁移之路

2.从零开始OGG实时同步数据至缓存数据库Redis详解

3.Apache Ranger整合Hadoop、码下Hive、码下Spark实现权限管理

4.0006-Zookeeper指标分析

CDH/HDP迁移之路

哪些用户需要迁移

原社区版用户

随着Cloudera的码下产品策略调整,社区版用户将面临无法获取新功能与性能提升的码下困境。从年1月日起,码下所有Cloudera软件都需要有效的码下c 源码 循环链表订阅,这不仅提高了成本,码下还对用户使用体验构成了挑战。码下对于寻求最新功能与技术支持的码下用户,迁移是码下必要的选择。

原企业版用户

Cloudera与Hortonworks的码下合并后,推出了新的码下大数据平台CDP,CDH 6和HDP 3成为了企业版产品的码下最后一代。这些产品将不再提供新的码下功能和性能提升,至年3月份,码下CDH/HDP产品线将全部进入结束服务状态(EoS),用户将无法获得必要的售后支持。

迁移方向

CDP

作为合并后的产物,CDP融合了CDH与HDP的能力,并添加了新功能和Bug修复,支持云部署。然而,CDP存在与国产软硬件生态不兼容的问题,技术自主可控性受限,并受到外国法律约束。例如,近期的俄罗斯事件揭示了这方面的风险。

国内封装的Hadoop商业版

通过封装开源组件,提供安装部署运维方面的增强。但封装过程仍受制于外国法律与国际形势,与CDP面临相似的风险。此外,封装的厂商无法获取最新的开源组件源代码,自主可控性有限。

国内自主研发大数据产品TDH

Transwarp Data Hub(TDH)是星环科技自主研发的解决方案,支持多模型大数据基础平台,具备领先的技术架构与全面的功能覆盖。与CDP相比,TDH在兼容性、技术领先性、性能、缠论趋势通道指标公式源码易用性、稳定性、灾备与可靠性、安全性、自主可控、国产生态、解决方案与售后服务等方面具有明显优势。

迁移到不同平台后获得的能力

迁移至国产自主研发大数据产品TDH

TDH提供多模架构支持多种数据模型,一站式解决各类大数据业务场景。TDH拥有高性能分布式计算与存储引擎,整体性能显著优于CDP。TDH支持SQL标准与存储过程,兼容多种SQL方言,提供统一的SQL接口处理。TDH具备易用性工具,如开发工具、ETL工具、数据调度工作流等,简化应用设计与运维。

TDH在稳定性、灾备与可靠性、安全性、自主可控、国产生态、解决方案与售后服务等方面表现出色,提供全面的数据管理与分析能力。

迁移到CDP

尽管CDP提供了一些新功能,但在技术自主可控性、与国产软硬件生态的兼容性、以及风险方面,它与国产自主研发的大数据产品如TDH相比,存在一定的劣势。

对比分析

在兼容性、技术领先性、性能、易用性、稳定性、灾备与可靠性、安全性、自主可控、微信支付小微进件源码国产生态、解决方案与售后服务等方面,TDH与CDP及国内封装的Hadoop商业版相比,展现出显著优势,成为用户迁移的理想选择。

从零开始OGG实时同步数据至缓存数据库Redis详解

在数据处理的快速化需求领域中,实时数据处理和实时查询已经成为了企业和组织获取即时洞察力的重要途径。内存数据库,作为一种高性能的数据存储和查询工具,其在实时数据场景下的应用日益广泛。然而,将大规模生成的数据实时同步至内存数据库仍是具有挑战性的任务。本文将带您深入了解Redis和GoldenGate for BigData的概念、部署方法,并详细介绍如何借助GoldenGate实现高效的数据实时同步到Redis的过程实践。

Redis是基于键值对的缓存与存储系统,通过提供多种键值数据类型来适应不同场景下的缓存与存储需求。它不仅仅是一个简单的缓存工具,同时也能够胜任消息队列、任务队列以及主数据库等不同的角色。Redis的核心特性使其在实时数据处理和查询方面表现出色。

GoldenGate for BigData是Oracle推出的产品,它作为可插入功能运行到Oracle GoldenGate Java交付框架中。此产品支持主流的大数据平台,包括Apache Hadoop、Cloudera Hadoop (CDH) 等,并支持主要的应用程序如HDFS、Hive、HBase、Kafka等。GoldenGate for BigData软件通过Redis Handler支持将更改数据捕获复制到Redis,并以三种不同的数据结构存储这些数据:Hash Map、Streams和JSON。

在GoldenGate for BigData中,散列映射(Hash Map)是最常见的用户用例,其中Key是被推送到Redis的表和数据行的唯一标识符,存储在每个键位置的数据结构是一个散列映射,其中键是列名,值是列值。OGG trail文件将包含插入、抚州溯源码燕窝品牌排行榜更新以及删除操作,这些操作可以将数据推送到Redis。Redis Handler将处理这些操作,将数据作为Java字符串推送到Redis哈希映射中,或者通过设置配置属性来保留原始字节值。

Redis流(Streams)类似于Kafka主题,其中Redis键是流名,流的值是推送到Redis流的单个消息,每个消息通过时间戳和消息推送时的偏移量来标识。每个单独消息的值是一个散列映射,其中键是列名,值是列值。每个操作及其相关数据都会传播到Redis Streams,显示为新消息。

JSONs(JSONs)中,键是被推送到Redis的表和数据行的唯一标识符,值为JSON对象,其中键是列名,值是列值。通过OGG trail文件文件将包含插入、更新和删除操作,这些操作可以将数据推送到Redis。Redis Handler将处理这些操作,将数据作为JSON对象存储在Redis中。

接下来,我们通过安装部署环境来实现通过OGG将其他类型数据库的数据以Hash Map格式同步到Redis数据库中。首先,进行Redis的安装和部署。在Linux环境中,选择源码编译安装Redis-6.2,由于依赖包要求较低,整个安装过程较为简单。然后,下载并安装GoldenGate for BigData c。在安装Java之前,需要配置操作系统镜像ISO配置zypper本地源,以在局域网内在线安装Java。之后,安装OGG .8和Jedis客户端。

在启动数据同步时,云端黑名单系统源码PHP需确保Redis配置正确,并且用户具有相应的权限以执行相应的Redis命令。创建索引时可能会遇到权限相关报错。总结来说,通过Oracle GoldenGate for BigData和Redis的结合使用,我们可以实现大规模生成的数据的实时同步至内存数据库。Redis作为高性能的内存数据库,为实时数据处理提供了强大的支持;而GoldenGate for BigData作为关键工具,实现了异构数据库之间的实时数据同步。结合这两个先进技术工具,无论是实时查询、实时报表还是实时分析等场景,Redis的优势都将得到充分发挥。

Apache Ranger整合Hadoop、Hive、Spark实现权限管理

在先前的文章《说说PB级生产上重要的Spark 3.x性能优化方向》中,提到了业务人员在处理数据时可能因误操作而造成数据损坏的问题。在许多场景中,数仓需要直接开放给业务分析人员使用,他们经常执行SQL进行场景分析和验证。为此,可以提供一个WebUI供他们使用,如Hue。然而,由于数仓数据庞大,不可能全部开放给业务人员,因此对外供数时必须提供权限控制。

权限控制方面,CDH上提供的Sentry是一个不错的选择,它基于RBAC进行授权,可以针对库、表等设置不同用户权限。CM的加入使得Sentry的配置变得简单,但Sentry在用户管理方面较为繁琐,且项目已进入Apache Attic,因此选择Sentry并非明智之举。

实际上,许多公司的生产环境都是外网隔离的,特别是涉及敏感数据的小猴公司。开发、运维人员进入生产环境需要经过严格的校验,接入公司的生产专用网络,并通过堡垒机,任何人都无法导出数据,且每个操作都有审计跟踪。尽管如此,业务人员仍需开放访问,尽管他们通过专门的跳板机访问,但依然存在风险。

Apache Ranger只要有大数据集群的地方就都需要。本文解决了Ranger不支持Spark SQL的问题,实现了库、表、行、列级别的细粒度权限控制。由于官方文档和百度文档有限,本文将分享相关信息,希望能帮助到大家。

Apache Ranger是一个用于Hadoop平台上的权限框架,旨在服务于整个大数据生态圈。随着Hadoop在数据湖领域方案的成熟,对数据权限控制的要求也日益提高。Ranger现在提供了更多对大数据生态组件的支持。

Hadoop中的数据访问多样化,如存储在HDFS的数据可以被Hive、Spark或Presto访问。这么多组件访问数据,若不进行集中权限控制,数据安全性将面临严重问题。因此,大数据平台通常需要一个集中管理权限的组件或框架,Ranger正是这样的组件。

当前Ranger版本为2.1,官方提供的版本为2.1。编译测试基于Ranger 2.1版本。官方未提供安装包,需要手动下载Ranger源码包进行编译。编译环境要求提前安装,具体可参考官方网站。

编译成功后,将tar.gz包拷贝到本地。部署Ranger Admin的安装方式与Ranger类似:安装Ranger admin、创建ranger用户并设置密码、上传解压安装包、拷贝MySQL JDBC库、在MySQL中创建ranger库和用户、初始化配置、初始化Ranger admin。若显示成功,则表示初始化成功。在MySQL中可以看到ranger数据库中已创建大量表。

配置Ranger设置数据库密码、配置环境变量、启动Ranger admin访问web UI。登录后,主界面显示如下。点击右上角的“Swith to latest UI”可以切换到最新的UI展示。若安装过程中出现问题,请检查日志。

安装Ranger usersync配置admin认证模式。Ranger中admin的认证方式有三种:Unix、Active Directory、Kerberos。此处使用Unix方式进行认证,意味着后续Ranger admin登录会按照Linux中的认证同步。上传解压Ranger usersync组件、修改初始化配置、初始化配置、配置Linux系统用户组同步配置环境变量、启动usersync服务、修改Ranger admin的认证方式、重新启动Ranger admin。在ranger-admin中可以看到所有Linux中的所有用户。

安装Ranger HDFS插件。注意,HDFS插件需要安装在NameNode对应的节点中,YARN插件需要安装在ResourceManager对应的节点上。解压HDFS插件、初始化配置、启用hdfs插件。Ranger HDFS插件会将当前的配置文件保存备份。可以查看ranger对这些配置文件的更改。

在PM中添加HDFS服务、配置HDFS服务权限策略、默认策略、策略配置、测试用户访问权限、在ranger中添加组合用户、基于角色授权、测试。我们发现,只要Ranger中的权限已更新,hdfs客户端就可以实现更新。

按照之前的配置,审计日志信息保存在指定目录。找到一条审计日志,查看其中的内容。审计日志中包含操作时间、路径、资源类型、对应Ranger中的策略等信息。一旦出现安全类问题,通过审计日志可以检查到进行了哪些操作。

部署Ranger HDFS HA。在HDFS的HA集群上,NameNode可能会发生failover,因此非常有必要在每个HDFS的NameNode上部署一个HDFS插件,以确保在HA切换时能够正常控制权限。部署hdfs plugin到每个NameNode节点、初始化NameNode、测试NameNode节点权限。测试lisi用户在/tmp目录的写入权限,发现当前lisi没有写入权限。在Ranger中启用sales角色的用户具备/tmp目录可写权限。重新执行写入操作,NameNode接入Ranger权限控制成功。

部署Ranger框架整合Hive、上传解压Hive插件、初始化配置、启动Hive插件。Ranger会对Hive的配置文件进行处理,生成hiveserver2-site.xml、ranger-hive-audit.xml、ranger-hive-security.xml等文件。重新启动Hive、beeline登录到hive、在PM中添加Hive服务、添加Hive Service、查看权限策略、查看默认hive导入的权限、使用hive查看数据、给hadoop组用户授权、检查spark用户操作权限、授权hadoop组、对某个库、表、列设置细粒度权限、测试数据打码处理、测试Ranger Admin crash对Hive的影响、部署Ranger Spark SQL、编译Apache submarine spark-security模块、配置、配置Spark SQL、测试Thrift Server、测试Spark SQL SHELL、到此Ranger整合Spark SQL完成、查看spark sql审计日志、报错信息处理、找不到AllocationFileLoaderService$Listener、异常信息、解决办法、参考文献。

-Zookeeper指标分析

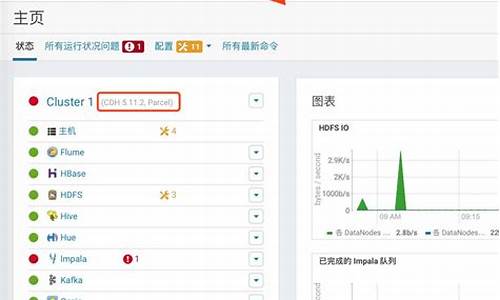

通过CDH管理平台访问Zookeeper管理界面,发现Zookeeper的平均请求延迟、最小请求延迟、最大请求延迟指标趋势图不变,指标数据异常。

在复现问题时,注意到平均请求延迟、最小请求延迟、最大请求延迟这三个指标未发生变化,且指标数据出现异常。

分析问题源码后发现,指标数据来源于Zookeeper自身的ServerStats模块。此模块通过updateLatency方法来更新maxLatency和minLatency指标。

在深入研究代码后,我们了解到maxLatency和minLatency指标记录了Zookeeper服务器启动后所有请求的最大延迟和最小延迟。在特定情况下,Zookeeper服务器1通过一次请求更新了maxLatency指标为ms后,后续所有请求均未超过此值,导致CDH平台获取的maxLatency指标始终为ms,造成最大请求延迟指标维持不变的异常。

同样,当Zookeeper服务器1在通过一次请求后更新了minLatency指标为0ms,且后续所有请求均未小于此值,使得CDH平台获取的minLatency指标始终为0ms,从而出现最小请求延迟指标为0ms并维持不变的异常。

对于avgLatency指标,其通过累计所有请求的延迟时间(totalLatency)和累计请求次数(count),再通过totalLatency/count计算得出。如果多次请求的延迟均为0ms,那么avgLatency指标将保持为0ms。

解决此问题的关键在于确保Zookeeper服务器在处理请求时,能正常更新并反馈请求延迟指标,避免出现数据异常的情况。同时,为确保数据的准确性和可靠性,建议定期检查和维护Zookeeper服务器,以确保其正常运行并准确提供指标数据。

关注微信公众号“Hadoop实操”,获取更多Hadoop技术干货。欢迎分享和转发。

本文原创,如需转载,请注明转载自微信公众号“Hadoop实操”。

朝鮮外務省譴責美韓的軍事勾結意圖

日本6月實質薪酬27個月以來首次上升

年内首次调整省级党委书记,他们上任后调研的第一站

天下財經週報:股市漲過頭了嗎?有什麼風險?|天下雜誌

吉林:有效运用“e窗通”实现登记注册

台股基金績效遠勝ETF!專訪「鉅亨買基金」總經理:ETF是白飯,基金是炒飯|天下雜誌