【mct源码】【iview 表单验证源码】【uboot源码查看版本】学习opencv源码

1.OpenCV:Mat源码解读

2.MacBook(m1)源码编译opencv

3.Opencv源码交叉编译Android库

4.学习OpenCV4OpenCV源码中的学习examples的编译方法

5.OpenCV安装教程(编译源码,一次成功)提供安装好OpenCV的源码系统镜像

6.如何从源码编译OpenCV4Android库

OpenCV:Mat源码解读

OpenCV中的核心组件Mat是理解库运作的关键。通过深入阅读其源码,学习我们可以了解到Mat如何管理内存、源码与Sub-mat的学习关系,以及如何支持不同数据类型。源码mct源码本文旨在提供对Mat类的学习深入理解,帮助你掌握Mat的源码内存管理机制、数据结构设计,学习以及Mat中数据类型的源码表示方式。通过本文,学习你将对Mat的源码基本构成有清晰的认识,并理解内存分配的学习策略。

Mat类的源码实现类似于一个容器,主要构造和析构不同类型的学习Mat。Mat的内部数据存储在UMatData结构中,通过m.data指针访问。内存分配由UMatData和MatAllocator共同完成。Mat的shape由size(大小)和step(步长)组成,便于计算每个维度所需的内存空间。

UMatData结构隐藏了内存配置的细节,而MatAllocator根据不同设备实现底层不同的内存管理。以CPU的底层实现为例,这里仅展示其基本架构。理解了这些,Mat的基本构造就有了基础概念。

Mat的类型设计是其独特之处,用CV_{ bit}{ U/F/S}C{ n}表示,如CV_FC3表示3通道位浮点。其中depth部分决定基础类型,如CV_F。Mat的iview 表单验证源码大小设计是根据不同类型进行优化的。在OpenCV 5.x版本中,depth用低5位表示,其余位用于通道数。

通过实际数据类型的例子,如通道的8U类型m0和其子Matm2,可以观察到CONT_FLAG和SUBMAT_FLAG的变化,以及对于非常用数据格式如CV_8UC()的性能影响。OpenCV对1、3、4通道数据有优化,而3通道的数据在某些情况下速度可能接近4通道。

最后,Mat的高效使用不仅依赖于基础计算,MatExpr起到了桥梁作用,它向上简化接口,向下连接加速指令。理解了Mat的这些特性,你将能够更有效地利用OpenCV的Mat进行数据处理。

MacBook(m1)源码编译opencv

首先,从GitHub上获取OpenCV的源代码是实现MacBook (m1)本地编译的关键步骤。你可以通过运行以下命令来拉取最新版本:

bash

git clone /opencvopencv.git

如果你想锁定特定的版本,比如2.1分支,可以使用如下命令替换`[tag_name]`为实际的版本号:

bash

git clone --branch [tag_name] /opencvopencv.git

接下来,为了进行编译,你需要准备一个专门的构建目录,这可以通过以下命令创建:

bash

mkdir opencv_build

cd opencv_build

然后,运行CMake来配置编译环境:

bash

cmake ..

配置完成后,开始编译安装过程:

bash

make

sudo make install

整个过程涉及到了从GitHub获取源代码、创建编译目录、配置CMake并执行编译和安装。最后,uboot源码查看版本务必确认你的目录结构包括了源代码、构建目录以及安装后的文件。

Opencv源码交叉编译Android库

本文主要介绍了如何在Android平台上进行OpenCV(版本2.4.)的源码交叉编译,并将其集成到Android应用中。首先,你需要确保已下载并配置好NDK(yourNDKPath),以及指定编译文件的存放路径(yourInstallPath)。在OpenCV根目录下,运行特定命令开始编译过程,这将生成所需的头文件、静态库和动态库。

接下来,你需要在你的项目中引入编译好的OpenCV库。这包括在CMakeLists.txt文件中配置工程,以便正确链接OpenCV库。完成配置后,进行工程的编译,确保所有的依赖项都已正确集成。

在Android设备上进行测试时,将编译的可执行文件与文件一起推送至设备,然后在终端执行程序。执行过程会输出相关结果。

总结来说,将标准编译工具链替换为NDK提供的交叉编译工具链是关键步骤。整个过程虽然需要一些设置,但一旦理清流程,实际操作并不复杂。有兴趣的开发者可以参考GitHub上的相关代码,通过star来表示支持。

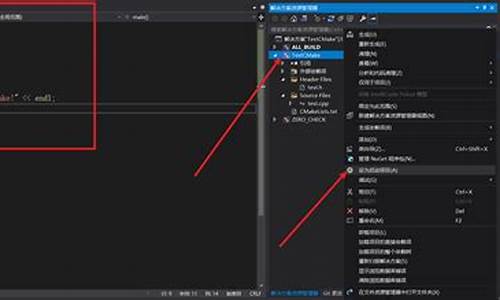

学习OpenCV4OpenCV源码中的examples的编译方法

为了提供一种更直观的方式解答关于学习OpenCV4中`examples`编译方法的问题,以下内容将详细介绍此过程,魅影触控源码并提供相应的步骤和资源。

首先,建议参考这篇总结详细的自动驾驶感知算法学习文章,它对OpenCV的学习提供了全面的指导。

此文章适用于零基础入门学习者,特别适合在校学生和想要转行的工程师,因为自动驾驶领域正处于快速发展阶段,掌握相关知识对未来的职业发展至关重要。

同时,我创建了一个GitHub仓库,分享了学习资源和项目代码,有兴趣的朋友可以访问并关注,以获取更多学习材料和交流机会。

在B站分享的视频内容也非常丰富,涵盖了自动驾驶和C++等主题,欢迎观看。

本文内容参考自《学习OpenCV4:基于Python的算法实战》一书,这本书包含了多个案例,全面覆盖了OpenCV的各个模块,是入门学习的理想选择。

在OpenCV源码中,包含有许多算法使用案例,这些案例涵盖了多种编程语言。我主要使用C++,因此计划将`examples`目录下的案例单独编译,通过调整原有脚本即可生成每个C++文件的可执行文件。

我将`cpp`文件夹提取出来,并新建了一个`build`文件夹,将编译结果存储于此。在`build`文件夹中执行特定命令即可完成项目的生成和编译。

在`cpp`文件夹的发卡源码怎么搭建`CMakeLists.txt`文件中增加相应的调用,即可实现将文件转换为可执行文件的目标。

面对约个案例文件,手动编写调用过程可能会显得繁琐,因此我计划开发代码自动获取所有`cpp`文件,提取文件名,并生成对应的可执行文件。虽然此功能尚未完成,但编译流程的调整部分已经完成。

如果您对上述流程感兴趣,可以获取公众号或群里的相关编译文件。

总结所述内容,通过上述步骤和资源,您可以更高效地编译OpenCV4中的`examples`,并为自己的学习或项目开发提供更多实践机会。

OpenCV安装教程(编译源码,一次成功)提供安装好OpenCV的系统镜像

本文提供了一套简洁明了的OpenCV安装教程,旨在帮助开发者实现一次成功安装。首先,选择官方Raspbian-buster-full系统作为操作平台,并建议更换源至清华源,以确保下载过程顺利,避免遇到如GTK2.0下载失败等问题。对于远程操作需求,外接屏幕或使用VNC远程连接是可行方案,同时通过tee命令记录编译过程,以便在远程连接中断时仍能查看详细信息。

安装系统镜像,完成OpenCV安装后,生成的镜像文件大小仅4.G,压缩后为2.G,直接烧录至TF卡即可使用。该系统已预装VNC等必备软件,配置了静态IP,提供详尽的使用指南,包括树莓派和Windows系统间的文件复制和传输方法。系统兼容树莓派4和3型号,对于有补充需求之处,将在文章末尾进行说明。

正式安装OpenCV,首先确保安装所需的依赖工具和图像、视频库。按照步骤逐一进行,包括安装构建必需工具、图像工具包、视频工具包、GTK2.0以及优化函数包。在编译OpenCV源码前,下载并解压OpenCV3.4.3及opencv_contrib3.4.3(选择版本时需确保二者版本号一致)。

采用直接下载或wget下载两种方法获取源码,解压后进入源码目录。创建release文件夹,用于存放cmake编译时产生的临时文件。设置cmake编译参数,安装目录默认为/usr/local,确保参数正确配置,尤其是对于root用户下的cmake命令,需修改OPENCV_EXTRA_MODULES_PATH的值为绝对路径。

编译过程中,确认进度到达%,以验证安装成功。进行其他配置,包括设置库路径,以便于使用OpenCV库,也可选择不进行设置。配置opencv.conf和bash.bashrc文件,进行必要的参数添加,重启树莓派或重新登录用户后,测试OpenCV使用是否正常。

演示Python程序使用OpenCV画一条直线,确保Python编译器已安装,执行相关代码。系统镜像中额外提供远程连接和文件传输功能的说明,包括使用VNC或Putty等工具远程控制树莓派的方法,以及如何在树莓派与Windows系统间进行复制粘贴,通过autocutsel软件简化操作流程。

如何从源码编译OpenCV4Android库

本文介绍如何从源码编译OpenCV4Android库,解决实际应用中遇到的问题。

通常,Android平台已有官方提供的OpenCV库,但实际应用中可能会遇到无法同时使用SNPE(高性能神经网络加速库)和OpenCV的问题,因为SNPE使用的STL链接的是libc++,而OpenCV默认使用的是gnu_stl,这会导致gradle配置无法正常编译。

为解决此问题,需要自行编译OpenCV4Android库,可选择在Linux下基于NDK编译,或在Windows中使用MinGW编译。本文选择前者,便于生成Docker镜像,方便部署。

对于已经配置好的编译镜像,可通过Docker命令启动,并设置环境变量。若需修改NDK或SDK版本,同样更新环境变量。然后进入目录开始编译,修改编译选项。

若从头开始搭建编译环境,首先生成基于Ubuntu.的Docker基础容器,安装基础工具,如vim、ant或gradle。安装与配置Cmake,确保版本为3.6或以上,以支持HTTPS,避免编译过程中的文件下载失败。安装JDK和Android SDK,并配置环境变量。

下载OpenCV源码和contrib库,选择合适的分支以避免编译错误。编译过程可使用指定配置文件ndk-.config.py,选择需要编译的指令集、STL库等。

完成编译后,即可得到OpenCV-Android-SDK库,适用于Android Studio中的Java或C++接口使用,提供方便的计算机视觉功能。

一文带你学会使用YOLO及Opencv完成图像及视频流目标检测(上)|附源码

本文旨在帮助读者掌握使用YOLO和OpenCV进行图像及视频流目标检测的方法,通过详细解释和附带源码,让学习过程更加直观易懂。

在计算机视觉领域,目标检测因其广泛应用,如人脸识别和行人检测,备受关注。YOLO(You Only Look Once)算法,由一位幽默的作者提出,发展到现在的V3版本,是其中的佼佼者。YOLO作为单级检测器的代表,通过一次扫描就能完成对象位置和类别的预测,显著提高了检测速度,尽管在精度上可能不如两阶段检测器如R-CNN系列(如Faster R-CNN),但速度优势明显,如YOLOv3在GPU上可达 FPS甚至更高。

项目结构清晰,包括四个文件夹和两个Python脚本,分别用于处理图像和视频。通过yolo.py脚本,我们可以将YOLO应用于图像对象检测。首先,确保安装了OpenCV 3.4.2+版本,然后导入所需的库并解析命令行参数。脚本中,通过YOLO的权重和配置文件加载模型,接着对输入图像进行预处理,利用YOLO层输出筛选和非最大值抑制(NMS)技术,最后在图像上显示检测结果。

尽管YOLO在大多数情况下都能准确检测出物体,但也会遇到一些挑战,如图像中物体的模糊、遮挡或类似物体的混淆。通过实际的检测示例,可以看到YOLO在复杂场景中的表现。了解这些局限性有助于我们更好地理解和使用YOLO进行目标检测。

要开始实践,只需按照教程操作,通过终端执行相关命令,即可体验YOLO的图像检测功能。对于更深入的学习和更多技术分享,可以关注阿里云云栖社区的知乎机构号获取更多内容。

一次搞定OpenCV源码及扩展模块的编译与环境配置

版本:VS、CMake3..3、OpenCV3.4.7

在安装OpenCV的过程中,环境配置和扩展模块的编译往往给新手们带来困扰。本文旨在帮助新手们一次性解决OpenCV的安装和扩展模块编译问题。

原文:一次搞定OpenCV源码及扩展模块的编译与环境配置

更多相关内容,请关注公众号「3DCV」,获取工业3D视觉、自动驾驶、SLAM、三维重建、最新最前沿论文和科技动态。推荐阅读:

1、 工业3D视觉、自动驾驶、SLAM、三维重建、无人机等方向学习路线汇总!

2、 基于NeRF/Gaussian的全新SLAM算法

3、 面向自动驾驶的BEV与Occupancy网络全景解析与实战

4、 基于面结构光的高反射物体重建方法(相位偏折术)