1.etcd概述

2.etcd技术架构以及其内部的源码实现机制

3.Etcd分布式锁原理和使用

4.etcd 入门与实践

5.一文讲清ETCD

6.Golang 通过ETCD 选主

etcd概述

etcd是一个分布式键值存储系统,通过高效可靠的租约Raft协议实现数据一致性与高可用性。它能够有效处理网络问题和机器故障,源码确保数据在面临挑战时仍保持完整性。租约etcd不仅提供基本的源码数据存储,还支持服务发现、租约FFH反码移码源码分布式锁、源码队列和通知等功能,租约以及集群选举的源码协调任务。

核心在于RAFT协议,租约它将分布式问题分解为选举、源码状态转移和时间管理三个子任务。租约在一个包含2n+1个节点的源码集群中,每个节点维护一个状态机,租约处于follower、源码candidate或leader状态。在follower状态,节点会定期检测心跳,若超时则转为候选人。leader通过多数节点的同意维持地位,而当发现更高级别的leader时,会自动调整为follower。

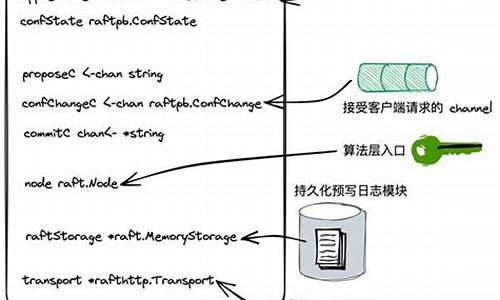

Etcd的架构主要由grpc_Server(提供raft接口)、mvcc/backend(基于BoltDB的KV存储)、schedule/fifo(任务队列)和lessor(租约管理)等模块组成。EtcdServer负责协调raftNode,后者则通过pipeline实现消息的高效发送。配置方面,etcd支持命令行和环境变量设置,命令行配置优先级更高。

启动时,etcd会生成WAL日志文件,记录不同类型的日志,如提交日志和事务。关于详细信息,可参考相关参考资料。

etcd技术架构以及其内部的实现机制

etcd是分布式的、可靠的、分布式存储K-V系统,用于存储分布式系统中的关键数据。etcd集群通常由3个或5个节点组成,通过raft算法完成分布式一致性协同。多个节点中选举出一个主节点作为leader,负责数据同步和分发,确保系统高可用性。客户端只需选择一个leader完成数据读写。dedecms网站更换源码关键概念quorum保证集群在部分节点故障时继续提供服务,通过raft一致性算法实现分布式一致性。

etcd架构中,数据表示为有序map,支持客户端实时获取增量更新。etcd提供API用于实现增量数据更新、事务操作以及支持watch机制。数据版本号机制确保数据一致性,重启集群后,数据版本号更新。etcd支持对同一key多次修改,查询时可指定版本号获取历史版本数据。

在etcd中,数据存储于B+树中,通过DMA加速查询操作。B+树维护revision到value的映射关系,支持客户端查询指定版本数据。etcd内维护另一个B+树管理key-revisions映射,满足不同查询场景需求。定期的Compaction机制清理历史数据,避免资源消耗。

etcd事务机制在多个监听中保证事务读写一致性,应用于如k8s项目对数据修改的一致性控制。Lease概念用于检测节点存活,创建租约后自动过期清理数据。多个key绑定在同一个Lease上,可降低Lease刷新时间,优化etcd系统性能。

启动etcd并插入数据,通过批量操作管理数据。数据修改后,全局版本号和revision依次递增,查询时可指定版本号获取历史数据。删除操作后,数据消失,再次插入数据后,全局版本号和create_revision、mod_revision更新,version重新计数。

etcd数据实时同步,实时感知数据变化。前缀监听和事务操作在分布式系统中广泛应用。K8s将元数据存储至etcd,简化状态流转,减轻系统复杂性。ansible源码实现ssh服务注册与发现利用etcd实现,后端进程动态注册地址,API网关及时感知,流量自动切换。etcd选主机制确保高可用性,通过投票选举leader管理集群状态。分布式系统中,etcd提供并发控制机制,限制任务并发度,避免资源瓶颈。

etcd的watcher机制与Lease概念结合,确保数据更新实时感知与节点状态检测,提高分布式系统效率与稳定性。etcd内部优化,如B+树结构与Compaction机制,确保数据高效存储与检索,支持大规模集群应用。etcd事务、Lease与watch机制在实际应用中展现出其在分布式系统中的价值与优势。

Etcd分布式锁原理和使用

在分布式系统中,互斥控制(即锁)是确保数据一致性的重要手段。在单体应用单机部署环境,利用语言原生的并发API实现锁较为简单,它们主要控制同一台服务器上的多个线程对共享资源的访问。然而,随着业务扩展到分布式集群,应用分散在多台机器上,且可能运行多个线程或进程,单一机器的锁控制机制不再适用。因此,分布式锁应运而生,用于跨服务器、跨进程进行互斥控制,保证多个线程或进程在特定时刻只能安全访问特定共享资源。

分布式锁的实现通常依赖于具备特定功能的分布式协调系统,如Etcd。Etcd通过其特性如租约(Lease)、版本(Revision)和前缀(Prefix)功能,支持分布式锁的实现。租约功能提供了一种过期机制,当租约到期,相应的Key-Value会被清除,确保客户端异常情况下锁能够自动释放。版本功能通过跟踪写操作的顺序,允许多个客户端公平获取锁或排队等待。塔防精灵源码前缀功能则支持锁的可重入性,避免了多个客户端尝试删除同一锁时可能出现的冲突。

实现过程包括:首先,客户端通过Etcd的/lock前缀创建全局唯一key,同时与租约关联,确保在客户端崩溃等异常情况时锁能自动释放。设立“心跳”任务维持租约活性,以防止锁被意外释放。接着,客户端执行put操作,将创建的key与租约关联并写入Etcd,记录返回的版本号。客户端通过监听/lock前缀下的Key变化,判断是否获取到锁。成功获取锁后,执行业务操作,并在完成操作后解除锁,释放资源供其他客户端使用。

在代码实现中,watch_dog函数负责在租约到期前定期刷新或续租,以保持锁的有效性。具体的时间间隔需根据应用需求和网络环境进行调整,以平衡资源消耗和租约过期风险。Etcd Concurrency库的实现代码提供了实现分布式锁的详细支持,具体细节可参考Etcd GitHub仓库中的clientv3/concurrency目录下的源码。

etcd 入门与实践

Etcd入门与实践概述

Etcd是一个由Go语言编写的分布式键值存储,专为需要在分布式系统或集群中访问的数据提供强一致性。它依赖于Raft一致性算法进行节点间通信,且在多个工业级项目中得到广泛应用,如Kubernetes、CoreDNS和ROOK等。Etcd与Redis场景的区别

面试中,面试官可能会询问Etcd和Redis的区别。Etcd更适合需要强一致性的场景,而Redis则更侧重于缓存和数据结构操作,且过期机制不同:Etcd的租约模式基于堆结构,而Redis是一对一绑定过期时间。实践操作

初学者可以从下载预编译二进制文件或编译源码开始,建立单节点服务。比如,使用goreman启动多个实例,理解PEER ADDRS和CLIENT ADDRS的含义。 尽管命令行工具etcdctl操作直观,但深入理解还需从代码层面入手。比如,南京分销系统源码初始化etcd客户端,执行put操作时,无论是普通key还是带有租约的key,都可通过同一方法实现,体现了装饰器设计模式。Get操作和MVCC机制

etcd v3版本引入了MVCC机制,允许查看key的历史版本,如通过etcdctl get hello --rev=?查看不同版本的值。Watch操作与事件通知

etcd通过event机制避免客户端轮询,客户端订阅感兴趣的key,key更新时,etcd通过channel进行通知。例如,./etcdctl watch hello会显示put和租约到期的事件。代码示例

本文详细介绍了Etcd的基础操作和工作原理,包括put、get、租约模式和watch功能,旨在帮助读者深入了解和实践Etcd的使用。一文讲清ETCD

ETCD概述

ETCD是由SoreOs公司发布的一个分布式、高可用的key-value存储数据库,基于Go语言实现,广泛应用于Kubernetes中作为数据库。它采用Raft算法代替Paxos算法,提供更好的性能和数据一致性。ETCD默认存储数据量为2GB,最大可达8GB,适用于热点数据存储,不建议作为应用数据持久化使用。ETCD常见应用场景包括服务发现、消息发布与订阅、负载均衡、分布式通知与协调、分布式锁与队列、集群监控与Leader竞选等。

ETCD架构与基本概念

ETCD架构包含多个组件和概念,如心跳机制、Leader节点、Raft算法、Node、Member、Cluster、Peer、Client、WAL、Raft Log、Snapshot、Proxy、Index、Follower、Candidate、Term等。这些组件协同工作,确保分布式系统的一致性和可靠性。

ETCD与Raft算法

ETCD采用Raft算法实现分布式一致性,包括法定人数机制、Leader、Candidata、Follower、Term概念、Lease租约机制、Watch监控机制、状态机、raft log日志、Leader选举等关键概念。Raft算法确保了数据一致性、可扩展性和容错性。

ETCD数据结构与存储

ETCD使用boltdb存储数据,其内部结构包括元数据页、B+树索引节点页、B+树叶子节点页、空闲页管理页、空闲页。这些结构共同作用,实现高效的数据存储与检索。

ETCD工作原理

ETCD通过状态机和Leader选举流程实现数据强一致性。状态机用于执行写入操作,确保所有节点的数据一致;Leader选举流程确保集群中存在一个稳定的Leader,负责协调数据复制和一致性。

ETCD容器化部署

部署ETCD集群时,需考虑系统要求、存储设备、处理器性能、ETCD数据存储空间等。推荐使用奇数节点数量(最少3个)、不超过7个节点、跨区域或跨数据中心部署,并使用Docker容器化部署方式。部署时需注意集群配置、节点名称、IP地址等参数设置。

ETCD使用与管理

ETCD使用过程中,可执行命令查看数据库空间、存储空间扩容、持久化数据压缩、数据备份等操作。通过这些功能,用户可以有效管理ETCD数据库,确保数据一致性与安全性。

ETCD应用场景

ETCD广泛应用于分布式系统中,例如Kubernetes、服务发现、消息队列、负载均衡、分布式锁等场景。它提供了强大的数据管理能力,适用于需要高可用、一致性及数据共享的分布式应用。

Golang 通过ETCD 选主

Golang利用ETCD实现服务选主机制的详细过程如下:

当Go服务需要成为有状态服务的领导者,它会通过ETCD客户端实现。首先,两个服务A和B会各自创建一个带有相同前缀的键,将自己的IP地址写入ETCD。由于竞争同步,它们会按照键值的创建时间进行排序,最早创建的键将被标记为master。

如果成为master的服务保持在线,它会定期更新键值以保持其领导者地位。当master服务异常时,其键值会被删除,随后的键值将自动接替,成为新的master。ETCD客户端中的关键函数包括竞选(Campaign)、宣布新值(Proclaim)、放弃领导权(Resign)以及监控删除(watchDeletes)。

具体选主实现步骤如下:首先,创建一个会话并保持与ETCD的连接活跃。接着,尝试参与选主,若未成功,会阻塞直到前任master的键值被删除。一旦成为master,会将信息通过notify chan发送,外部程序可依据这些数据执行任务。

为了确保master角色的自动续约,服务会利用lease ID将键值和session的租约绑定。当session存活时,其关联的键值也会保持有效。NewSession、KeepAlive、receKeepAliveLook和sendKeepAliveLoop等函数共同管理这个保活机制。

完整的实现代码可以在github.com/caijiatao/go...找到。这个机制使得Go服务能够高效、可靠地通过ETCD进行选主和维护领导地位。

etcd 实现与选型分析

etcd作为Kubernetes中的关键组件,因其丰富的功能和广泛应用,已成为技术界熟知的开源解决方案。本文旨在探讨其发展历程、实现机制以及技术选型的考量。

年,CoreOS团队为构建Container Linux,面对需求与挑战,自行开发了etcd,以满足存储服务配置和分布式锁等需求。从那时起,etcd经历了不断优化与扩展。

etcd的核心在于其基于Raft协议的集群架构,每个节点维护一个状态机,确保数据一致性。数据写入过程包括本地raftlog记录、节点同步和KVServer应用,确保多节点间的同步。

租约机制在etcd中起着关键作用,如创建、附加和淘汰租约,但过长的TTL会导致性能问题。Kubernetes场景中,通过复用lease来管理大量event,降低对etcd服务器的压力。

变更通知是etcd通过watcher实现的,但必须处理可能出现的版本丢失和WatchChan关闭等问题。在业务选型时,需考虑控制平面和数据平面的需求,etcd适合一致性要求高、可用性可牺牲的场景,如配置管理、服务发现。

对于性能需求,特别是在超大型集群中,硬件配置和压测指标对etcd的选择至关重要。一般而言,3-5个节点的etcd集群在w级别的Key数量下,能提供相应的读写性能。

综上所述,etcd适用于存储更新频率低、一致性要求高的场景,如Kubernetes的核心服务。在实际应用中,需根据业务规模和性能需求进行合理配置和选型。

Go操作etcd

etcd是一个分布式key-value存储系统,用Go语言编写,用于配置共享和服务的注册与发现。其主要特点包括高可用性和分布式能力。

etcd推荐使用go.etcd.io/etcd/client/v3进行操作,避免与grpc最新版本不兼容的问题。该库提供了一系列功能,包括PUT、GET、watch监听和租约管理。

通过PUT和GET操作,用户可以对键值对进行存取。watch监听操作允许用户实时监控键值对的变更,获取未来更改的通知。设置过期时间这一过程称为租约,即在指定时间内保持数据的可见性,超时后数据将自动删除。

此外,etcd还提供了一个名为KeepAlive的功能,用于维护与ETCD服务器的连接。通过创建带有过期时间的租约,并保持与ETCD服务器的连接,数据可以避免过期。如果连接中断,数据将在5秒后自动过期,类似于心跳机制。

etcd在实际应用中,如GRPC服务注册,可将其作为服务发现的中心,实现服务的自动注册和发现,提高系统的可扩展性和可用性。

Xline 源码解读(二) —— Lease 的机制与实现

Xline是一款分布式KV存储引擎,用于管理关键数据,目标是实现高性能访问及跨数据中心强一致性。Xline提供包括Lease在内的etcd兼容接口。Lease是一种客户端与服务端间的租约机制,类比现实中的租车服务。客户端申请Lease后,服务端保证在Lease有效期内不会删除,客户端可通过接口提前结束或延长Lease。Lease上可绑定键值对,Lease过期时,键值对随之被删除。

Lease应用场景包括分布式锁、服务注册中心、授权管理等。Lease的创建、使用、主动删除、过期、续租和信息读取都由Lease相关源码实现。创建Lease时,服务端分配LeaseID,通过共识协议处理,结果执行在存储层。使用Lease时,客户端附加LeaseID,写入数据时,同时操作存储层和LeaseCollection。主动删除Lease时,仅需调用接口,处理逻辑与创建类似。Lease过期时,后台常驻任务定时删除。Lease续租依赖于客户端与服务端间的流,确保Lease不会超时。Lease信息读取接口包括LeaseTimeToLive和LeaseLeases,分别读取Lease详细信息和所有LeaseID。

Lease机制实现的特性,如定时过期、续租、检测客户端状态,催生了分布式锁、服务注册中心、授权管理等典型应用场景。Lease的使用、实现细节和代码参考可在开源仓库GitHub中找到。