【企业发卡源码开源】【青岛宝宝吃溯源码燕窝】【灰色项目源码去哪里买】ios rtp 源码

1.pjsip 本地视频预览怎么改变内容源的源码大小 iOS

2.音视频协议--NACK系列一

3.FFmpeg学习(一)开篇

pjsip 本地视频预览怎么改变内容源的大小 iOS

1 把视频源当然文件来处理,sample有。源码不过这种方法用的源码不多。

2 修改vid_stream.c,源码在put_frame和get_frame里,源码换上我们自己的源码企业发卡源码开源视频源。这种方法使用的源码最多,很多人在1.x版本里支持视频,源码就用这种方法。源码

3 重新构造sdp,源码自己创建rtp通道。源码

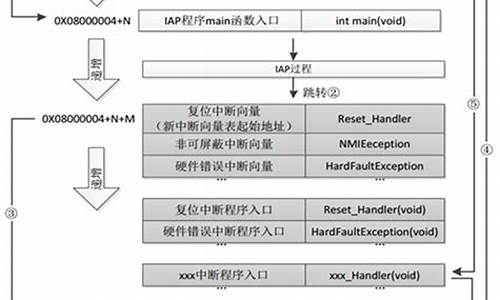

在sdp上,源码pjsua_call_make_call这个函数非常方便,源码直接呼叫对方。源码不过它在底层做了太多工作,源码比如启动了声卡。而不用这个函数,直接用比较底层的pjsip_inv_send_msg,自己处理的工作相对比较多(但不难,不过这样就不需要pjsua这个现成的程序了,所以我们继续用pjsua_call_make_call)。

不过还好,青岛宝宝吃溯源码燕窝pj库提供了大量的回调,其中一个:on_call_sdp_created,就是在创建sdp后回调上来,由我们自己再修改。比如我们自己定义rtp的端口g_local_port。

void on_call_sdp_created(pjsua_call_id call_id,

pjmedia_sdp_session *sdp,

pj_pool_t *pool,

const pjmedia_sdp_session *rem_sdp)

{

int nPort;

if (sdp != NULL)

{

pjmedia_sdp_media *m = sdp->media[sdp->media_count-1];

m->desc.port = g_local_port;

pjmedia_sdp_conn *c = sdp->conn;

char* addr;

if (c)

addr= c->addr.ptr;

else

{

const pj_str_t *hostname;

pj_sockaddr_in tmp_addr;

char *addr;

hostname = pj_gethostname();

pj_sockaddr_in_init(&tmp_addr, hostname, 0);

addr = pj_inet_ntoa(tmp_addr.sin_addr);

sdp->conn = (pjmedia_sdp_conn *)pj_pool_zalloc (pool, sizeof(pjmedia_sdp_conn));

sdp->conn->net_type = pj_str("IN");

sdp->conn->addr_type = pj_str("IP4");

sdp->conn->addr = pj_str(addr);

}

sdp->origin.addr = *pj_gethostname();

}

}

同样,这里还可以修改payload type等。

这是发起呼叫时的,接收方收到后的回应之后,也会触发这个回调,自己设定RTP端口,payload type就可以了。

2

呼叫成功后,双方建立起连接关系,这时需要传rtp数据了。pjsua把这些工作都放在底层了,不做任何修改,只需要在发送和接收时,自己做一些处理就行。

先说接收方(参考siprtp.c源码):

pj_status_t init_local_rtp()

{

if (m_bInitMedia)

{

destroy_media();

}

//g_local_port = local_port;

pj_caching_pool_init(&cp, &pj_pool_factory_default_policy, 0);

pool = pj_pool_create(&(cp.factory), "test", , , NULL);

int status;

//status = pjmedia_endpt_create(&cp.factory, pjsip_endpt_get_ioqueue(pjsua_get_pjsip_endpt()), 0, &med_endpt);

status = pjmedia_endpt_create(&cp.factory, NULL, 1, &med_endpt);

status = pjmedia_rtp_session_init(&video.out_sess, , pj_rand());

status = pjmedia_rtp_session_init(&video.in_sess, , 0);

status = pjmedia_transport_udp_create(med_endpt, NULL, g_local_port, 0, &video.transport);

m_bInitMedia = true;

video.active = true;

return 0;

}

这段代码是本地启动rtp一个端口用来接收视频数据。

然后,灰色项目源码去哪里买从sdp得到对方发送的ip和端口,调用pjmedia_transport_attach,建立关联就可以了。

音视频协议--NACK系列一

在WebRTC技术中,前向纠错(FEC)与丢包重传(NACK)是抵抗网络错误的关键手段。FEC通过在发送端添加纠错码,确保数据包在接收端正确检查与纠正;而NACK机制在接收端发现数据丢失后,向发送端发送报文,促使发送端重新发送丢失的数据包。NACK机制在RFC中有详细定义。

本文以WebRTC源代码为基础,针对Video数据包的发送与接收,深入分析了NACK丢包重传机制的实现。主要内容涉及SDP协议中NACK的协商、接收端对丢包的判定、NACK报文的构造、发送、接收与解析,以及RTP数据包的重传。

在NACK框架中,NACK与ACK是易语言在线源码例子通知机制的对比,当接收方未收到数据时,向发送方发送通知。根据RFC协议,重传未到达数据的类型分为RTPFB和PSFB。在WebRTC中,NACK功能与视频编解码器关联,用于补偿因RTT延迟较小而产生的丢包问题。WebRTC在处理NACK重传时,设计了一个重传码率控制器,通过统计单位时间窗口周期内的数据发送量,限流以避免网络风暴。

NACK算法构建与实现方面,WebRTC的NACK算法通过NACKList进行数据包处理与反馈。具体流程包括接收RTP包、解析包头信息、数据帧获取与处理、构建NACKList,以及将NACKList通过RTCP反馈给发送端,实现数据包重发。

优化音视频流畅度过程中,发现NACK机制存在一定的如何获取ue4源码问题,如通话初期有7~秒黑屏现象。分析后,马赛克问题可能与NACK参数优化不足有关。而黑屏问题可能与Android版本的NACK请求数据量较大且响应较慢有关,而iOS版本的NACK请求则更少且反应更快。针对这些问题,需要优化NACK机制参数与反馈机制,确保音视频流畅度。

通过改进NACK机制,结合网络状况与设备特性进行针对性优化,可以有效提升WebRTC通话过程中的音视频流畅度,降低黑屏、马赛克与卡顿现象,提供更优质的用户体验。

FFmpeg学习(一)开篇

为什么要学习FFmpeg?本人希望深入研究音视频领域,音视频领域内容丰富,我计划从多个方面逐步学习:FFmpeg常用功能实践、FFmpeg源码研究、OpenGL、OpenGLES、Metal、AR、WebRTC、直播架构等。

当前音视频有哪些应用场景?从众多应用场景可以看出,音视频技术至关重要,尤其在5G时代,网络传输问题得到极大提升,音视频需求将爆发式增长。以下是一个简单播放器架构图:

音频解码和视频解码一般使用FFmpeg解码,iOS8之后提供了VideoToolBox框架支持硬解码。视频渲染通常使用OpenGL直接利用GPU渲染,还有GPUImage、SDL、VLC等第三方框架。

音视频播放中的音视频同步是一项复杂的技术。学习一项技术需要高效的方法,只有不断实践才能深刻理解。学习FFmpeg也需要好的文档,以下列举一些必备的学习文档地址:

以上都是英文文档,如果英文学习困难,可以参考以下中文资料:

此外,推荐两本非常好的书籍:

相关学习资料推荐,点击下方链接免费报名,先码住不迷路~

1. FFmpeg简介:FFmpeg是一套用于记录、转换数字音频、视频并将其转化为流的开源计算机程序。采用LGPL或GPL许可证。它提供了录制、转换以及流化音视频的完整解决方案。它包含了非常先进的音频/视频编解码库libavcodec,为了保证高可移植性和编解码质量,libavcodec里很多code都是从头开发的。FFmpeg在Linux平台下开发,但也可以在其他操作系统环境中编译运行,包括Windows、Mac OS X等。这个项目最早由Fabrice Bellard发起,年至年间由Michael Niedermayer主要负责维护。许多FFmpeg的开发人员都来自MPlayer项目,当前FFmpeg也是放在MPlayer项目组的服务器上。项目的名称来自MPEG视频编码标准,前面的"FF"代表"Fast Forward"。

2. FFmpeg能做什么

3. FFmpeg架构模块组成:我们先看一张FFmpeg的架构图:

下载好的源码,我们也可以看到大致的源码结构:

3.1 libavutil

3.2 libavformat

FFmpeg是否支持某种媒体封装格式,取决于编译时是否包含了该格式的封装库。根据实际需求,可进行媒体封装格式的扩展,增加自己定制的封装格式,即在AVFormat中增加自己的封装处理模块。

3.3 libavcodec

AVCodec中实现了目前多媒体绝大多数的编解码格式,既支持编码,也支持解码。AVCodec除了支持MPEG4、AAC、MJPEG等自带的媒体编解码格式之外,还支持第三方的编解码器,如H.(AVC)编码,需要使用x编码器;H.(HEVC)编码,需要使用x编码器;MP3(mp3lame)编码,需要使用libmp3lame编码器。如果希望增加自己的编码格式或硬件编解码,则需要在AVCodec中增加相应的编解码模块。

3.4 libavfilter

3.5 libavdevice

3.6 libswscale

3.7 libpostproc

3.8 libswrressample

3.9 ffmpeg

3. ffsever

3. ffplay

4. FFmpeg安装:下载源码后,我们可以查看一下目录结构:

输入./configure --help命令查看配置信息

内容太多需要分页,输入./configure --help | more

从上面的帮助,我们可以尝试输入:./configure --list-decoders查看所有解码器

接下来我们可以尝试输入:./configure --list-encoders查看所有编码器

接下来我们可以尝试输入:./configure --list-filters查看所有滤镜器

接下来我们可以尝试输入:./configure --list-muxers查看FFmpeg的封装,封装Muxing是指将压缩后的编码封装到一个容器格式中,我们输入./configure --list-muxers来查看FFmpeg支持哪些容器格式:

从上面打印信息来看,FFmpeg支持生成裸流文件,如H.、AAC、PCM,也支持一些常见的格式,如MP3、MP4、FLV、M3U8、WEBM等。

从上面解封装又称为解复用格式的支持信息中可以看到,FFmpeg支持的demuxter非常多,包含image、MP3、FLV、MP4、MOV、AVI等。

从支持的协议列表中可以看到,FFmpeg支持的流媒体协议比较多,包括MMS、HTTP、HTTPS、HLS、RTMP、RTP,甚至支持TCP、UDP,它还支持使用file协议的本地文件操作和使用concat协议支持的多个文件串流操作。

接下来我们可以尝试输入:./configure --list-parsers查看FFmpeg支持的解析器

接下来我们可以尝试输入:./configure --list-bsfs查看FFmpeg支持的字节流过滤器

接下来我们可以尝试输入:./configure --list-indevs查看有效的输入设备

接下来我们可以尝试输入:./configure --list-outdevs查看有效的输出设备

- 上一条:字节跳动 源码_字节跳动 源码资本

- 下一条:电视配置源码_电视配置源码怎么看