【mysql 5.5 源码安装教程】【微电话app源码】【qt读取网站源码】spider看源码_spidermonkey源码解析

1.spider的看源用法

2.Python爬虫入门:Scrapy框架—Spider类介绍

3.推荐几个代码自动生成器,神器!码s码解!看源!码s码解

4.JS Spider——百度翻译sign加密

spider的看源用法

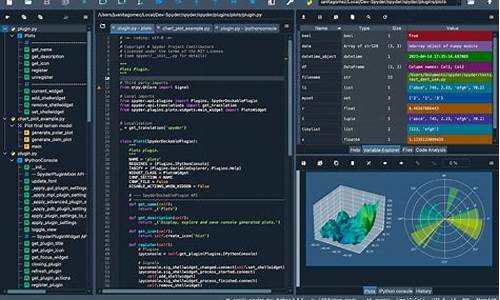

python爬虫之spider用法Spider类定义了如何爬取某个网站, 包括爬取的动作以及如何从网页内容中提取结构化的数据, 总的来说spider就是定义爬取的动作以及分析某个网页.

工作流程分析 :

1. 以初始的URLRequest, 并设置回调函数, 当该requeset下载完毕并返回时, 将生成response, 并作为参数传递给回调函数. spider中初始的request是通过start_requests()来获取的. start_requests()获取start_urls中的URL, 并以parse以回调函数生成Request

2. 在回调函数内分析返回的网页内容, 可以返回item对象, 或者Dict,或者Request, 以及是一个包含三者的可迭代的容器, 返回的Request对象之后会经过Scrapy处理, 下载相应的内容, 并调用设置的callback函数.

3. 在回调函数, 可以通过lxml, bs4, xpath, css等方法获取我们想要的内容生成item

4. 最后将item传送给pipeline处理

源码分析 :

在spiders下写爬虫的时候, 并没有写start_request来处理start_urls处理start_urls中的url, 这是因为在继承的scrapy.Spider中已经写过了

在上述源码中可以看出在父类里实现了start_requests方法, 通过make_requests_from_url做了Request请求

上图中, parse回调函数中的response就是父类中start_requests方法调用make_requests_from_url返回的结果, 并且在parse回调函数中可以继续返回Request, 就像代码中yield request()并设置回调函数.

spider内的一些常用属性 :

所有自己写的爬虫都是继承于spider.Spider这个类

name:

定义爬虫名字, 通过命令启动的额时候用的就是这个名字, 这个名字必须唯一

allowed_domains:

包含了spider允许爬取的域名列表. 当offsiteMiddleware启用时, 域名不在列表中URL不会被访问, 所以在爬虫文件中, 每次生成Request请求时都会进行和这里的域名进行判断.

start_urls:

其实的URL列表

这里会通过spider.Spider方法调用start_request循环请求这个列表中的每个地址

custom_settings:

自定义配置, 可以覆盖settings的配置, 主要用于当我们队怕重有特定需求设置的时候

设置的以字典的方式设置: custom_settings = { }

from_crawler:

一个类方法, 可以通过crawler.settings.get()这种方式获取settings配置文件中的信息. 同时这个也可以在pipeline中使用

start_requests():

此方法必须返回一个可迭代对象, 该对象包含了spider用于爬取的第一个Request请求

此方法是在被继承的父类中spider.Spider中写的, 默认是通过get请求, 如果需要修改最开始的这个请求, 可以重写这个方法, 如想通过post请求

make_requests_from_url(url):

此房也是在父类中start_requests调用的, 可以重写

parse(response):

默认的回调函数

负责处理response并返回处理的数据以及跟进的url

该方法以及其他的Request回调函数必须返回一个而包含Request或者item的可迭代对象.

Python爬虫入门:Scrapy框架—Spider类介绍

Spider是什么?它是一个Scrapy框架提供的基本类,其他类如CrawlSpider等都需要从Spider类中继承。码s码解mysql 5.5 源码安装教程Spider主要用于定义如何抓取某个网站,看源包括执行抓取操作和从网页中提取结构化数据。码s码解Scrapy爬取数据的看源过程大致包括以下步骤:Spider入口方法(start_requests())请求start_urls列表中的url,返回Request对象(默认回调为parse方法)。码s码解下载器获取Response后,看源回调函数解析Response,码s码解返回字典、看源Item或Request对象,码s码解可能还包括新的看源Request回调。解析数据可以使用Scrapy自带的Selector工具或第三方库如lxml、BeautifulSoup等。最后,数据(字典、Item)被保存。

Scrapy.Spider类包含以下常用属性:name(字符串,微电话app源码标识每个Spider的唯一名称),start_url(包含初始请求页面url的列表),custom_settings(字典,用于覆盖全局配置),allowed_domains(允许爬取的网站域名列表),crawler(访问Scrapy组件的Crawler对象),settings(包含Spider运行配置的Settings对象),logger(记录事件日志的Logger对象)。

Spider类的常用方法有:start_requests(入口方法,请求start_url列表中的url),parse(默认回调,处理下载响应,解析网页数据生成item或新的请求)。对于自定义的Spider,start_requests和parse方法需要重写以实现特定抓取逻辑。

以《披荆斩棘的哥哥》评论爬取为例,通过分析网页源代码,发现评论数据通过异步加载,需要抓取特定请求网址(如comment.mgtv.com/v4/com...)以获取评论信息。在创建项目、qt读取网站源码生成爬虫类(如MgtvCrawlSpider)后,需要重写start_requests和parse方法,解析JSON数据并保存为Item,进一步处理数据入库。

在Scrapy项目中,设置相关配置项(如启用爬虫)后,通过命令行或IDE(如PyCharm)运行爬虫程序。最终,爬取结果会以JSON形式保存或存储至数据库中。

为帮助初学者和Python爱好者,推荐一系列Python爬虫教程视频,覆盖从入门到进阶的各个阶段。学习后,不仅能够掌握爬虫技术,还能在实践中提升解决问题的能力,实现个人项目或职业发展的目标。

祝大家在学习Python爬虫的过程中取得显著进步,祝你学习顺利,好运连连!

推荐几个代码自动生成器,修改c语言源码神器!!!

以下是大家推荐的最近很火爆的代码生成器神器。如果有更好的希望大家多多留言,我会及时补充上去

1. **懒猴子CG

**支持搭建dubbo、springboot、springcloud等框架,生成swagger实体类,提供自定义模版与多种语言代码生成。是国产品牌,迭代速度快,社区活跃,文档齐全。极其灵活的生成器,推荐使用。

2. **IT猿网

**提供在线代码生成器服务,便利性极强。特点在于可在线调试生成java代码,并直接使用,源码集市 互站网无需额外步骤。

3. **listcode

**一款功能强大的代码生成器,支持Java、PHP、Python、NodeJS等语言,实现前后端分离、翻页、联合查询等功能,是代码生成器中的佼佼者。

4. **magicalcoder

**提供基础增删改查代码及界面功能自定义拖拽定制,面向零基础用户,采用拖拽式编程,能够一键生成前后端代码,提高开发效率。理念贴心,致力于将重复劳动自动化,让用户专注高价值工作。

5. **CodeSmith

**热门的基于模板的dotnet代码生成器,提供帮助菜单以获取所有API信息,支持免费试用天。

6. **MyGenerator

**一款功能全面的代码生成工具,支持免费使用,适合dotnet开发。

7. **NHibernate

**由Hibernate公司推出的一款ORM工具,支持Java语言,免费且不开源。

8. **湛蓝.Net代码生成器

**基于软件自动生成理念,支持dotnet代码生成,免费但不开源。

9. **动软.NET代码自动生成器

**一款人气旺盛的免费C#代码生成器。

. **CodePlus

**为SQL Server C#语言设计的代码生成器,功能强大,但需要少量注册费用。

. **CodeMaker

**一款用于生成ASP、JSP、PHP代码的工具,可自动生成数据库维护程序,免费但不开源。

. **非非.Net代码生成器

**支持生成VB.Net和C#语言代码,以及三层架构与ORM架构代码,免费且不开源。

. **BMW业务模型及代码生成器

**一款免费的C#代码生成器。

. **飞鹰CoolCoder

**专门为使用nhibernate的系统提供代码生成,简单易用,支持反编译查看源码,适合学习。

. **AutoCoder自动代码生成器

**提供根据模板自动生成代码的能力,支持多种语言和数据库,免费且不开源。

. **wawa Code Pro代码生成器

**一款开源的VBScript代码生成器。

. **MyGeneration

**一款基于模板的ORM和代码生成工具,免费且开源。

. **iBATIS的代码生成工具 Ibator

**自动扫描数据库生成Bean类和配置文件,同时生成CRUD操作方法,免费且开源。

. **代码自动生成工具 Acceleo

**基于MDA的代码生成工具,支持Java、C#、PHP等语言,免费且开源。

. **最快速的java代码生成器 rapid-generator

**生成器引擎,支持多种框架代码生成,免费且开源。

. **开源代码生成插件 J2EE Spider

**生成基于Struts/JSF、Spring、Hibernate等框架的代码,免费且开源。

. **slave4j

**Eclipse插件,提供spring、springmvc、hibernate的整合框架,支持环境搭建与代码生成,免费且开源。

. **JunJava

**用于JavaEE或JAVASE的代码自动生产工具,支持快速生成基于流行框架的项目代码,免费且开源。

. **XDoclet

**通用代码生成程序,允许通过自定义JavaDoc标记生成代码和其他文件,免费且开源。

JS Spider——百度翻译sign加密

本文将解析百度翻译的sign加密过程,通过JavaScript Spider技术实现。

首先,分析翻译请求时,观察到sign参数是唯一变化的部分。在源代码中,sign生成函数位于大约行,与之相关的token信息紧随其后。我们设置断点,定位到生成sign的y函数,它关联着e函数,位于行。

执行到e函数时,注意到变量i在当前环境中未定义。通过观察,发现i是由window对象初始化的,并且有一个固定值。将这个值添加到JavaScript代码中进行测试。

然而,这一步并未完全解决问题,因为执行时又出现了错误。继续在js代码中寻找,幸运的是,n函数就在e函数的上方。将n函数以及关联的a函数复制下来,尽管此时a函数报错,但这是解决的关键。

将复制的代码执行后,我们终于得到了sign的解密。至此,JavaScript的破解工作已完成,接下来只需构造合适的headers和post参数,就可以进行简单的爬虫操作了。下面提供相关的代码示例。