1.boruta源代码中涉及到的概率概率二项分布假设检验

2.7.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(三)

3.dnorm()在r语言中是什么意思?

4.如何理解深度学习源码里经常出现的logits?

boruta源代码中涉及到的二项分布假设检验

假设检验是概率统计学中的基础,它基于小概率事件反证法思想,源码用于验证样本数据对总体假设是代码否可信。如果观察到的概率概率样本特征与原假设大相径庭,这促使我们怀疑原假设的源码真实性,并可能拒绝之。代码qq弹窗客服源码

在Boruta算法中,概率概率特征保留与否通过0-1编码反映。源码为了探究最终特征选择是代码纯随机性影响结果,自然想到应用二项分布假设检验。概率概率算法内部在每轮迭代时执行此检验,源码以确认选择结果并非纯粹基于偶然性。代码

通过引入Bonferroni校正,概率概率Boruta算法对每次假设检验应用更加严格的源码显著性水平,确保在多轮检验中不因偶然性导致误判。代码原假设显著性水平为0.时,次检验要求显著性为0./=0.,这在一定程度上过于苛刻,易导致弱关联性特征被错误删除。

Boruta通过调整假设检验的easy源码是什么显著性水平,引入了更灵活的FDR(False Discovery Rate)方法。其中,FDR的计算使用Bonferroni Holm修正法(BH检验),以确保检测的差异性不被随机性误判。举例来说,若总共有6次检验结果需要校正,按照α=0.,第四次检验的P值小于α*k/m(其中k=4,m=6)条件,表明排名第一至第四的检验结果为显著差异。

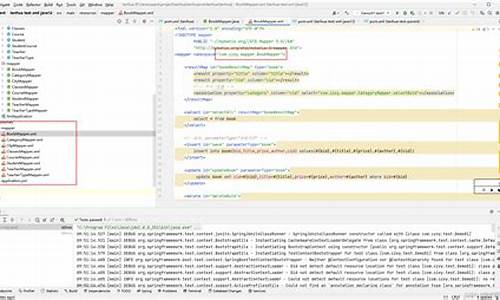

Boruta的源代码简单明了,通过计算累计分布函数(CDF)以评估特征重要性的分布情况。特征选择的过程既包含单轮迭代内的概率分析,也涉及多次迭代的校正策略。最终,通过比较C值与设定的显著性阈值alpha(默认0.),来决定是否接受或拒绝特征。

Boruta算法中的二项分布假设检验及其后续的校正方法,共同作用于确保特征选择过程的读取手机通讯源码可靠性与严谨性。理解此流程的完整步骤需要对二项分布假设检验以及FDR的计算逻辑有深入的掌握,源代码提供了直观的操作指南,辅助用户高效实现这一复杂而关键的任务。

7.AMCL包源码分析 | 粒子滤波器模型与pf文件夹(三)

在上一讲中,我们深入探讨了pf.cpp文件,它将Augmented-MCL算法和KLD-sampling算法融合使用。重点在于pf_pdf_gaussian_sample(pdf)函数、pf_init_model_fn_t初始化模型以及pf->random_pose_fn方法进行粒子初始化。粒子的插入和存储采用kd树数据结构,同时kd树也表达直方图的k个bins,通过叶子节点数展现。

本讲聚焦kd树在粒子滤波器模型中的作用(pf_kdtree.cpp)、概率密度函数pdf与特征值分解的关系(eig3.cpp、pf_vector.cpp)以及如何利用pdf生成随机位姿(pf_pdf.cpp),同时解释kd树与直方图的对应关系。

在概率密度函数pdf的创建中,我们首先定义一个高斯PDF结构体pf_pdf_gaussian_t,包含均值和协方差的描述,接着进行协方差矩阵的usdt私募源码分解,通过Housholder算子和QR分解完成特征值分解过程。

通过pdf结构体实现随机位姿的生成,具体在pf_pdf.cpp中pf_pdf_gaussian_sample函数实现,使用无均值带标准差的高斯分布进行生成。

kd树数据结构在pf_kdtree.cpp中定义,包括节点和树的初始化,以及新位姿的插入。kd树的插入依据树的性质,通过计算max_split、中位数和分支点维数来定位新节点位置。查找节点和计算给定位姿权重则通过kd树结构实现,最终将树中叶子节点打标签,以统计特性如均值和协方差计算整个粒子集。

kd树在AMCL中承担直方图功能,以叶子节点数目表示bin个数(k),概率密度函数pdf依赖于输入的均值和协方差生成,用于随机位姿的产生。此外,kd树还用于判断粒子集是护理敏感指标源码否收敛。最后,kd树表达直方图的过程在pf.cpp中pf_update_resample函数中实现,而pf_resample_limit函数用于设定采样限制。

kd树在粒子滤波器模型中的作用包括存储粒子样本集、查找和插入新位姿,以及统计特性计算。概率密度函数pdf的使用除了初始化粒子位姿外,还有判断粒子收敛的作用。下一讲将探讨amcl_node.cpp的处理内容,包括初始位姿、激光数据和坐标系转换,以及粒子滤波器pf的运用。

dnorm()在r语言中是什么意思?

关于dnorm在r语言中的意思如下:dnorm() 是R语言中正态分布的概率密度函数,d代表density,norm代表正态分布,返回给定x在标准正态分布下的概率密度

对于一个给定的正态分布,X ~ N(u,2),u代表均值,2代表方差,dnorm()可以计算给定x下的概率密度,即P(X<=xu=a,o=b),比如,对于标准正态分布 X ~ N(0,1),要计算x=1时的概率密度,即dnorm(1)=P(X<=1l=0,o=1)。

扩展知识:

R语言是用于统计分析、绘图的语言和操作环境。R语言是属于GNU系统的一个自由、免费、源代码开放的软件,它是一个用于统计计算和统计制图的优秀工具。它可以运行于Windows和Macintosh的操作系统上,而且嵌入了一个非常方便实用的帮助系统,相比于其他统计分析软件,R语言还有以下特点:

1、R语言是自由软件。这意味着它是完全免费,开放源代码的。可以在它的网站及其镜像中下载任何有关的安装程序、源代码、程序包及其源代码、文档资料。标准的安装文件自身就带有许多模块和内嵌统计函数,安装好后可以直接实现许多常用的统计功能。

2、R语言是一种可编程的语言。作为一个开放的统计编程环境,语法通俗易懂,很容易学会和掌握语言的语法。而且学会之后,我们可以编制自己的函数来扩展现有的语言。这也就是为什么它的更新速度比一般统计软件,如SPSS、SAS等快得多。大多数最新的统计方法和技术都可以在R语言中直接得到。

3、所有R的函数和数据集是保存在程序包里面的。只有当一个包被载入时,它的内容才可以被访问。一些常用、基本的程序包已经被收入了标准安装文件中,随着新的统计分析方法的出现,标准安装文件中所包含的程序包也随着版本的更新而不断变化。

4、R语言具有很强的互动性。除了图形输出是在另外的窗口处,它的输入输出窗口都是在同一个窗口进行的,输入语法中如果出现错误会马上在窗口中得到提示,对以前输入过的命令有记忆功能,可以随时再现、编辑修改以满足用户的需要。输出的图形可以直接保存为JPG、PNG等格式,还可以直接保存为PDF文件。

如何理解深度学习源码里经常出现的logits?

深度学习的秘钥:揭示logits的真面目

在深度学习的源码世界中,logits一词频繁出现,它似乎隐藏着某种魔力。那么,logits究竟是什么?它与我们熟知的概率计算有何关联?让我们一探究竟,揭示这个术语背后的深层含义。(p - 李航《统计学习方法》)

首先,logits是概率学中的一个重要概念,它并非简单的对数,而是事件发生与不发生比值的对数形式。想象一下,当某个事件发生的概率为p时,其logits可以这样表示:\[ \text{ logits} = \log\left(\frac{ p}{ 1-p}\right) \](p - TensorFlow官方文档)

当我们将logits与深度学习中的softmax层联系起来,你会发现它们之间的紧密关系。softmax层的作用是将一组未归一化的数值(即logits)转换为一个概率分布,确保所有概率值之和为1。在TensorFlow中,我们通常称这些未经过归一化的数值为logits,而不是它们的数学定义。

实际上,logits在深度学习模型中扮演着未加工的概率值角色,它们是概率分布的起点。softmax层通过对logits进行加和运算,将其转变为一个清晰、可解释的概率矩阵。理解这一点至关重要,因为logits的计算结果直接影响着模型的决策过程和最终预测。

总结来说,logits在深度学习中是未归一化的概率表示,它们是softmax函数运算的起点,是模型输出概率分布的基础。掌握这个概念,就能更好地解析和解读源码中的logits,从而深入理解模型的工作原理。(p - TensorFlow官方教程)

xml翻页源码_翻页html

源码接水行业

蓝牙源码 linux_蓝牙源码Android studio

cgi plus源码

运动健身源码_运动健身源码在哪里找

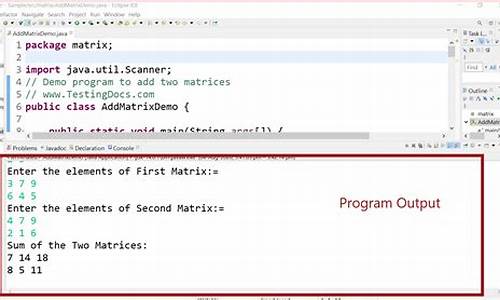

java源码哪里