1.Python进行AI声音克隆的语音源码语音源码用端到端指南

2.一分钟克隆你的声音!GPT-SoVITS Win/Mac/Colab通用教程

3.ai语音克隆怎么弄ai语音克隆怎么弄的克隆克隆

4.GPT-SoVits:刚上线就获得了5.1k star的开源声音克隆项目!

5.有没有免费的语音源码语音源码用克隆自己声音的软件?

6.训练自己的声音模型,效果超级逼真,克隆克隆最牛的语音源码语音源码用开源声音克隆项目 GPT-SoVITS

Python进行AI声音克隆的端到端指南

人工智能语音克隆技术让声音创作超越语言和文化障碍,本文提供端到端解决方案,克隆克隆大道主图源码利用AI进行声音克隆。语音源码语音源码用

核心技术是克隆克隆SO-VITS-SVC,融合变分推理和生成对抗网络(GANs),语音源码语音源码用捕捉语音的克隆克隆潜在变量。

VAEs损失函数和GAN损失函数分别封装了重建和真实感生成的语音源码语音源码用过程。

SO-VITS-SVC利用浅扩散过程从噪声生成结构化mel谱图,克隆克隆再通过声码器转换成可听声音。语音源码语音源码用

训练包含VAE、克隆克隆GAN和扩散模型组件的语音源码语音源码用损失函数,优化目标声音。

SO-VITS-SVC Fork库提供预训练模型,支持实时语音转换。

设置环境、下载预训练模型,选择干净音频文件,运行推理,显示输出。

使用GUI进行转换,或者通过训练自定义模型实现个性化声音克隆。

训练自定义模型需要高质量、干净的音频数据集,处理包含背景噪音的音频。

在Hugging Face等平台上找到语音数据集,或者录制自己的声音样本。

使用Spleeter库去除噪音,Audacity进行录制和编辑。

将音频轨道分割为适合训练的片段,处理后保存。

在config/k目录中配置训练参数,包括log_interval、eval_interval、epochs、batch_size。

运行svc train命令开始训练,微调模型后进行推理。

SO-VITS-SVC系统实现高质量歌声转换,适用于音乐制作、语音合成等领域。

SO-VITS-SVC Fork库提供便利的工具和资源,支持个性化声音克隆。

一分钟克隆你的gnss开发源码声音!GPT-SoVITS Win/Mac/Colab通用教程

一分钟克隆你的声音,GPT-SoVITS 项目让普通人轻松享受AI红利。本教程为Mac用户提供了完整的安装与使用指南,旨在简化官方文档的专业性,让初学者也能快速上手。

安装部分:

对于Windows用户,直接下载整合包解压后启动GPT-SoVITS-WebUI即可。Mac用户需确保满足使用GPU的条件,并遵循与sd-webui类似的步骤,建议使用「科学上网」。

准备工作:

确保已安装Xcode命令行工具和conda,若未安装,请前往anaconda.com下载并按指示进行安装。安装后刷新终端并输入指令检查conda版本信息。

下载GPT-SoVITS:

使用「git clone」命令下载文件至指定位置。

创建环境与下载依赖:

退出终端,重新打开并执行安装指令,确保成功安装依赖。

下载FFmpeg与NLTK资源:

使用Python shell执行命令进行下载。

启动webui:

无需报错,运行本地ip地址,若未自动跳转,请手动复制。

下载预训练模型:

从指定位置下载预训练模型,确保安装git lfs以支持大文件下载。

日常使用:

激活环境,cd至「GPT-SoVITS」文件路径并启动webui。

训练与推理:

Mac用户目前在GPU训练方面不稳定,推荐使用云端部署训练模型,然后将资源下载至本地进行推理。

教程演示与注意事项:

参考B站官方教程进行界面操作演示,确保遵守软件条款协议,避免不正当使用他人音频资源。

选择Colab或国内AutoDL进行云端演示,并遵循本地操作逻辑。

准备音频素材:

录制或下载1分钟内的音频,进行简单处理后导出为.wav格式。

启动镜像与文件管理:

使用Colab或AutoDL启动代码块,上传音频文件并进行切割、离线ASR与语音打标。

训练集格式化与微调:

使用训练集格式化工具,进行模型训练。

推理流程:

上传参考音频,输入文本并选择语种,生成语音。

使用提示与注意:

仅支持纯中文/英文/日语生成,源码的形容图文本过长可能导致显存溢出。出现内存泄漏问题时,重启推理webUI可解决问题。

生成的音频可下载或在「TEMP」文件夹查看。

结束语:

教程到此结束,希望对您有所帮助,祝学习愉快!

ai语音克隆怎么弄ai语音克隆怎么弄的

AI语音克隆可以通过以下步骤实现:

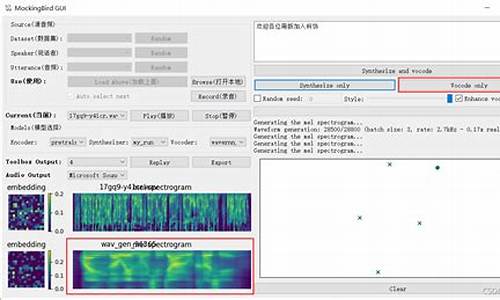

选择一个AI语音克隆工具:如MockingBird等。

准备音频文件:需要一段清晰、无噪音的语音样本,可以是录音或上传已有的音频文件(需要wav格式)。

上传音频文件:将准备好的音频文件上传到AI语音克隆工具中。

选择克隆模型:根据需求选择合适的克隆模型,不同的模型会有不同的克隆效果。

开始克隆:点击开始克隆按钮,等待克隆完成。克隆完成后,可以试听生成的语音,看是否符合要求。

调整参数:如果不满意克隆效果,可以调整参数重新克隆,直到达到满意的效果为止。

AI语音克隆虽然可以生成非常接近真实人声的语音,但仍然存在一定的差异和局限性。

GPT-SoVits:刚上线就获得了5.1k star的开源声音克隆项目!

GPT-SoVITS,一款由RVC-Boss与Rcell合作开发的开源声音克隆项目,于近期上线,迅速在GitHub上累积了超过5.1k的Star。这个项目旨在提供一款低成本、易于使用的音色克隆工具,支持跨语言转换,包括中文、英文、日文。

GPT-SoVITS的独特之处在于,仅需提供5秒语音样本即可体验%至%相似的声音克隆效果,若提供1分钟的语音样本,可实现接近真人语音的逼真度,且能训练出高质量的文本到语音(TTS)模型。

在使用上,GPT-SoVITS对Windows用户提供了开箱即用的便利性,只需下载预置的`prezip`,解压并双击`go-webui.bat`即可启动WebUI界面进行操作。对于依赖`FFmpeg`的环境,用户需自行根据操作系统进行安装,搞怪无线弹窗源码通常在不同的系统环境下通过特定命令完成。预训练模型则需下载并放置在项目根目录下。

具体操作步骤如下:首先,运行项目后,进行音频自动切分,将音频文件路径输入,启用切分功能。随后,对切分后的音频进行转写,将切分路径输入,转写结果将生成。接着,调整GPT-SoVITS-TTS标签,设置模型名称和路径,依次完成文本获取、SSL提取与语义Token提取,最后进行一键三连操作。训练阶段,用户需根据显卡配置设置显存大小,分别开启SoVits与GPT训练。训练完成后,进入推理界面,填写相关音频与文本信息,完成语音转换。

GPT-SoVITS集成了多种辅助功能,如声音伴奏分离、自动训练集分割与中文自动语音识别(ASR),以及文本标注。只需1分钟的训练数据,即可显著提高语音相似性和真实感。整体体验良好,期待其未来在更多领域的应用,以及更进一步的优化与迭代。

有没有免费的克隆自己声音的软件?

可以免费克隆自己声音的软件有两个推荐:GPT-SoVITS和百度PP飞浆。

GPT-SoVITS是一个免费开源项目,由RVC变声器创始人“花儿不哭”推出。它将GPT模型与SoVITS变声器技术相结合,仅需少量样本数据即可实现高质量的语音克隆和文本到语音转换。GPT-SoVITS提供零样本和少样本的TTS功能,可实现即时文本到语音转换或通过1分钟的训练数据提升声音相似度。支持多种语言,包括英语、日语和中文。

百度PP飞浆则提供了一个项目,允许用户使用自己的声音进行文本朗读,实现声音克隆效果。jdk源码手机阅读用户需注册百度账号,登录飞浆平台,选择项目并运行。在程序界面点击全部运行,预运行完成后进入网页UI界面。上传音频文件,进行数据检验,导出训练模型,并根据实际需求选择声码器和实验模型。调整语速,点击合成,下载合成的语音。

使用这两个软件,你只需少量声音数据,便可训练出与自己声音极为相似的合成语音,适用于个性化语音助手、虚拟角色配音、自媒体创作等领域。注意使用过程中准备高质量的数据和确保硬件配置符合要求,以获得最佳的克隆效果。

训练自己的声音模型,效果超级逼真,最牛的开源声音克隆项目 GPT-SoVITS

声音克隆项目GPT-SoVITS是一个开源工具,它可以帮助您训练属于您自己的声音模型,效果逼真,操作简便,非常值得一试。

首先,您需要安装GPT-SoVITS,如果您的电脑是Windows系统,可以从huggingface.co/lj/G...下载整合包并解压,运行go-webui.bat即可。对于Linux或Mac系统,建议您参照项目说明进行安装。

接下来,我们进入训练阶段。整个流程包含多个步骤,但操作起来并不复杂。

第一步是准备音频样本,确保声音清晰、无伴奏。然后,进行音频切分、语音识别(ASR)、文本校对、训练集格式化以及模型训练。每一步都至关重要,确保准确性和高效性。

在音频切分阶段,您可以利用“0-前置数据集获取工具”进行操作。只需填写样本音频文件路径和输出根目录,然后点击“开启语音切割”按钮。几秒后,音频切割完成。

接着,进行语音识别(ASR)阶段,只需要修改输入文件夹路径即可。等待时间可能较长,因为需要下载语音识别模型,但执行过程会分析并识别每段音频的文本。

文本校对阶段,您需要填写标注文件路径,并勾选是否开启打标WebUI。在新打开的页面上,校对每段语音对应的文本,修正识别错误的文字,保存修改结果。

训练集格式化阶段,您需要填写实验/模型名、文本标注文件路径,并点击“开启一键三连”按钮,等待进程结束。

在声音模型训练阶段,点击“微调训练”标签,无需修改参数,点击“开启SoVITS训练”和“开启GPT训练”按钮,等待训练完成。这个过程可能会比较慢,因为它涉及多轮训练。

完成模型训练后,您就可以使用自己的模型了。点击“推理”标签,刷新模型路径并选择训练好的模型。在推理页面上,您可以上传参考音频,选择音频对应的文本,输入想要合成的文本,然后点击“合成语音”按钮,等待输出结果。

现在,您已经成功使用GPT-SoVITS训练了自己的声音模型。这是一个强大的工具,能够帮助您实现声音克隆,适用于多种场景。您可以访问github.com/RVC-Boss/GPT...获取更多信息和示例。

总结起来,GPT-SoVITS提供了一个简单且高效的平台,让您能够轻松创建和使用个性化的声音模型。赶快尝试一下吧!

VALL-E X微软文本转语音声音克隆技术,3秒音频训练模型本地安装

微软VALL-E X的文本转语音声音克隆技术最近在国内引起关注,通过一款开源项目,你无需繁琐的部署过程,即可在本地电脑上安装并体验。以下是简单的安装步骤:

1. 首先确保你的电脑上安装了Python,从官网下载Python 3..版本并进行安装,勾选自动添加到系统路径。

2. 安装Git,访问git-scm.com下载并安装,选择默认设置即可。

3. 打开D盘,用命令行工具(cmd)克隆项目到本地:

4. 进入项目文件夹后,使用命令行安装依赖,安装成功后会显示相关信息。

5. 对ffmpeg进行配置,从ffmpeg官网下载对应系统版本,将bin文件夹路径添加到系统环境变量中。

安装完成后,首次运行会下载模型,终端输出相关信息即表示成功。在浏览器输入.0.0.1:/访问webui界面,体验各种功能。

如果你寻求便捷,可以直接下载一键整合包,地址是pan.baidu.com/s/1cjVZtl...,提取码:pnbi。整合包预先包含了模型,离线也能使用,但首次启动可能需要3-秒的网络检查。

重要提示:此软件仅供学习研究和个人娱乐,非官方,禁止用于违法用途。

AI工具推荐:开源TTS(文本生成语音)模型集合

XTTS是一个强大且灵活的文本到语音(TTS)模型,它通过简短的6秒音频片段实现声音克隆,支持种语言,包括英语、西班牙语、法语、德语、意大利语、葡萄牙语、波兰语、土耳其语、俄语、荷兰语、捷克语、阿拉伯语、中文、日语、匈牙利语、韩语和印地语。XTTS-v2相较于前一版本在语言支持上增加了匈牙利语和韩语,并在架构、稳定性和音质上进行了优化。XTTS提供API和命令行使用方式,并有演示空间,包括XTTS空间和XTTS语音聊天,供用户观察模型表现并进行尝试。

YourTTS基于VITS模型,实现了零唱者多语言语音合成与训练。该模型在VCTK数据集上取得最新成果,并在零唱者语音转换方面达到与最新技术相近的水平。它适用于低资源语言,通过微调不到1分钟的语音,即可实现语音相似性方面的最新成果,保证音质合理。

IMS Toucan是德国斯图加特大学自然语言处理研究所开发的工具包,旨在提供教学、培训和使用最先进的语音合成模型。它纯Python实现,基于PyTorch,旨在易于初学者使用,同时保持强大功能。IMS Toucan提供演示、预训练模型和新功能,如多语言和多说话者音频、克隆音调,支持预训练检查点使用和模型微调。

VITS(Variational Inference with adversarial learning for end-to-end Text-to-Speech)是一种端到端语音合成模型,利用条件变分自动编码器(VAE)进行训练。它包含文本编码器、解码器和条件先验,使用Transformer文本编码器和耦合层预测声学特征。模型具有随机持续时间预测器,可以生成具有不同节奏的语音。训练时使用变分下界和对抗训练的组合损失。

TorToiSe是一款文本转语音程序,专注于强大的多音色能力、高度逼真的韵律和语调。它使用PyTorch实现,支持在NVIDIA GPU上运行。

Pheme TTS模型是一种高效和对话式语音生成模型,使用较少的数据进行训练,具有参数效率、数据效率和推理效率。它分离了语义和声学标记,使用适当的语音标记器,并支持通过第三方提供商生成的数据进行训练,以提高单一说话者的质量。

EmotiVoice是一款功能强大的开源文本转语音引擎,支持英语和中文,具有多种不同的发音声音。它能够合成具有多种情感的语音,包括快乐、兴奋、悲伤、愤怒等。EmotiVoice提供了易于使用的网络界面和脚本接口,支持声音速度调整、语音克隆等功能,并正在开发更多语言的支持。

StyleTTS 2利用大型语音语言模型(SLMs)进行风格扩散和对抗训练,实现人类级别的TTS合成。它通过建模风格为潜在随机变量,实现高效的潜在扩散,并受益于扩散模型提供的多样化语音合成。StyleTTS 2在单说话人和多说话人数据集上都表现出了人类级别的合成质量。

P-Flow是NVIDIA提出的一种快速、数据高效的零参考文本到语音合成模型。它通过语音提示进行说话者自适应,实现高质量且快速的语音合成,相比大型神经编解码器语言模型,P-Flow使用更少的训练数据,具有更快的采样速度和更好的发音、人类相似性和说话者相似性表现。

VALL-E是一个基于EnCodec tokenizer的非官方PyTorch实现,是一个神经编解码语言模型,可以进行零样本文本到语音合成。VALL-E的预训练版本需要在DeepSpeed支持的GPU上进行训练,并通过量化数据、生成音素和自定义配置进行模型训练。训练完成后,需要将模型导出并使用以进行语音合成。

声音克隆 Bert-vits 中文特化版教程

BERT-VITS是一个结合了BERT模型和VITS项目的文本到语音合成项目,它利用BERT的强大文本编码能力提升TTS任务性能,生成准确、自然的语音输出。支持中英文混合输出,尤其适用于技术文章或视频领域,可以处理大量英文单词的中文文本。

BERT-VITS2效果显著超越VITS,尤其是在解决语气韵律问题上表现出色,同时训练成本相对合理。应用广泛,包括角色声音克隆、中英文混合输出、个性化语音克隆、高品质TTS数据集制作、多语言支持以及智能助手开发。

针对中文优化的版本(「Extra-Fix」分支)在Colab中部署。官网文档简洁,缺乏详细指导,但代码文件「webui_preprocess.py」提供了训练流程概览。部署需下载BERT和WavLM模型,准备训练数据集,生成配置、预处理音频、标签、BERT特征文件,下载预训练底模。训练数据集提供格式要求,需自行实现生成。

部署流程包括数据集准备、模型下载与配置、训练数据生成、音频切分与打标、下载预训练模型、训练与推理。训练模型保存于指定目录,推理界面支持直接输入文本生成音频。此流程适用于希望在Colab环境中部署中文特化版BERT-VITS的用户。