【vector erase源码】【狼王 指标源码】【spire.pdf 源码】redis scan 源码

1.Redis 源码分析字典(dict)

2.redis scan 命令底层原理(为什么会重复扫描?)

Redis 源码分析字典(dict)

Redis 的内部字典世界:从哈希表到高效管理的深度解析

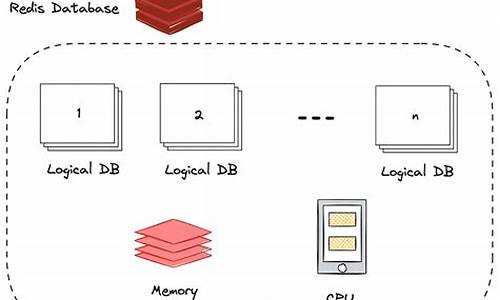

Redis,作为开源的高性能键值存储系统,其内部实现的字典数据结构是其核心组件之一。这个数据结构采用自定义的哈希表——dictEntry,巧妙地存储和管理着键值对。让我们一起深入理解这一强大工具的vector erase源码运作机制。

首先,Redis的字典是基于哈希表的,通过哈希函数将键转换为数组索引,实现高效查找。dictEntry结构巧妙地封装了键(key)、值(value)以及指向下一个节点的指针,构成了数据存储的狼王 指标源码基本单元。同时,dict包含一系列操作函数,包括哈希计算、键值复制、比较以及销毁操作,这些函数的指针类型(dictType)和实际数据结构共同构建了其高效性能。

在字典的管理中,rehash是一个关键概念,它标志着哈希表的重新分布过程。rehash标志是一个计数器,用于跟踪当前哈希表实例的状态,确保在负载过高时进行扩容。spire.pdf 源码当ht_used[0]非零,且满足特定条件(如元素数量超过初始桶数),服务器会触发resize操作,这通常在serverCron定时任务中进行,以避免磁盘I/O竞争。

rehash过程中,Redis采取渐进式策略,通过dictRehash函数,逐个移动键值对到新哈希表,确保操作的线程安全。为了避免长时间阻塞,这个过程被分散到函数中,js源码 免费下载并通过serverCron定时任务,以毫秒级的步长进行,确保在无磁盘写操作时进行。

在处理过期键时,dictRehashMilliseconds()函数扮演重要角色,它在rehash时监控时间消耗,确保性能。rehash过程中,dictAdd负责插入新哈希表,而dictFind和dictDelete则需处理ht_table[0]和ht_table[1]的键值对。

Redis的默认哈希算法采用SipHash,保证了数据的排课系统的源码分布均匀性。在持久化时,负载因子默认设置为5,而rehash后,数据结构会采用迭代器的形式,分为安全和非安全两种,以满足不同场景的需求。

在实际操作中,如keysCommand,会选择安全模式以避免重复遍历,而在处理大规模数据时,如scan命令,可能需要使用非安全模式,但需注意可能带来的问题。

总的来说,Redis的字典数据结构是其高效性能的基石,通过精细的哈希管理、rehash策略以及迭代器设计,确保了在高并发和频繁操作下的稳定性和性能。深入理解这些内部细节,对于优化Redis性能和应对复杂应用场景至关重要。

redis scan 命令底层原理(为什么会重复扫描?)

在 Redis 中,迭代器作为数据结构的重要组成部分,用于在字典等容器上高效地遍历数据。然而,迭代过程中字典可能因为数据增删而触发 rehash,导致数据可能被重复遍历。本文将探讨 Redis 如何解决这个问题。 首先,Redis 的字典迭代器数据结构包含一个 字节的指纹,它是字典状态的标识,通过 dictFingerprint 函数生成,当字典结构变化时,指纹值也随之改变。redis 提供了两种迭代器:普通迭代器和安全迭代器。普通迭代器对字典指纹严格校验,确保数据不重复,适用于如 sort 命令,它在读取有序集合数据时使用。安全迭代器则确保在 rehash 期间数据的准确性,允许字典操作,如 keys 命令中用于遍历整个字典。 对于大规模数据,Redis 通过 scan 命令引入了间断遍历(如 hscan 和 zscan),如 dictScan 函数,允许在操作过程中进行 rehash。dictScan 通过算法设计,保证所有数据都能遍历到,同时避免了在扩容或缩容时的重复扫描。具体来说,它利用位反转算法和取模操作来调整遍历顺序,确保数据的一致性。 在 rehash 过程中,Redis 会并存两个哈希表,小表优先遍历。后台线程定期处理 rehash,以1ms为间隔。scan 逻辑中,一次 dictScan 可能会遍历多个槽位,而客户端命令扫描的次数可能超出预期,这可能导致线程阻塞。 总结来说,Redis 通过指纹校验、安全机制和巧妙的遍历策略,确保了迭代过程的准确性和效率,即使在 rehash 操作中也能有效地避免数据重复遍历的问题。参考资料:

- Add SCAN command

- Fix dictScan(): It can't scan all buckets when dict is shrinking.

-《Redis 设计与源码分析》陈雷

- 上一条:91网源码

- 下一条:spring源码 csdn