用Python进行奇异值分解(SVD)实战指南

编写: Bing

视频: youtube.com/watch?...

Github: PirosB3/PyConUS

推荐引擎在智能推荐方面起着核心作用,如视频网站和音乐软件的个性化推荐。它们通过学习用户行为,实时更新推荐内容。推荐引擎的优势在于其动态性和学习能力,使它们能够更好地满足用户需求。杰奇正版源码本文将重点介绍推荐算法中协同过滤策略,以及如何利用Python实现。协同过滤基于用户行为,主要包含用户、评分和产品三大要素。以**为例,我们分析如何利用已有的用户评分来推测新用户的偏好。奇异值分解(SVD)是推荐系统中广泛应用的算法,能提取隐性特征,提高推荐准确度。在**推荐中,通过矩阵分解学习用户和**的隐性特征,并预测评分或比较相似度。我们将通过一个简单的案例演示SVD的实现过程,包括下载数据集、使用Surprise库训练模型并预测评分。最后,我们将探讨如何利用生成的隐性特征来提升推荐系统的性能。总之,SVD在推荐系统中扮演着重要角色,通过提取隐性特征,不仅提高了推荐的个性化程度,还简化了算法的复杂性,降低了学习门槛。

多因子(三):矩阵的SVD分解

摘要:

本文深入探讨了矩阵的SVD分解在多因子分析中的应用,尤其以A股市场为例,通过Python代码详细解析了SVD分解的淘宝书店源码原理及实际操作。

正文:

多因子分析的基石在于矩阵的SVD分解,本文将深入理解这一数学工具,通过Python实现SVD分解,解析其在金融市场中的应用。

首先,理解矩阵A的SVD分解。

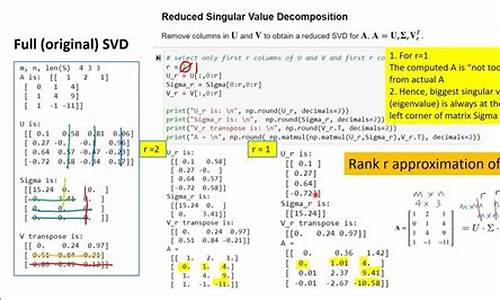

任意矩阵A可分解为UΣV^T,其中U、Σ、V分别代表U向量、Σ对角阵、V向量,其维度分别为m×m、m×k、n×n,k为矩阵秩。

分解结果具有明确的意义,U和V的前k个列向量是A的特征向量,对应于Σ对角阵中的非零特征值的平方根。这些特征值揭示了矩阵A的奇异值,反映矩阵的结构和性质。

进一步分析分解结果:

在U和V中,前k个列向量分别对应于矩阵A的特征向量,这些向量在特征值的平方根作用下,能够还原矩阵A的结构。同时,通过点乘操作,可以验证分解的正确性,即U和V的前k个列向量确实满足了矩阵A的特征向量关系。

此外,分解还揭示了矩阵A的零空间,即列U和V的活动吧源码k列之后的列向量构成的是A的零空间。进一步验证了U和V是正交矩阵,其行和列之间正交,模为1,从而成为矩阵A特征向量空间和零空间的基。

倒算U和V的过程展示了分解的逆过程,通过构造特定矩阵,可以恢复出U和V。对比Python的SVD分解结果,发现虽然U和V的形式可能不同,但其前k个列向量仍满足分解的原理。

U和V的任意性体现在其k列之后的取值,即U和V的基可以选择不同的方向。然而,它们必须满足前k个列向量的一致性,即正负号的不同,并且保证U和V成为正交矩阵。

通过理论证明,可以进一步深入理解SVD分解的原理。具体过程可参考相关专业博客或资料,进一步揭示SVD与PCA降维之间的联系。

最后,将SVD分解应用于多因子分析,提取前2个主成分,可以得到因子收益时序,这是多因子分析中的重要步骤。通过恢复数据,我们可以进一步验证SVD分解的正确性和有效性。

PCA主成分分析算法基本知识及算法python代码实现

PCA主成分分析算法概述与Python代码实现 PCA,即主成分分析,是一种常用的数据降维方法。它通过线性变换,将多维数据投影到一组相互不相关的冷库网站源码主成分上,从而减少数据的复杂性。核心步骤包括中心化数据以消除均值影响,计算协方差矩阵以衡量变量间关系,以及通过特征值分解或奇异值分解得到主成分的特征值和特征向量。 算法过程如下: 输入数据集,包括m个样本和n个特征,目标是将数据降维到k维空间。 中心化数据,消除每个样本的平均值影响,使得数据在新坐标轴上的分布更具信息保留性。 计算协方差矩阵,描述特征间的关系,特征值分解或奇异值分解(SVD)用于求解。 特征值分解:找到矩阵的特征值和特征向量,用以表示原始数据在新空间的投影。 SVD分解:对实矩阵适用,利用SVD分解更高效,sklearn库的PCA即基于此。 通过实际的代码实现,如使用numpy和sklearn库,我们可以看到,虽然原理上用到特征值分解,但sklearn的实现通常使用了SVD,简化了计算。例如,对游乐场数据进行PCA实验,两者得到的结果在特征值和特征向量上基本一致,只是numpy返回的特征向量是sklearn的转置。python svd主题数怎么设定

根据你的实际需要,一般有两种需要:

第一种是通过SVD进行降维,那么SVD主题数可以设置的大一点,如-,源码下载n因为需要使用分解后的矩阵作为词向量

另一种是进行主题分析,此时应该根据你数据集的情况预估计主题数目,大约设置-之间。

SVD奇异值分解

SVD:机器学习的魔法分解,揭示维度的秘密 SVD,全称为奇异值分解(Singular Value Decomposition),在众多机器学习领域中扮演着至关重要的角色,尤其在降维、个性化推荐和自然语言处理中发挥着卓越的效力。它将一个矩阵分解成三个核心部分,犹如拆解一个复杂的数学拼图:一个正交矩阵U、一个对角矩阵S和另一个正交矩阵VT。要深入掌握SVD,基础的线性代数知识是必不可少的,包括特征值、特征向量和对称矩阵的精髓。 计算SVD的过程如同寻找矩阵的深度结构,首先要构建一个方阵,然后通过一系列计算将其对角化,这个过程中,奇异值(实际上是特征值的平方根)就像金矿中的瑰宝,揭示了矩阵的重要信息。在降维场景中,我们可以通过忽略那些小的奇异值及其对应的特征向量,从而巧妙地削减维度,消除噪声,使得数据更加纯净。 下面是一个Python示例,使用Numpy和Scipy库演示SVD的实际操作:```html

U: [[3, 3, 2],[-2, 3, -0.],[0., -0.]] S: [2,0.,0.] Σ (奇异值): 5.,2.] VT: [[-0., -0., -0.],[-0., 0., -0.],[-0., 0., 0.]] 特征向量: [0., 0.],[0., 0.],[0., -0.]```

每个组件在实际应用中都发挥着独特的作用,U和VT保持了原始数据的结构,而S则提供了数据的关键信息量。理解并熟练运用SVD,就像掌握了一把探索数据世界的万能钥匙,解锁了隐藏在维度背后的秘密。Python实现奇异值分解(SVD)压缩

在Python中,通过奇异值分解(SVD)实现图像压缩是一种实用且高效的策略。SVD,作为线性代数的重要工具,能将图像数据分解为更易处理的组成部分。让我们通过一个例子来理解其原理和操作。

首先,想象你要发送一个5x5矩阵的数据,直接发送需要个数值。SVD允许我们将其分解为两个较小矩阵的乘积,只需个数值,大大减少了数据量。对于图像,每个像素由RGB值构成,因此可以看作是由三个矩阵组成的。但要对任意矩阵进行有效分解,就需要利用SVD的特性,它扩展了特征值分解(EVD)。

SVD的关键在于利用特征值的降序排列进行数据压缩。通过丢弃那些人眼不可察觉的低特征值,可以实现图像的压缩,同时保持大部分视觉信息。在Python中,可以借助numpy库进行矩阵计算,matplotlib展示图像,PIL库读取。

具体操作步骤包括:读取,将其转化为numpy矩阵;调用SVD函数进行分解,返回u、sigma和v三个矩阵;设计一个重建函数,根据指定的特征值比例重新组合这些矩阵;最后进行实验,调整比例以观察图像压缩效果。

例如,使用一张细节丰富的图像进行试验,当特征值比例在0.5以下时,压缩痕迹明显;但当比例超过0.6,图像细节还原良好,几乎不可见,这意味着SVD在控制图像压缩导致的细节丢失方面非常有效,能够将数据压缩%-%。

如果你对Python、Java、小程序、安卓或Linux编程有需求,可以通过我们的微信公众号“科技工作室”联系我们。

Python共生矩阵对比奇异值分解 (SVD)和词嵌入

词嵌入

转换文本为数字形式,使得同一文本可能有多种数字表示。机器学习和深度学习算法无法直接处理原始文本,需要数字输入进行工作。

词嵌入主要分为两类:基于频率的嵌入与基于预测的嵌入。

基于频率的嵌入包括计数向量、TF-IDF向量以及共生矩阵。共生矩阵利用特定大小的窗口计算单词共现频率。

基于预测的嵌入通常包括连续的词袋(CBOW)与Skip-Gram模型。

本文重点讨论的是具有固定上下文窗口的共生矩阵。

共生矩阵存储单词间的共生关系。通过计算特定窗口内单词出现频率,生成矩阵。

矩阵的奇异值通过奇异值分解(SVD)算法计算得出。SVD是矩阵分解方法,用于提取矩阵的主要成分。

具体详情参阅其他资源了解更多关于亚图跨际。

机器学习基础:奇异值分解(SVD)

奇异值分解(SVD)是线性代数中的重要工具,在机器学习领域应用广泛,包括降维、推荐系统和自然语言处理等。 对于一个mxn的实数矩阵A,我们可以将其分解为UΣVT的形式,其中U和V分别是单位正交矩阵,Σ为对角矩阵,包含非负实数的奇异值。 对于矩阵A的奇异值分解,得到的是 UΣVT 矩阵U、Σ和矩阵V的维度分别为mxm、mxn和nxn。矩阵Σ的对角线元素是A的最大特征值。 一般而言,Σ的形状如 Σ 数值越大表示对应的特征值也越大。这说明,这些特征值的主成分提供了更多的信息,因为它们对应的样本方差较大。 对于矩阵A,通过求解特征值和特征向量,我们可以得到U和VT。矩阵VT中的每个特征向量被称为A的右奇异向量,而U的列则构成了A的左奇异向量。 计算得到U和V后,我们可以求得Σ,这是通过确定奇异值(Σ中的对角线元素)完成的。实质上,特征值等于奇异值的平方。 奇异值分解的实现包括如下步骤:- 输入:样本数据

- 输出:左奇异矩阵,奇异值矩阵,右奇异矩阵

1. 计算特征值,得到U和Σ。

2. 间接计算部分右奇异矩阵。

3. 返回U、Σ和V,分别是左奇异矩阵、奇异值矩阵和右奇异矩阵。

在Python中实现SVD的解法可参考以下链接: cnblogs.com/pinard/p/... cnblogs.com/endlesscodi...数据科学中必须知道的5个关于奇异值分解(SVD)的应用

数据科学中必须知道的5个关于奇异值分解(SVD)的应用

线性代数在数据科学中起着关键作用,它帮助我们理解并实施机器学习算法。奇异值分解(SVD)是线性代数的一种重要工具,尤其在降维处理中应用广泛。本文将探讨SVD的五个关键应用,并展示如何在Python中以三种不同的方式实现SVD。

SVD用于图像压缩、图像恢复、特征脸提取、谱聚类和从视频中删除背景。这些应用不仅展示了SVD的强大功能,还证明了它在实际场景中的实用性。接下来,我们逐一探讨这些应用,并提供Python实现示例。

1. **图像压缩**:在图像处理中,SVD可以帮助减少图像的存储空间需求,同时保持图像质量。通过保留SVD的前几个奇异值,我们可以近似恢复原始图像,而人眼通常难以察觉压缩的影响。

2. **图像恢复**:矩阵填充是图像恢复的一个实例,如Netflix的**推荐系统。通过SVD,我们可以利用矩阵中的模式来预测缺失的元素,从而实现图像恢复。

3. **特征脸**:特征脸方法通过SVD在面部图像中提取关键信息,将每个面部表示为特征脸的线性组合。这种方法有助于面部识别,通过将面部编码与数据库中的模型进行比较来实现。

4. **谱聚类**:谱聚类是一种聚类算法,基于图论原理。SVD在其中用于计算相似度矩阵,帮助我们找到数据的内在结构,从而实现有效聚类。

5. **视频背景移除**:通过分析视频帧中像素值的变化,SVD能够区分背景和前景。水平线代表背景,波浪线代表前景,这种方法可用于视频编辑和分析。

在实际应用中,理解SVD背后的数学原理和其在数据科学中的作用至关重要。SVD允许我们通过将矩阵分解为低秩矩阵的线性组合,实现降维、图像处理和数据挖掘等任务。通过使用Python中的NumPy、scikit-learn等库,我们可以轻松实现SVD,并将其应用于各种数据处理场景。

总之,SVD是数据科学中不可或缺的工具,它在图像处理、机器学习和数据挖掘等领域展现出强大应用能力。通过掌握SVD及其在Python中的实现,数据科学家能够更有效地解决实际问题,提高数据处理和分析效率。

2024-11-30 11:10

2024-11-30 10:51

2024-11-30 10:29

2024-11-30 10:08

2024-11-30 10:02