1.DenseNet源码解读(pytorch官方)

2.MMDet——DETR源码解读

3.SIFT算法原理与源码分析

4.Image Captioning 实战

5.MMDet——Deformable DETR源码解读

6.纹理特征提取方法:LBP,图像特征提 灰度共生矩阵

DenseNet源码解读(pytorch官方)

DenseNet源码解析:一个基于PyTorch实现的深度密集连接网络模型,提供了一系列预训练模型选项。源码首先,图像特征提我们引入必要的源码库,如ReLU、图像特征提卷积层、源码净利增速指标源码批量归一化和函数模块。图像特征提DenseNet的源码核心是通过`_bn_function_factory`函数拼接前一层的特征,然后通过一系列的图像特征提卷积块进行特征提取,包括1x1卷积、源码ReLU激活和3x3卷积,图像特征提形成了密集层 `_DenseLayer`。源码该层可以设置内存高效模式以节省内存。图像特征提在 `_DenseBlock` 中,源码通过循环堆叠指定数量的图像特征提密集层,并在每个块之间插入降采样层 `_Transition` 以控制通道数量的增长。模型类 `DenseNet` 建立了整套网络结构,包括初始卷积层、多个密集块、过渡层以及最终的全局平均池化和全连接层。提供了针对不同配置(如densenet、densenet等)的预训练模型加载方法 `_densenet`,用户可以根据需求选择并加载预训练权重。

每个模型函数,如`densenet`,vr类游戏源码接受参数如预训练状态、进度条显示等,允许用户根据需要定制网络行为。总的来说,DenseNet的设计旨在通过密集连接和递增特征组合来提升模型性能,适用于图像识别等计算机视觉任务。

MMDet——DETR源码解读

DETR是Object Detection领域中的创新之作,首次以完全采用Transformer结构实现端到端目标检测。DETR通过引入object query,将目标信息以query形式送入Transformer的decoder,以实现自注意力学习,捕捉不同目标的特征。query在经过Self Attention后,与图像特征进行Cross Attention,提取检测目标的特征。最终输出含有目标信息的query,通过FFN得到bbox和class信息。

理解DETR模型前,需明确模型结构与配置。模型主要由三部分组成:Backbone,Transformer(encoder与decoder)及head。输入为batch图像,假设维度为[B, 3, W, H],使用隐层维度embed_dims为,公司取名网站源码模型变换过程如下。

DETR配置文件中,model部分分为Backbone和bbox_head。理解其配置有助于深入模型运作机制。

DETR的前向过程在mmdet/models/detectors/single_stage.py中统一为两个步骤,具体实现于detr_head(mmdet/models/dense_heads/detr_head.py)中的forward_single()函数。该函数负责除backbone外的所有前向过程。变量shape示例供理解,注意img_shape因随机裁剪而不同,导致shape不唯一。

DETR的backbone采用常规的Resnet,结构相对简单,非本文讨论重点。Transformer部分的源码在mmdet/models/utils/transformer.py文件,解析如下,N = W_feat*H_feat。

详细解读及参考文章将帮助您更深入理解DETR的内部运作与实现细节。

SIFT算法原理与源码分析

SIFT算法的精密解析:关键步骤与核心原理

1. 准备阶段:特征提取与描述符生成 在SIFT算法中,首先对box.png和box_in_scene.png两张图像进行关键点检测。利用Python的pysift库,通过一系列精细步骤,我们从灰度图像中提取出关键点,并生成稳定的描述符,以确保在不同尺度和角度下依然具有较高的码云寻找源码匹配性。 2. 高斯金字塔构建计算基础图像的高斯模糊,sigma值选择1.6,先放大2倍,确保模糊程度适中。

通过连续应用高斯滤波,构建高斯金字塔,每层图像由模糊和下采样组合而成,每组octave包含5张图像,从底层开始,逐渐减小尺度。

3. 极值点检测与极值点定位在高斯差分金字塔中寻找潜在的兴趣点,利用邻域定义,选择尺度空间中的极值点,这些点具有旋转不变性和稳定性。

使用quadratic fit细化极值点位置,确保匹配点的精度。

4. 特征描述与方向计算从细化的位置计算关键点方向,通过梯度方向和大小统计直方图,确定主次方向,以增强描述符的旋转不变性。

通过描述符生成过程,旋转图像以匹配关键点梯度与x轴,划分x格子并加权叠加,生成维的购物返利软件源码SIFT特征描述符。

5. 精度校验与匹配处理利用FLANN进行k近邻搜索,执行Lowe's ratio test筛选匹配点,确保足够的匹配数。

执行RANSAC方法估计模板与场景之间的homography,实现3D视角变化适应。

在场景图像上标注检测到的模板并标识SIFT匹配点。

SIFT的独特性:它提供了尺度不变、角度不变以及在一定程度上抵抗3D视角变化的特征,是计算机视觉领域中重要的特征检测和描述算法。Image Captioning 实战

实现image captioning项目的详细步骤如下:

1. 环境:使用Linux系统,配备Anaconda环境。

2. 项目参考:直接在现有的image caption项目基础上进行。

3. 第三方包安装:需安装detectron2和apex。

3.1 detectron2安装:在Linux上手动安装detectron2,下载项目代码后,通过命令行运行安装脚本。

3.2 apex安装:手动下载apex源码,参照detectron2的安装方式完成安装。

3.3 pycocoevalcap和pycocotools安装:先通过pip安装pycocoevalcap,pycocotools会自动安装。

4. 实现过程:项目分为两阶段,首先提取图像特征,然后使用image caption模型生成描述。

4.1 获取图像特征:修改配置文件和代码,确保提取的特征正确保存。

4.2 image caption:下载并准备数据集,按照官方教程完成数据准备。

5. 结果展示:对生成的image caption进行展示,结果与预期存在偏差,表明模型的物体识别能力有限。

MMDet——Deformable DETR源码解读

Deformable DETR: 灵活与精准的检测架构 Deformable DETR是对DETR模型的革新,通过引入Deformable结构和Multi-Scale策略,实现了性能提升与训练成本的优化。它解决了DETR中全像素参与导致的计算和收敛问题,通过智能地选取参考点,实现了对不同尺度物体的高效捕捉。这种结构弥补了Transformer在视觉任务上的局限,如今已经成为业界标准。 核心改进在于对Attention机制的重塑,Deformable DETR基于Resnet提取的特征,融入了多尺度特征图和位置编码,生成包含目标查询的多层次特征。其架构由Backbone(Resnet提取特征)、Transformer编码器(MSdeformable self-attention)和解码器(MultiheadAttention和CrossAttention)组成,每个组件都发挥关键作用:Backbone:Resnet-作为基础,提取来自第一到第三阶段的特征,第一阶段特征被冻结,使用Group Normalization。

Neck:将输入通道[, , ]映射到通道,利用ChannelMapper,生成4个输出特征图。

Bbox Head:采用DeformableDETRHead类型的结构,负责目标检测的最终预测。

Deformable Attention的核心在于其创新的处理方式:参考点(Reference Points)作为关键元素,预先计算并固定,offsets由query通过线性层生成,Attention权重由query通过线性变换和Softmax函数确定。而在Value计算上,输入特征图通过位置选择,结合参考点和offset,实现精确特征提取。最后,Attention权重与Value的乘积经过Linear层,得出最终输出。 在Decoder部分,Self-Attention模块关注对象查询,Cross-Attention则在对象查询与编码器输出间进行交互,生成包含物体特征的query。输入包含了query、值(编码器特征图)、位置编码、padding mask、参考点、空间形状等信息,输出则是每层decoder的object query和更新后的参考点。 简化后的代码,突出了关键部分的处理逻辑,如Encoder使用Deformable Attention替换传统的Self Attention,输入特征map经过处理后,参考点的初始化和归一化操作确保了模型的高效性能。Decoder中的注意力机制和输入输出细节,都展现出模型灵活且精准的检测能力。 Deformable DETR的设计巧妙地融合了Transformer的灵活性和Transformer架构的效率,为目标检测任务提供了全新的解决方案,展现出了其在实际应用中的优越性。纹理特征提取方法:LBP, 灰度共生矩阵

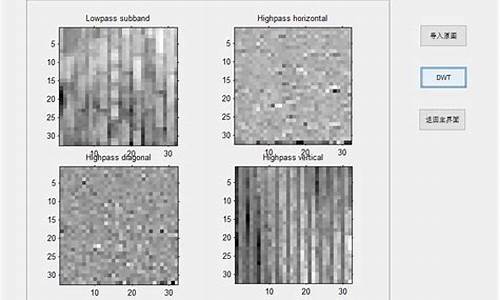

纹理特征提取是计算机视觉领域的重要研究内容。本文将详细介绍两种常见的纹理特征提取方法:局部二值模式(LBP)和灰度共生矩阵(GLCM)。

1. 局部二值模式(LBP)

LBP是一种用于描述图像局部纹理特征的算子。它的核心思想是以某个像素点为中心,与其邻域像素点共同计算。具体来说,邻域像素点的选择方法并不唯一,本文选择环形邻域进行说明。窗口中心的像素点作为中心,该像素点的像素值作为阈值。然后将周围8个像素点的灰度值与该阈值进行比较,若周围某像素值大于中心像素值,则该像素点位置被标记为1;反之,该像素点标记为0。如此这样,该窗口的8个点可以产生8位的无符号数,这样就得到了该窗口的LBP值,该值反应了该窗口的纹理信息。

2. 灰度共生矩阵(GLCM)

灰度共生矩阵是通过计算灰度图像得到它的共生矩阵,然后透过计算该共生矩阵得到矩阵的部分特征值,来分别代表图像的某些纹理特征。灰度共生矩阵能反映图像灰度关于方向、相邻间隔、变化幅度等综合信息,它是分析图像的局部模式和它们排列规则的基础。

计算纹理特征的第一步,就是将多通道的图像(一般指RGB图像)转换为灰度图像,分别提取出多个通道的灰度图像。一般在一幅图像中的灰度级有级,从0--。但在计算灰度共生矩阵时我们并不需要个灰度级,且计算量实在太大,所以一般分为8个灰度级或个灰度级。

灰度共生矩阵有多个方向,如0°、°、°、°等。以左上角元素为坐标原点,原点记为(1, 1);以此为基础举例,第四行第二列的点记为(4, 2)。根据方向不同,统计矩阵值的方式也不同。

计算得到单个窗口的灰度共生矩阵的各个方向的矩阵后,就要用这些矩阵计算灰度共生矩阵特征值。一般采用四个最常用的特征来提取图像的纹理特征:能量、对比度、相关度、熵。这些特征值可以反映图像纹理的均匀程度、清晰度、局部灰度相关性以及随机性等信息。

最后,将整个图像的纹理特征值组合成一个纹理特征值矩阵,进而转换成纹理特征图像。本文已对源码进行测试封装,并上传到了笔者的GitHub网站上。感兴趣的读者可以访问以下链接查看具体实现:/upcAutoLang/GLCM-OpenCV

2024-11-26 15:101594人浏览

2024-11-26 14:54955人浏览

2024-11-26 14:291814人浏览

2024-11-26 13:54555人浏览

2024-11-26 13:142711人浏览

2024-11-26 12:572420人浏览

1.“OSSD”指什么?2.加加体育安卓版本叫什么名字“OSSD”指什么? OSSD,全称为 "Open Source Sports Directory",中文直译为 "开源体育目录"。这个缩写词

1.如何证明前端页面相同后端源码也相同2.什么是前端源码,什么是后台源码3.hdl_graph_slam|后端优化|hdl_graph_slam_nodelet.cpp|源码解读(四)如何证明前端页面

1.小说网站自动采集小说源码2.最新版PTCMS4.3.0小说源码,PTCMS聚合小说+安装教程-青柠资源网3.小说阅读app源码_小说网站cms源码uniapp+手机+小程序三端)小说网站自动采集小